เรื่อง จุดฝักแค

นิทานเรื่องจริง เรื่อง “จุดฝักแค”

ตอน 1

ตะวันออกกลาง ทำท่าจะเป็นแดนเดือดทั่วทะเลทรายไม่ให้น้อยหน้ากัน เดี๋ยวจะไม่เชื่อว่าเขาจะเอาแต่ปั้ม ไม่เอาคน…

ดูไบ แดนเศรษฐี (หนีคุก) เริ่มฉลองปีใหม่ด้วยไฟใหม้ตึกสูงโรงแรมหรู ระหว่างนับถอยหลังก่อนถึงปีใหม่ เล่นเอาชาวดูไบที่มาดูไฟ ยืนอ้าปากค้าง โห บ้านเรานี่ถ้าจะรวยจริงนะ แทนที่จะจุดพลุขึ้นฟ้าฉลองปีใหม่ นี่เล่นจุดไฟเผาตึกฉลองเลยเหรอ เอะ แล้วไอ้เหลี่ยมร้ายมันอยู่แถวนั้นหรือเปล่านะ ม่ายน่อ เขาว่ามันมาสั่งการกวนตีนลุงตู่ ระหว่างรอรับน้องสาวเตรียมหนีคดีออกนอกประเทศ อยู่ไม่ใกล้ไม่ไกลแถวนี้ต่างหาก

ซีเอนเอน ท่าจะรับค่าอุปถัมภ์รายการไปแยะ ตอนแรกเจ้าหน้าที่ถ่ายถอดทำหน้าที่ตามอาชีพ แบ่งจอให้ดูเลย ด้านซ้ายฉลองปีใหม่ด้วยไฟไหม้ตึก ไฟลุกโชนทั้งตึก มีตัววิ่งขึ้นว่า hotel inferno โรมแรมไฟนรก ด้านขวาของจอถ่ายทอดยิงพลุ เดี๋ยวโป้ง เดี๋ยวโป้ง ข่าวบอก 2 เหตุการณ์ อยู่ห่างกันไม่กี่กิโลเมตร ชาวดูไบ ดูพลุ สลับกับดูไฟไหม้คอเกือบเคล็ด เพราะรัฐบาลดูไบบอก ไฟไหม้ยังไงเราก็ไม่เลิกการจุดพลุให้ประชาชนชื่นชม ให้ตายเถอะโรบิน ผมเชื่อแล้วว่าเขารวยจริง

คุณเบ็กกี้ ผู้จัดรายการสาวใหญ่ ของซีเอนเอน ไม่รู้ใครไปปลุกหล่อนมาเข้าฉากกลางดึก หลังจากพลุเลิกแล้ว แต่ไฟไหม้ยังไม่เลิก คุณเบ็กกี้ประกาศปากคอสั่นว่า ไฟไหม้โรงแรมแค่ข้างนอกนะฮ้า ไม่เข้าข้างในตึกเลยฺฮ่า เสียหายนิดหน่อยเองฮ่ะ ไม่มีใครเป็นอันตรายร้ายแรงเล้ย ว่าแล้วคุณเธอก็หายวับกลับไปนอนต่อ

วาว.. มัน ซี เอน เอน จริงๆ แล้ววันรุ่งขึ้น ข่าวไฟไหม้โรงแรมหรูที่ดูไบก็หายไปเหมือนถูกชักโครกทิ้ง…จะออกข่าวทำไมให้ เสียเวลา มึงไว้ทำข่าวว่ารัสเซียกำลังจะอดตาย จีนแผ่นดินถล่ม ไทยผลิตอาหารไม่ได้มาตรฐาน อะไรทำนองนั้นซีวะ… ผมสงสัยว่า ไอ้คนถ่ายทอดไฟไหม้โรงแรม อาจจะตกงานไปแล้วเรียบร้อย

หลังจากดู ดูไบจุดไฟตึกฉลองปีใหม่เสร็จ ผมก็กลับไปนอนต่อ ผมยังไม่ทันฟื้นจากการนอนข้ามปีของผม ผ่านปีใหม่ไปไม่ถึง 2 วัน ซาอุดิอารเบีย เสี่ยปั๊มใหญ่ของผม ก็เริ่มศักราชใหม่ด้วยการสั่งประหารชีวิตนักโทษ วันเดียวฉับไป 47 หัว ส่วนใหญ่บอกว่าเป็นพวกก่อการร้ายพันธ์อัลไคด้า ที่เคยหาเรื่องซ่าใส่ซาอุ แต่มี 3 คนเป็นรายการแถมนอกเหนือจาก อัลไคด้า

นับเป็นการประหารชีวิตในวันเดียวมากที่สุดในรอบ35 ปีของซาอุ เสี่ยปั๊มใหญ่เล่นแรงจริง สงสัยเจอพิษแมงกะแท้ทะเลทราย

แต่ปรากฏว่ารายการแถม ทำท่าจะเป็นชนวนฝักแค จุดลุกลาม จนตะวันออกกลางอาจจะกลายเป็นทะเลทรายเลือด …. ตามแผนของใครไม่รู้

ชนวนใหญ่ของฟักแคชื่อ Sheik Nimr Baqr al-Nimr ชิ๊ค อัล นิมร์ เป็นผู้สอนศาสนานิกายชีอะที่อยู่ในซาอุ เป็นที่เคารพ และรู้จักกันทั่วของฝ่ายชีอะทั้งในและนอกซาอุดิอารเบีย แต่ซาอุบอกว่า ชิ๊ค อัล นิมร์ เป็นพวกหัวรุนแรง นักเคลื่อนไหวที่ก่อความวุ่นวาย พยายามยุยงให้พวกชีอะก่อความไม่สงบในซาอุ มาตั้งแต่ ปี ค.ศ.2011 แล้วนะ แล้วก็ทำให้ซาอุเกือบจะมีเทศกาลอาหรับสปริงกับเขาด้วยในช่วงปีนั้น ว่าเข้านั้น

การตัดสินประหารชีวิต ชี้ค อัล นิมร์ ได้รับการเตือนจากนานาประเทศทั้งในและตะวันออกกลางว่า ระวังมันจะบานปลายจนหุบไม่เข้า เพราะมันอาจจะมากกว่าเป็นการจุดไฟสงครามระหว่างนิกายศาสนาก็ได้…

แต่ซาอุดิ อารเบียบอกว่า…. อัล นิมร์ คุกคามพระราชวงศ์ของเรา เราต้องการให้เป็นที่รู้กันว่า ใครจะมากดดันเราไม่ได้…..นี่ มันต้องอย่างนี้ มีหน้าไหนกล้าเข้าไปยุ่งในบ้านเขาบ้าง

และก็ได้ผล…กระทรวงต่างประเทศของอเมริกา ไม่ได้ “ทักท้วง” การตัดสินของซาอุดิอารเบียในเรื่องนี้ เพียงแต่ให้ความเห็นว่า อเมริกามีความเป็นห่วงอย่างยิ่งยวดว่า เรื่องนี้จะทำให้การขัดแย้งระหว่างนิกายทางศาสนาจะรุนแรงขึ้น และทางกระทรวง ขอให้ผู้นำภูมิภาค ใช้ความพยายามเป็นสองเท่า ที่จะลดระดับความตึงเครียดในภูมิภาคลงมา

ประชาธิปไตยสักกะบวยอะไรของมึง ฉับหัววันเดียว 47 คน มึงบอกว่า ให้ผู้นำ(คนอื่น) ใช้ความพยายามเป็น 2 เท่าที่จะลดความตึงเครียด แต่กับคนสั่งฉับ มึงไม่กล้าแตะเขาเลย ปาหี่ ฉิบหาย

ตกลงนี่ มันอเมริกาเดียวกันกับที่เข้ามาเสือกในบ้านเราทุกเรื่องหรือเปล่าครับ ที่บ้านเรา ผมเห็นมันมายืนชี้นิ้วเสือกสาระพัด ทั้งๆที่ยังไม่ได้ฉับใครสักหัว แค่เชิญมาปรับทัศนคติ…..มันก็หาว่าเราละเมิดสิทธิมนุษยชน ก็ได้แต่บ่นกันเองหน้าจอ ไหนบอกว่าเป็นช้างศึกไงครับ ไม่ใช่สมันน้อยแล้วนะ ลุงนิทานอย่ามาเรียกสมันน้อยอีกนะ ฮา

############### ตอน 2

ซาอุดิอารเบีย ประหารชีวิต ชิ๊ค อัล นิมร์ เมื่อวันเสาร์ที่ 2 มกราคม หลังจากข่าวออกไม่กี่ชั่วโมง ชาวอิหร่าน ซึ่งนับถืออิสลามนิกายชีอะ ต่างออกมาประท้วงการประหารชีวิต และพากันเดินขบวนไปหน้าสถานทูตซาอุดิอารเบียในกรุงเตหะราน หลังจากนั้นการประท้วงก็รุนแรงขึ้น มีการบุกเข้าไปเผาสถานกงสุลของซาอุดิอารเบีย ที่เมืองมาชาดในอิหร่าน ตามมาด้วยการเผาสถานทูตของซาอุดิอารเบีย ที่กรุงเตหะราน

หลังจากมีข่าวว่า สถานทูตถูกเผาในวันเสาร์ที่ 2 มกราคม วันอาทิตย์รุ่งขึ้น รัฐมนตรีต่างประเทศของซาอุดิอารเบีย นาย Adel al-Jubeir ก็ออกมาทำหน้าเครียดให้สัมภาษณ์ผ่านวิทยุประเภทกรมกร๊วกของซาอุ ทันที

… อิหร่าน มีประวัติการละเมิดต่างประเทศอย่างนี้มานานแล้ว จำไม่ได้หรือ ปี ค.ศ.1979 นั่นไง (ที่อิหร่านบุกสถานทูตอเมริกา และจับตัวเจ้าหน้าที่สถานทูตเป็นตัวประกัน : คนเล่านิทาน) มันแสนจะอื้อฉาว และละเมิดกฎหมายข้อตกลงระหว่างประเทศจนหมดสิ้น….

…. อิหร่าน ยังมีนโยบายที่ก้าวร้าว โดยมีเป้าหมายที่จะทำลายความมั่นคงของภูมิภาค … อิหร่านลักลอบขนทั้งอาวุธ และระเบิด เข้ามาสร้างผู้ก่อการร้ายในซาอุดิอารเบียและประเทศอื่นๆ ในภูมิภาคด้วย… เราจะไม่มีวันยอมให้อิหร่านมาบ่อนทำลายความมั่นคงของเราอย่างเด็ดขาด….

…. ประวัติศาสตร์ของอิหร่าน มีแต่เรื่องแย่ๆ มีแต่เข้าไปแทรกแซงอย่างไม่เป็นมิตร กับประเทศในภูมิภาค และพร้อมที่จะทำลายล้างเขาไปทั่ว รวมทั้งฆ่าคนบริสุทธิ์…

หลังจากด่าอิหร่านอย่างยืดยาว รสเผ็ดเจ็บร้อนถึงใจเสร็จ ท่านรัฐมนตรีต่างประเทศ อัล จูเบียร์ ก็ประกาศตัดสัมพันธ์ทางการทูตดังฉับ …กับอิหร่านทันที พร้อมกับมีคำสั่ง ไล่ทูตอิหร่านประจำซาอุ ให้ออกไปจากซาอุดิอารเบียภายใน 48 ชั่วโมง รวดเร็วชนิดเก็บได้แต่ของสำคัญ เช่นไม้แคะหูกับรองเท้าแตะฯลฯ ที่เหลือทิ้งมันไป…

ซาอุดิ อารเบีย ยังไม่หายร้อน ตามต่อด้วยการสั่งห้ามเครื่องบินอิหร่าน บินลงซาอุ และห้ามเครื่องบินซาอุไปลงอิหร่าน จะเดินทางไปหากันก็จงใช้อูฐอย่างเมื่อร้อยปีก่อน

เด็ดขาดจริงๆ สื่ออเมริกัน ต่างลงข่าวทั้งหมดนี้อย่างพร้อมเพรียง และละเอียดถี่ถ้วน คาดว่า ไม่น่ามีใครตกข่าวเลย คงแจกทั่วถึงกันหมด

หลังจากนั้นเหตุการณ์ต่อเนื่องจากการประหารชีวิต ชิ้ค อัล นิมร์ ก็ลามอย่างรวดเร็ว ไล่ไปตั้งแต่บาห์เรน จนถึง ปากีสถาน เหมือนอย่างกับใครกำลังจุดฟักแคลูกระเบิด หรือฟักแคเผาผี ผมไม่แน่ใจว่าจะเป็นอย่างไหน แต่จะอย่างไหน มันก็ไม่ใช่เป็นมงคล สำหรับการเริ่มปีใหม่ ของชาวตะวันออกกลางทั้งสิ้น

ที่บาห์เรน กลุ่มชีอะ ออกมาประท้วงในหลายเมือง พร้อมทั้งตะโดนด่าราชวงศ์ Al Saud ที่กำลังปกครองซาอุดิอารเบีย ที่ก็ถือว่าเป็นลูกพี่ใหญ่ของบาห์เรน หลังจากนั้น บาห์เรนก็ประกาศตัดสัมพันธ์ทางการทูตกับอิหร่าน ตามลูกพี่ ไปเรียบร้อยอีกหนึ่งฉับ

ตามมาด้วยเอมิเรต ประกาศลดระดับความสัมพันธ์ทางการทูตกับอิหร่าน ลดจำนวนเจ้าหน้าที่สถานทูตของซาอุ ที่ประจำอยู่ที่กรุงเตหะราน เรียกว่ายังไม่ถึงกับฉับ แค่เฉาะให้อิหร่านรู้สึก

ส่วนคูเวต ในฐานะสมาชิกชาวอ่าว ก็รีบตัดฉับสัมพันธ์อิหร่านตามลูกพี่เหมือนกัน

แต่จอร์แดน แค่เรียกทูตอิหร่านประจำจอร์แดนมาด่ายับ เรื่องเหตุการณ์เผาสถานทูตซาอุ แต่ยังไม่ฉับตามซาอุ เพราะจอร์แดนถือตัวว่า ไม่ใช่ลูกกะเป๋งของซาอุ แค่ซาอุช่วยสนับสนุนช่วยเหลือทางการเงินให้เท่านั้น … ฟังแล้วงง

สำหรับการ์ต้า เพิ่งประกาศฉับไปเมื่อวาน เรียกทูตกลับบ้าน ประกาศเป็นรายสุดท้าย แหม นึกว่าแน่ เห็นคิดอยู่หลายวันเลยนะเสี่ยปั้มสิงห์สำอาง ในที่สุดก็ต้องฉับตามลูกพี่

ส่วนโอมาน ประกาศตัวเป็นกลางเหมือนทุกเรื่อง เราไม่ชอบยุ่งกับเรื่องขัดแย้งของใคร แหะ แหะ แต่เราเอนตัวไปทางอิหร่านนานแล้วโยม จ่อหน้ากันอยู่ตรงนั้นมันก็น่าเสียวแทน

การปะทะทางการทูต ลามไปถึงอาฟริกา ซูดาน ซึ่งประชากรส่วนใหญ่เป็นมุสลิมสุนนี่ ก็ไล่ทูตอิหร่านพร้อมเจ้าหน้าที่สถานทูตทั้งหมดกลับบ้านกับเขาด้วย และเรียกทูตของตนที่ประจำอยู่ที่อิหร่านกลับซูดาน

ซูดานแถลงว่า เพราะอิหร่านเข้าไปแทรกแซงในกิจการบ้านคนอื่นเกี่ยวกับเรื่องศาสนา ….รัศมีเสี่ยปั๊มใหญ่นี่แผ่ไพศาลเอาเรื่อง

แต่ที่เบรุต Hassan Nasrallah หัวหน้ากลุ่มเฮสบอลเลาะห์ กล่าวสรรเสริญ ชิ้ค อัล นิมร์ว่า เป็นผู้สละชีวิตเพื่อศาสนา เป็นนักรบที่ควรแก่เคารพ

เหตุการณ์ประหารชีวิตของ ชิ้ค อัล นิมร์ ทำให้ฝ่ายอิหร่านออกมาตอบโต้ว่า ซาอุดิอารเบีย เจ้าจงเตรียมตัว การล้างแค้นอย่างรุนแรงจะต้องเกิดขึ้นอย่างแน่นอน…

############### ตอน 3

ชิ้ค อัล นิมร์ เป็นชาวซาอุดิ ที่นับถืออิสลามนิกายชีอะ ซึ่งมีเพียงประมาณ 15% ในซาอุดิอารเบีย ที่นับนิกายสุนนี่เป็นนิกายทางการ ในขณะที่หัวหน้าชีอะอื่นๆในซาอุ อยู่ในซาอุแบบเจียมตัว พยายามทำตัวคล้อยไปกับสังคมของสุนนี่ แต่ อัล นิมร์ ลุกขึ้นประกาศว่า มันไม่ควรเป็นเช่นนั้น ซาอุดิ อารเบีย ควรใจกว้างกับทุกนิกายเช่นเดียวกัน

อัล นิมร์ พูดแสดงความเห็นเช่นนี้ไปเรื่อยๆ เสียงเขาดังอยู่ในหัวของชีอะเกือบทุกคน โดยเฉพาะที่อยู่ในซาอุดิอารเบีย ในที่สุดเมื่อเกิดเหตุการประท้วงรุนแรงในซาอุดิอารเบีย โดยกลุ่มชีอะ ในปี ค.ศ.2011 ที่ตะวันตกอ้างว่าลามมาจากเทศกาลอาหรับ แต่พวกชีอะบอกว่า เราไม่ได้มาเรียกร้องเอาประซาธิปไตยนะ แต่เราต้องการให้พวกชีอะ ได้รับการปฏิบัติ ที่ดีขึ้นกว่าเดิมในซาอุดิอารเบียต่างหาก แต่รัฐบาลซาอุดิ อารเบีย ใช้ยาแรงในการปราบปรามการประท้วงของพวกชีอะ ด้วยการใช้กระสุนจริง และก็มีชาวซาอุชีอะตายจริงหลายสิบ

ทางการซาอุ สั่งจับ อัล นิมร์ ในปี ค.ศ.2012 และตั้งข้อหาว่า เขาเป็นผู้มีส่วน ที่ทำให้เกิดความไม่สงบดังกล่าว แถมยิงต่อสู้ตำรวจที่มาจับ และพยายามชักชวนให้ต่างชาติเข้ามามีส่วนวุ่นวายในกิจการในประเทศ ว่าแล้วก็มีคำสั่งในปี ค.ศ.2014 ให้ตัดสินประหารชีวิต อัล นิมร์

หลายฝ่ายที่ติดตามเหตุการณ์ของ อัล นิมร์ มาตลอด หวังว่าเขาจะได้รับการอภัยโทษ แต่นอกจากการอภัยโทษไม่เกิดขึ้นแล้ว ยังมีนักวิเคระาห์การเมืองตะวันตก ออกมาให้ความเห็นว่า อัล นิมร์ ติดคุกมาปีกว่า ทำไมถึงมาทำการประหารชีวิตเขาในตอนนี้ เหมือนเป็นการเลือกจังหวะเวลา…

ก่อนสิ้นปี ค.ศ.2015 อเมริกาเคาะถามรัสเซียว่า จะเอาอย่างไรเรื่องซีเรีย สุ่มเสียงอ่อนลงว่า อัสสาดจะอยู่ต่อก็ได้นะ แต่ถ้าเลือกตั้งแพ้แล้วต้องไปนะ รัสเซียบอก เราก็พูดอย่างนี้มาตั้งแต่แรก มึงฟังไม่ได้ศัพท์เลยหรือไง ทำเอาอเมริกากลับไปตั้งหลัก หลังปีใหม่ค่อยมาว่ากันต่อ

ส่วนเรื่องเยเมน ซาอุดิอารเบียนำทัพเข้าไปลุยเยเมน แต่ดันติดหล่มมาตั้งแต่แต่กลางปี ค.ศ.2015 ขึ้นจากหล่มไม่ได้ ไปต่อไม่เป็น เลยมีการเจรจาสงบศึกชั่วคราว แต่การสงบศึกก็ดูเหมือนไม่สงบจริง เพราะยังขึ้นจากหล่มไม่ได้ ติดหล่มทรายนานๆ นี่ถึงตายนะครับ

ที่ซีเรีย มีกองกำลังของจริงของอิหร่าน คอยช่วยอัสสาด รบสู้กับพวกกบฎซีเรีย ขณะเดียวกัน ก็มีกองกำลังของผู้ก่อการร้ายเติมเงิน ที่ซาอุดิอารเบียและพวกคอยสนับสนุนเติมเงินเติมอาวุธ มาช่วยกบฏซีเรียรบสู้ กับรัฐบาลอัสสาด…. มึนหัวแทนคนอ่าน ค่อยๆอ่านนะครับ

ที่เยเมน มีกองกำลังของจริงของซาอุดิอารเบียและพวก กำลังรบกับพวกที่ซาอุ เรียกว่าเป็นกบฏในเยเมน ซึ่งขณะนี้ พวกกบฏ รบชนะฝ่ายรัฐบาลเยเมน และไล่รัฐบาลเยเมนแตกกระเจิง จนตัวนายกรัฐมนตรีเยเมนหนีไปพึ่งใบบุญซาอุดิอารเบีย ฝ่ายกบฏที่กำลังสู้กับกองกำลังซาอุ มีกลุ่มนักรบฮูตติเป็นตัวยืน เป็นฮูตติ ที่อิหร่านให้การสนับสนุนทั้งด้านกองกำลังและอาวุธ

ที่อิรัค มีกองกำลังของชาวอิรัค กำลังรบเพื่อยึดเอาบ้านเมือง กลับคืนมาจากที่ผู้ก่อการร้าย หรือนักรบเติมเงินยึดเอาไว้ และเริ่มตั้งแต่ปลายปีที่แล้วมานี้ ชาวอิรัค ทำท่าจะยึดเมืองใหญ่คืนมาได้ โดยเป็นที่รู้กันดีว่า ฝ่ายรัสเซียอิหร่านให้การสนับสนุนชาวอิรัค ในการยึดเมืองคืน ส่วนซาอุดิอารเบียและพวก รวมทั้งตุรกี และฝ่ายตะวันตก เป็นผู้สนับสนุนพวกนักรบเติมเงิน ในการยึดอิรัคตั้งแต่เริ่ม….

และเมื่ออิรัค เริ่มยึดเมืองกลับคืนได้ อเมริการีบออกมาให้ข่าวทุกวันว่า เป็นผลงานของตน แต่ชาวบ้านที่ติดตามข่าวมาตลอด โดยไม่มีกระป๋องครอบหัวไว้ ก็คงพอรู้ว่าเรื่องจริงเป็นอย่างไร

พวกเขาวุ่นวายกันขนาดนี้ ยังคิดว่า การประหารชีวิต อัล นิมร์ นั้น มาจากการกระทำของอัล นิมร์ ที่ซาอุดิอารเบีย อ้างว่า เป็นการกดดัน และคุกคามราชวงศ์ซาอุด…อย่างนั้นหรือ……

############### ตอน 4 (จบ)

ตั้งแต่กษัตริย์อับดุลลาห์ ขึ้นครองราชย์เมื่อต้นปี ค.ศ.2015 นโยบายด้านต่างประเทศของซาอุดิอารเบีย ดูเหมือนจะเปลี่ยนเป็นเชิงรุก(ราน) อย่างเห็นได้ชัด

แต่ไหนแต่ไรมา ซาอุดิอารเบียกับอิหร่านก็ไม่รักกันอยู่แล้ว ซาอุมองอิหร่านเป็นคู่แข่งทางการเมืองที่สำคัญ แย่งชิงกันเป็นผู้นำของตะวันออกกลางมาตลอด แต่ซาอุดิอารเบีย ย่อมคิดว่าตนเองได้เปรียบอิหร่าน เพราะมีแบ๊กแข็งโป๊กอย่างอเมริกา ส่วนอิหร่าน แม้จะมีรัสเซีย จีน เป็นเพื่อน แต่ในสายตาชาวโลกที่หัวติดอยู่ในกระป๋องสี่เหลี่ยม ย่อมมองรัสเซีย จีน ต่างกับมองเจ้าพ่อใหญ่ใบตองแห้ง

ซาอุดิ อารเบีย มาเสียเส้น ก็ตอนเจ้าพ่อใหญ่ใบตองแห้งใช้เวลาเจรจาเรื่องนิวเคลียร์กับอิหร่านนานไป หน่อย เล่นเอาซาอุดิอารเบียงอนจนเตียงแถบหัก แค่นั้นซาอุดิ อารเบีย ก็ยังลงบัญชีงอนเอาไว้ไม่เลิกพ้อ แต่พอคุณพี่ปูติน ที่เป็นเพื่อนกับอิหร่านและซีเรีย ยกทัพเข้ามาในซีเรีย นี่ 3 เดือนกว่าแล้ว และยังไม่มีที่ท่าว่าจะเคลื่อนย้ายออกไป แถมทำท่าจะปักหลักพักนาน แบบนี้ ซาอุดิ อารเบีย จะใช้แค่บทแง่งอน มันคงไม่พอกระตุกคอคู่รักให้หันมาสนใจ

อเมริกา คู่รักฝักแค ยังไม่แสดงที่ท่าว่าจะกระดิกตัว ออกมาปกป้องฝ่ายซาอุดิจากการบุกมาของรัสเซียเลย ได้แต่ส่งเสียงตามลม โหยหวนเหมือนเวลาเห็นใบตองไหว ก็แค่นั้น แล้วแบบนี้เสี่ยปั๊มใหญ่ จะให้เสี่ยปั๊มใหญ่ถูกหยามหน้าต่อไปได้ยังไง นี่ถ้า รัสเซียไม่ขยับไปไหน นั่งรับลมทะเลทรายเปลี่ยนบรรยากาศไปอีกนาน อิหร่านก็คงใหญ่ขึ้น ใหญ่ขึ้น แถมซีเรีย ที่เราลงทุนเติมเงินลงไปเสียนับไม่ถ้วน ก็ยังไม่ล่ม แค่เละ เจ้าอัสสาดคนนอกศาสนา ก็ยังอยู่ได้ แล้วนี่อิรัคยังมีทีท่าว่า อาจจะไปซบอิหร่านเต็มตัว ยิ่งจะทำให้อิหร่านใหญ่ขึ้นไปอีก โอ้ย… คิดมาถึงตรงนี้แล้ว เสี่ยปั๊มใหญ่ น่าจะรับไม่ไหว มันเลยต้องฉับ ฉับ …

หลังจาก ฉับ ฉับ ไปแล้ว ความร้อนก็ยังไม่ลด ซาอุดิ อารเบีย เลยต้องกระแทกให้อีกดอกว่า …. ถึง จุดนี้ ซาอุดิอารเบีย ไปไกลเกินกว่าที่จะสนใจแล้ว ว่าโอบามาคิดอย่างไร…. ซาอุดิ อารเบีย ไม่สนใจว่าจะทำให้ทำเนียบขาวโกรธหรือไม่… …..พอ ก็คือ พอ enough is enough …..เอะ นี่เป็น ข้อความส่งถึงอิหร่าน หรือถึงอเมริกากันแน่ ผมชักไม่แน่ใจ

บทนี้ ถ้าฮอลลีวู้ด ไม่รีบเอาไปทำหนัง เสียดายตายห่าเลยครับ

ผมเกือบลืมเล่าถึงดาราตัวเอก ที่ตอนนี้ออกฉากมาพูดแทนซาอุดิอารเบียคือนาย อัล จูเบียร์

อัล จูเบียร์ นี่ ก่อนหน้าจะมารับตำแหน่งเป็นรัฐมนตรีต่างประเทศของซาอุดิ เขาเป็น ทูตซาอุ ประจำอเมริกาตั้งแต่ปี ค.ศ.2007 ถึง 2015 เรียกว่า ซี้ย่ำปึกกับอเมริกา มาตั้งแต่สมัยคาวบอยบุช นอกจากนี้ อัล จูเบียร์ ยังเป็นที่ปรึกษาด้านการต่างประเทศประจำตัวของกษัตริย์อับดุลลาห์ อีกด้วย เมื่อเจ้าชายอับดุลลาห์ขึ้นครองราชย์ไม่กี่เดือน ก็ตั้ง อัล จูเบียร์เป็นรัฐมนตรี ดูเหมือนเขาจะเป็นคนธรรมดาคนแรกของซาอุ ที่ได้ดำรงตำแหน่งนี้

ประวัติดาราแบบนี้ คงทำให้มองเห็นภาพกันนะครับว่า ใครกำลังใช้ใคร จุดฝักแค แล้วฝักแคมันจะลามไปถึงไหน แผนเอาปั๊ม ไม่เอาคนนี่เล่นไม่ยากเลย ไม่ว่าที่ไหน เอาของไม่เอาคน ยุซ้าย แยงขวา เดี๋ยวเขาก็ตีกันเอง เราไม่ต้องกรีทาทัพมาให้เจ็บตาปลาเลยนะ จิ้งหรีดพันธุ์ไหน มันก็ปั่นได้ทั้งนั้นแหละ …ถ้ามันไม่รู้ตัวว่าถูกปั่น…

แล้วแบบนี้ฝ่ายรัสเซีย จีน อิหร่าน และไอ้นักไต่ลวดจอมเล่นเสียวตุรกีว่ายังไง ไม่พูดถึงเลยนะลุง

แหม ผมก็ไม่ได้มีโอกาสถามท่านทั้งสาม และนักไต่ลวดโดยตรงนะครับ แต่ผมว่า แผนปั่นจิ้งหรีด แผนจุดฝักแค ใครๆ เขาก็รู้กันทั้งนั้น ก็เล่นแบบซ้ำซาก

ผมเลยเดาเอาเองว่า อิหร่าน คงบอกเราคอยอยู่ ส่วนอาเฮีย คงอมยิ้ม และ คุณพี่ปูติน คงหัวร่อ หึ หึ ใน ลำคอ… ส่วนตุรกีนักไต่ลวด คงถอนหายใจยาว กูคงไม่ตายเดี่ยว….

สวัสดีครับ คนเล่านิทาน 8 ม.ค. 2559

นิทานเรื่องจริง เรื่อง “จุดฝักแค”

ตอน 1

ตะวันออกกลาง ทำท่าจะเป็นแดนเดือดทั่วทะเลทรายไม่ให้น้อยหน้ากัน เดี๋ยวจะไม่เชื่อว่าเขาจะเอาแต่ปั้ม ไม่เอาคน…

ดูไบ แดนเศรษฐี (หนีคุก) เริ่มฉลองปีใหม่ด้วยไฟใหม้ตึกสูงโรงแรมหรู ระหว่างนับถอยหลังก่อนถึงปีใหม่ เล่นเอาชาวดูไบที่มาดูไฟ ยืนอ้าปากค้าง โห บ้านเรานี่ถ้าจะรวยจริงนะ แทนที่จะจุดพลุขึ้นฟ้าฉลองปีใหม่ นี่เล่นจุดไฟเผาตึกฉลองเลยเหรอ เอะ แล้วไอ้เหลี่ยมร้ายมันอยู่แถวนั้นหรือเปล่านะ ม่ายน่อ เขาว่ามันมาสั่งการกวนตีนลุงตู่ ระหว่างรอรับน้องสาวเตรียมหนีคดีออกนอกประเทศ อยู่ไม่ใกล้ไม่ไกลแถวนี้ต่างหาก

ซีเอนเอน ท่าจะรับค่าอุปถัมภ์รายการไปแยะ ตอนแรกเจ้าหน้าที่ถ่ายถอดทำหน้าที่ตามอาชีพ แบ่งจอให้ดูเลย ด้านซ้ายฉลองปีใหม่ด้วยไฟไหม้ตึก ไฟลุกโชนทั้งตึก มีตัววิ่งขึ้นว่า hotel inferno โรมแรมไฟนรก ด้านขวาของจอถ่ายทอดยิงพลุ เดี๋ยวโป้ง เดี๋ยวโป้ง ข่าวบอก 2 เหตุการณ์ อยู่ห่างกันไม่กี่กิโลเมตร ชาวดูไบ ดูพลุ สลับกับดูไฟไหม้คอเกือบเคล็ด เพราะรัฐบาลดูไบบอก ไฟไหม้ยังไงเราก็ไม่เลิกการจุดพลุให้ประชาชนชื่นชม ให้ตายเถอะโรบิน ผมเชื่อแล้วว่าเขารวยจริง

คุณเบ็กกี้ ผู้จัดรายการสาวใหญ่ ของซีเอนเอน ไม่รู้ใครไปปลุกหล่อนมาเข้าฉากกลางดึก หลังจากพลุเลิกแล้ว แต่ไฟไหม้ยังไม่เลิก คุณเบ็กกี้ประกาศปากคอสั่นว่า ไฟไหม้โรงแรมแค่ข้างนอกนะฮ้า ไม่เข้าข้างในตึกเลยฺฮ่า เสียหายนิดหน่อยเองฮ่ะ ไม่มีใครเป็นอันตรายร้ายแรงเล้ย ว่าแล้วคุณเธอก็หายวับกลับไปนอนต่อ

วาว.. มัน ซี เอน เอน จริงๆ แล้ววันรุ่งขึ้น ข่าวไฟไหม้โรงแรมหรูที่ดูไบก็หายไปเหมือนถูกชักโครกทิ้ง…จะออกข่าวทำไมให้ เสียเวลา มึงไว้ทำข่าวว่ารัสเซียกำลังจะอดตาย จีนแผ่นดินถล่ม ไทยผลิตอาหารไม่ได้มาตรฐาน อะไรทำนองนั้นซีวะ… ผมสงสัยว่า ไอ้คนถ่ายทอดไฟไหม้โรงแรม อาจจะตกงานไปแล้วเรียบร้อย

หลังจากดู ดูไบจุดไฟตึกฉลองปีใหม่เสร็จ ผมก็กลับไปนอนต่อ ผมยังไม่ทันฟื้นจากการนอนข้ามปีของผม ผ่านปีใหม่ไปไม่ถึง 2 วัน ซาอุดิอารเบีย เสี่ยปั๊มใหญ่ของผม ก็เริ่มศักราชใหม่ด้วยการสั่งประหารชีวิตนักโทษ วันเดียวฉับไป 47 หัว ส่วนใหญ่บอกว่าเป็นพวกก่อการร้ายพันธ์อัลไคด้า ที่เคยหาเรื่องซ่าใส่ซาอุ แต่มี 3 คนเป็นรายการแถมนอกเหนือจาก อัลไคด้า

นับเป็นการประหารชีวิตในวันเดียวมากที่สุดในรอบ35 ปีของซาอุ เสี่ยปั๊มใหญ่เล่นแรงจริง สงสัยเจอพิษแมงกะแท้ทะเลทราย

แต่ปรากฏว่ารายการแถม ทำท่าจะเป็นชนวนฝักแค จุดลุกลาม จนตะวันออกกลางอาจจะกลายเป็นทะเลทรายเลือด …. ตามแผนของใครไม่รู้

ชนวนใหญ่ของฟักแคชื่อ Sheik Nimr Baqr al-Nimr ชิ๊ค อัล นิมร์ เป็นผู้สอนศาสนานิกายชีอะที่อยู่ในซาอุ เป็นที่เคารพ และรู้จักกันทั่วของฝ่ายชีอะทั้งในและนอกซาอุดิอารเบีย แต่ซาอุบอกว่า ชิ๊ค อัล นิมร์ เป็นพวกหัวรุนแรง นักเคลื่อนไหวที่ก่อความวุ่นวาย พยายามยุยงให้พวกชีอะก่อความไม่สงบในซาอุ มาตั้งแต่ ปี ค.ศ.2011 แล้วนะ แล้วก็ทำให้ซาอุเกือบจะมีเทศกาลอาหรับสปริงกับเขาด้วยในช่วงปีนั้น ว่าเข้านั้น

การตัดสินประหารชีวิต ชี้ค อัล นิมร์ ได้รับการเตือนจากนานาประเทศทั้งในและตะวันออกกลางว่า ระวังมันจะบานปลายจนหุบไม่เข้า เพราะมันอาจจะมากกว่าเป็นการจุดไฟสงครามระหว่างนิกายศาสนาก็ได้…

แต่ซาอุดิ อารเบียบอกว่า…. อัล นิมร์ คุกคามพระราชวงศ์ของเรา เราต้องการให้เป็นที่รู้กันว่า ใครจะมากดดันเราไม่ได้…..นี่ มันต้องอย่างนี้ มีหน้าไหนกล้าเข้าไปยุ่งในบ้านเขาบ้าง

และก็ได้ผล…กระทรวงต่างประเทศของอเมริกา ไม่ได้ “ทักท้วง” การตัดสินของซาอุดิอารเบียในเรื่องนี้ เพียงแต่ให้ความเห็นว่า อเมริกามีความเป็นห่วงอย่างยิ่งยวดว่า เรื่องนี้จะทำให้การขัดแย้งระหว่างนิกายทางศาสนาจะรุนแรงขึ้น และทางกระทรวง ขอให้ผู้นำภูมิภาค ใช้ความพยายามเป็นสองเท่า ที่จะลดระดับความตึงเครียดในภูมิภาคลงมา

ประชาธิปไตยสักกะบวยอะไรของมึง ฉับหัววันเดียว 47 คน มึงบอกว่า ให้ผู้นำ(คนอื่น) ใช้ความพยายามเป็น 2 เท่าที่จะลดความตึงเครียด แต่กับคนสั่งฉับ มึงไม่กล้าแตะเขาเลย ปาหี่ ฉิบหาย

ตกลงนี่ มันอเมริกาเดียวกันกับที่เข้ามาเสือกในบ้านเราทุกเรื่องหรือเปล่าครับ ที่บ้านเรา ผมเห็นมันมายืนชี้นิ้วเสือกสาระพัด ทั้งๆที่ยังไม่ได้ฉับใครสักหัว แค่เชิญมาปรับทัศนคติ…..มันก็หาว่าเราละเมิดสิทธิมนุษยชน ก็ได้แต่บ่นกันเองหน้าจอ ไหนบอกว่าเป็นช้างศึกไงครับ ไม่ใช่สมันน้อยแล้วนะ ลุงนิทานอย่ามาเรียกสมันน้อยอีกนะ ฮา

############### ตอน 2

ซาอุดิอารเบีย ประหารชีวิต ชิ๊ค อัล นิมร์ เมื่อวันเสาร์ที่ 2 มกราคม หลังจากข่าวออกไม่กี่ชั่วโมง ชาวอิหร่าน ซึ่งนับถืออิสลามนิกายชีอะ ต่างออกมาประท้วงการประหารชีวิต และพากันเดินขบวนไปหน้าสถานทูตซาอุดิอารเบียในกรุงเตหะราน หลังจากนั้นการประท้วงก็รุนแรงขึ้น มีการบุกเข้าไปเผาสถานกงสุลของซาอุดิอารเบีย ที่เมืองมาชาดในอิหร่าน ตามมาด้วยการเผาสถานทูตของซาอุดิอารเบีย ที่กรุงเตหะราน

หลังจากมีข่าวว่า สถานทูตถูกเผาในวันเสาร์ที่ 2 มกราคม วันอาทิตย์รุ่งขึ้น รัฐมนตรีต่างประเทศของซาอุดิอารเบีย นาย Adel al-Jubeir ก็ออกมาทำหน้าเครียดให้สัมภาษณ์ผ่านวิทยุประเภทกรมกร๊วกของซาอุ ทันที

… อิหร่าน มีประวัติการละเมิดต่างประเทศอย่างนี้มานานแล้ว จำไม่ได้หรือ ปี ค.ศ.1979 นั่นไง (ที่อิหร่านบุกสถานทูตอเมริกา และจับตัวเจ้าหน้าที่สถานทูตเป็นตัวประกัน : คนเล่านิทาน) มันแสนจะอื้อฉาว และละเมิดกฎหมายข้อตกลงระหว่างประเทศจนหมดสิ้น….

…. อิหร่าน ยังมีนโยบายที่ก้าวร้าว โดยมีเป้าหมายที่จะทำลายความมั่นคงของภูมิภาค … อิหร่านลักลอบขนทั้งอาวุธ และระเบิด เข้ามาสร้างผู้ก่อการร้ายในซาอุดิอารเบียและประเทศอื่นๆ ในภูมิภาคด้วย… เราจะไม่มีวันยอมให้อิหร่านมาบ่อนทำลายความมั่นคงของเราอย่างเด็ดขาด….

…. ประวัติศาสตร์ของอิหร่าน มีแต่เรื่องแย่ๆ มีแต่เข้าไปแทรกแซงอย่างไม่เป็นมิตร กับประเทศในภูมิภาค และพร้อมที่จะทำลายล้างเขาไปทั่ว รวมทั้งฆ่าคนบริสุทธิ์…

หลังจากด่าอิหร่านอย่างยืดยาว รสเผ็ดเจ็บร้อนถึงใจเสร็จ ท่านรัฐมนตรีต่างประเทศ อัล จูเบียร์ ก็ประกาศตัดสัมพันธ์ทางการทูตดังฉับ …กับอิหร่านทันที พร้อมกับมีคำสั่ง ไล่ทูตอิหร่านประจำซาอุ ให้ออกไปจากซาอุดิอารเบียภายใน 48 ชั่วโมง รวดเร็วชนิดเก็บได้แต่ของสำคัญ เช่นไม้แคะหูกับรองเท้าแตะฯลฯ ที่เหลือทิ้งมันไป…

ซาอุดิ อารเบีย ยังไม่หายร้อน ตามต่อด้วยการสั่งห้ามเครื่องบินอิหร่าน บินลงซาอุ และห้ามเครื่องบินซาอุไปลงอิหร่าน จะเดินทางไปหากันก็จงใช้อูฐอย่างเมื่อร้อยปีก่อน

เด็ดขาดจริงๆ สื่ออเมริกัน ต่างลงข่าวทั้งหมดนี้อย่างพร้อมเพรียง และละเอียดถี่ถ้วน คาดว่า ไม่น่ามีใครตกข่าวเลย คงแจกทั่วถึงกันหมด

หลังจากนั้นเหตุการณ์ต่อเนื่องจากการประหารชีวิต ชิ้ค อัล นิมร์ ก็ลามอย่างรวดเร็ว ไล่ไปตั้งแต่บาห์เรน จนถึง ปากีสถาน เหมือนอย่างกับใครกำลังจุดฟักแคลูกระเบิด หรือฟักแคเผาผี ผมไม่แน่ใจว่าจะเป็นอย่างไหน แต่จะอย่างไหน มันก็ไม่ใช่เป็นมงคล สำหรับการเริ่มปีใหม่ ของชาวตะวันออกกลางทั้งสิ้น

ที่บาห์เรน กลุ่มชีอะ ออกมาประท้วงในหลายเมือง พร้อมทั้งตะโดนด่าราชวงศ์ Al Saud ที่กำลังปกครองซาอุดิอารเบีย ที่ก็ถือว่าเป็นลูกพี่ใหญ่ของบาห์เรน หลังจากนั้น บาห์เรนก็ประกาศตัดสัมพันธ์ทางการทูตกับอิหร่าน ตามลูกพี่ ไปเรียบร้อยอีกหนึ่งฉับ

ตามมาด้วยเอมิเรต ประกาศลดระดับความสัมพันธ์ทางการทูตกับอิหร่าน ลดจำนวนเจ้าหน้าที่สถานทูตของซาอุ ที่ประจำอยู่ที่กรุงเตหะราน เรียกว่ายังไม่ถึงกับฉับ แค่เฉาะให้อิหร่านรู้สึก

ส่วนคูเวต ในฐานะสมาชิกชาวอ่าว ก็รีบตัดฉับสัมพันธ์อิหร่านตามลูกพี่เหมือนกัน

แต่จอร์แดน แค่เรียกทูตอิหร่านประจำจอร์แดนมาด่ายับ เรื่องเหตุการณ์เผาสถานทูตซาอุ แต่ยังไม่ฉับตามซาอุ เพราะจอร์แดนถือตัวว่า ไม่ใช่ลูกกะเป๋งของซาอุ แค่ซาอุช่วยสนับสนุนช่วยเหลือทางการเงินให้เท่านั้น … ฟังแล้วงง

สำหรับการ์ต้า เพิ่งประกาศฉับไปเมื่อวาน เรียกทูตกลับบ้าน ประกาศเป็นรายสุดท้าย แหม นึกว่าแน่ เห็นคิดอยู่หลายวันเลยนะเสี่ยปั้มสิงห์สำอาง ในที่สุดก็ต้องฉับตามลูกพี่

ส่วนโอมาน ประกาศตัวเป็นกลางเหมือนทุกเรื่อง เราไม่ชอบยุ่งกับเรื่องขัดแย้งของใคร แหะ แหะ แต่เราเอนตัวไปทางอิหร่านนานแล้วโยม จ่อหน้ากันอยู่ตรงนั้นมันก็น่าเสียวแทน

การปะทะทางการทูต ลามไปถึงอาฟริกา ซูดาน ซึ่งประชากรส่วนใหญ่เป็นมุสลิมสุนนี่ ก็ไล่ทูตอิหร่านพร้อมเจ้าหน้าที่สถานทูตทั้งหมดกลับบ้านกับเขาด้วย และเรียกทูตของตนที่ประจำอยู่ที่อิหร่านกลับซูดาน

ซูดานแถลงว่า เพราะอิหร่านเข้าไปแทรกแซงในกิจการบ้านคนอื่นเกี่ยวกับเรื่องศาสนา ….รัศมีเสี่ยปั๊มใหญ่นี่แผ่ไพศาลเอาเรื่อง

แต่ที่เบรุต Hassan Nasrallah หัวหน้ากลุ่มเฮสบอลเลาะห์ กล่าวสรรเสริญ ชิ้ค อัล นิมร์ว่า เป็นผู้สละชีวิตเพื่อศาสนา เป็นนักรบที่ควรแก่เคารพ

เหตุการณ์ประหารชีวิตของ ชิ้ค อัล นิมร์ ทำให้ฝ่ายอิหร่านออกมาตอบโต้ว่า ซาอุดิอารเบีย เจ้าจงเตรียมตัว การล้างแค้นอย่างรุนแรงจะต้องเกิดขึ้นอย่างแน่นอน…

############### ตอน 3

ชิ้ค อัล นิมร์ เป็นชาวซาอุดิ ที่นับถืออิสลามนิกายชีอะ ซึ่งมีเพียงประมาณ 15% ในซาอุดิอารเบีย ที่นับนิกายสุนนี่เป็นนิกายทางการ ในขณะที่หัวหน้าชีอะอื่นๆในซาอุ อยู่ในซาอุแบบเจียมตัว พยายามทำตัวคล้อยไปกับสังคมของสุนนี่ แต่ อัล นิมร์ ลุกขึ้นประกาศว่า มันไม่ควรเป็นเช่นนั้น ซาอุดิ อารเบีย ควรใจกว้างกับทุกนิกายเช่นเดียวกัน

อัล นิมร์ พูดแสดงความเห็นเช่นนี้ไปเรื่อยๆ เสียงเขาดังอยู่ในหัวของชีอะเกือบทุกคน โดยเฉพาะที่อยู่ในซาอุดิอารเบีย ในที่สุดเมื่อเกิดเหตุการประท้วงรุนแรงในซาอุดิอารเบีย โดยกลุ่มชีอะ ในปี ค.ศ.2011 ที่ตะวันตกอ้างว่าลามมาจากเทศกาลอาหรับ แต่พวกชีอะบอกว่า เราไม่ได้มาเรียกร้องเอาประซาธิปไตยนะ แต่เราต้องการให้พวกชีอะ ได้รับการปฏิบัติ ที่ดีขึ้นกว่าเดิมในซาอุดิอารเบียต่างหาก แต่รัฐบาลซาอุดิ อารเบีย ใช้ยาแรงในการปราบปรามการประท้วงของพวกชีอะ ด้วยการใช้กระสุนจริง และก็มีชาวซาอุชีอะตายจริงหลายสิบ

ทางการซาอุ สั่งจับ อัล นิมร์ ในปี ค.ศ.2012 และตั้งข้อหาว่า เขาเป็นผู้มีส่วน ที่ทำให้เกิดความไม่สงบดังกล่าว แถมยิงต่อสู้ตำรวจที่มาจับ และพยายามชักชวนให้ต่างชาติเข้ามามีส่วนวุ่นวายในกิจการในประเทศ ว่าแล้วก็มีคำสั่งในปี ค.ศ.2014 ให้ตัดสินประหารชีวิต อัล นิมร์

หลายฝ่ายที่ติดตามเหตุการณ์ของ อัล นิมร์ มาตลอด หวังว่าเขาจะได้รับการอภัยโทษ แต่นอกจากการอภัยโทษไม่เกิดขึ้นแล้ว ยังมีนักวิเคระาห์การเมืองตะวันตก ออกมาให้ความเห็นว่า อัล นิมร์ ติดคุกมาปีกว่า ทำไมถึงมาทำการประหารชีวิตเขาในตอนนี้ เหมือนเป็นการเลือกจังหวะเวลา…

ก่อนสิ้นปี ค.ศ.2015 อเมริกาเคาะถามรัสเซียว่า จะเอาอย่างไรเรื่องซีเรีย สุ่มเสียงอ่อนลงว่า อัสสาดจะอยู่ต่อก็ได้นะ แต่ถ้าเลือกตั้งแพ้แล้วต้องไปนะ รัสเซียบอก เราก็พูดอย่างนี้มาตั้งแต่แรก มึงฟังไม่ได้ศัพท์เลยหรือไง ทำเอาอเมริกากลับไปตั้งหลัก หลังปีใหม่ค่อยมาว่ากันต่อ

ส่วนเรื่องเยเมน ซาอุดิอารเบียนำทัพเข้าไปลุยเยเมน แต่ดันติดหล่มมาตั้งแต่แต่กลางปี ค.ศ.2015 ขึ้นจากหล่มไม่ได้ ไปต่อไม่เป็น เลยมีการเจรจาสงบศึกชั่วคราว แต่การสงบศึกก็ดูเหมือนไม่สงบจริง เพราะยังขึ้นจากหล่มไม่ได้ ติดหล่มทรายนานๆ นี่ถึงตายนะครับ

ที่ซีเรีย มีกองกำลังของจริงของอิหร่าน คอยช่วยอัสสาด รบสู้กับพวกกบฎซีเรีย ขณะเดียวกัน ก็มีกองกำลังของผู้ก่อการร้ายเติมเงิน ที่ซาอุดิอารเบียและพวกคอยสนับสนุนเติมเงินเติมอาวุธ มาช่วยกบฏซีเรียรบสู้ กับรัฐบาลอัสสาด…. มึนหัวแทนคนอ่าน ค่อยๆอ่านนะครับ

ที่เยเมน มีกองกำลังของจริงของซาอุดิอารเบียและพวก กำลังรบกับพวกที่ซาอุ เรียกว่าเป็นกบฏในเยเมน ซึ่งขณะนี้ พวกกบฏ รบชนะฝ่ายรัฐบาลเยเมน และไล่รัฐบาลเยเมนแตกกระเจิง จนตัวนายกรัฐมนตรีเยเมนหนีไปพึ่งใบบุญซาอุดิอารเบีย ฝ่ายกบฏที่กำลังสู้กับกองกำลังซาอุ มีกลุ่มนักรบฮูตติเป็นตัวยืน เป็นฮูตติ ที่อิหร่านให้การสนับสนุนทั้งด้านกองกำลังและอาวุธ

ที่อิรัค มีกองกำลังของชาวอิรัค กำลังรบเพื่อยึดเอาบ้านเมือง กลับคืนมาจากที่ผู้ก่อการร้าย หรือนักรบเติมเงินยึดเอาไว้ และเริ่มตั้งแต่ปลายปีที่แล้วมานี้ ชาวอิรัค ทำท่าจะยึดเมืองใหญ่คืนมาได้ โดยเป็นที่รู้กันดีว่า ฝ่ายรัสเซียอิหร่านให้การสนับสนุนชาวอิรัค ในการยึดเมืองคืน ส่วนซาอุดิอารเบียและพวก รวมทั้งตุรกี และฝ่ายตะวันตก เป็นผู้สนับสนุนพวกนักรบเติมเงิน ในการยึดอิรัคตั้งแต่เริ่ม….

และเมื่ออิรัค เริ่มยึดเมืองกลับคืนได้ อเมริการีบออกมาให้ข่าวทุกวันว่า เป็นผลงานของตน แต่ชาวบ้านที่ติดตามข่าวมาตลอด โดยไม่มีกระป๋องครอบหัวไว้ ก็คงพอรู้ว่าเรื่องจริงเป็นอย่างไร

พวกเขาวุ่นวายกันขนาดนี้ ยังคิดว่า การประหารชีวิต อัล นิมร์ นั้น มาจากการกระทำของอัล นิมร์ ที่ซาอุดิอารเบีย อ้างว่า เป็นการกดดัน และคุกคามราชวงศ์ซาอุด…อย่างนั้นหรือ……

############### ตอน 4 (จบ)

ตั้งแต่กษัตริย์อับดุลลาห์ ขึ้นครองราชย์เมื่อต้นปี ค.ศ.2015 นโยบายด้านต่างประเทศของซาอุดิอารเบีย ดูเหมือนจะเปลี่ยนเป็นเชิงรุก(ราน) อย่างเห็นได้ชัด

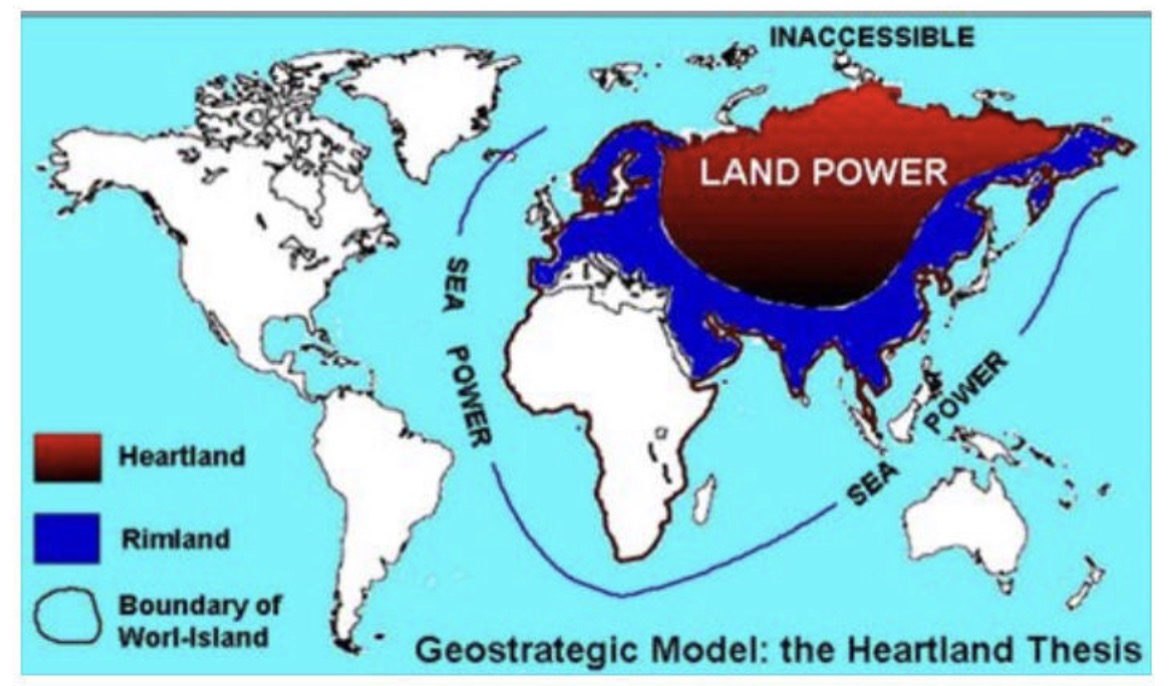

แต่ไหนแต่ไรมา ซาอุดิอารเบียกับอิหร่านก็ไม่รักกันอยู่แล้ว ซาอุมองอิหร่านเป็นคู่แข่งทางการเมืองที่สำคัญ แย่งชิงกันเป็นผู้นำของตะวันออกกลางมาตลอด แต่ซาอุดิอารเบีย ย่อมคิดว่าตนเองได้เปรียบอิหร่าน เพราะมีแบ๊กแข็งโป๊กอย่างอเมริกา ส่วนอิหร่าน แม้จะมีรัสเซีย จีน เป็นเพื่อน แต่ในสายตาชาวโลกที่หัวติดอยู่ในกระป๋องสี่เหลี่ยม ย่อมมองรัสเซีย จีน ต่างกับมองเจ้าพ่อใหญ่ใบตองแห้ง

ซาอุดิ อารเบีย มาเสียเส้น ก็ตอนเจ้าพ่อใหญ่ใบตองแห้งใช้เวลาเจรจาเรื่องนิวเคลียร์กับอิหร่านนานไป หน่อย เล่นเอาซาอุดิอารเบียงอนจนเตียงแถบหัก แค่นั้นซาอุดิ อารเบีย ก็ยังลงบัญชีงอนเอาไว้ไม่เลิกพ้อ แต่พอคุณพี่ปูติน ที่เป็นเพื่อนกับอิหร่านและซีเรีย ยกทัพเข้ามาในซีเรีย นี่ 3 เดือนกว่าแล้ว และยังไม่มีที่ท่าว่าจะเคลื่อนย้ายออกไป แถมทำท่าจะปักหลักพักนาน แบบนี้ ซาอุดิ อารเบีย จะใช้แค่บทแง่งอน มันคงไม่พอกระตุกคอคู่รักให้หันมาสนใจ

อเมริกา คู่รักฝักแค ยังไม่แสดงที่ท่าว่าจะกระดิกตัว ออกมาปกป้องฝ่ายซาอุดิจากการบุกมาของรัสเซียเลย ได้แต่ส่งเสียงตามลม โหยหวนเหมือนเวลาเห็นใบตองไหว ก็แค่นั้น แล้วแบบนี้เสี่ยปั๊มใหญ่ จะให้เสี่ยปั๊มใหญ่ถูกหยามหน้าต่อไปได้ยังไง นี่ถ้า รัสเซียไม่ขยับไปไหน นั่งรับลมทะเลทรายเปลี่ยนบรรยากาศไปอีกนาน อิหร่านก็คงใหญ่ขึ้น ใหญ่ขึ้น แถมซีเรีย ที่เราลงทุนเติมเงินลงไปเสียนับไม่ถ้วน ก็ยังไม่ล่ม แค่เละ เจ้าอัสสาดคนนอกศาสนา ก็ยังอยู่ได้ แล้วนี่อิรัคยังมีทีท่าว่า อาจจะไปซบอิหร่านเต็มตัว ยิ่งจะทำให้อิหร่านใหญ่ขึ้นไปอีก โอ้ย… คิดมาถึงตรงนี้แล้ว เสี่ยปั๊มใหญ่ น่าจะรับไม่ไหว มันเลยต้องฉับ ฉับ …

หลังจาก ฉับ ฉับ ไปแล้ว ความร้อนก็ยังไม่ลด ซาอุดิ อารเบีย เลยต้องกระแทกให้อีกดอกว่า …. ถึง จุดนี้ ซาอุดิอารเบีย ไปไกลเกินกว่าที่จะสนใจแล้ว ว่าโอบามาคิดอย่างไร…. ซาอุดิ อารเบีย ไม่สนใจว่าจะทำให้ทำเนียบขาวโกรธหรือไม่… …..พอ ก็คือ พอ enough is enough …..เอะ นี่เป็น ข้อความส่งถึงอิหร่าน หรือถึงอเมริกากันแน่ ผมชักไม่แน่ใจ

บทนี้ ถ้าฮอลลีวู้ด ไม่รีบเอาไปทำหนัง เสียดายตายห่าเลยครับ

ผมเกือบลืมเล่าถึงดาราตัวเอก ที่ตอนนี้ออกฉากมาพูดแทนซาอุดิอารเบียคือนาย อัล จูเบียร์

อัล จูเบียร์ นี่ ก่อนหน้าจะมารับตำแหน่งเป็นรัฐมนตรีต่างประเทศของซาอุดิ เขาเป็น ทูตซาอุ ประจำอเมริกาตั้งแต่ปี ค.ศ.2007 ถึง 2015 เรียกว่า ซี้ย่ำปึกกับอเมริกา มาตั้งแต่สมัยคาวบอยบุช นอกจากนี้ อัล จูเบียร์ ยังเป็นที่ปรึกษาด้านการต่างประเทศประจำตัวของกษัตริย์อับดุลลาห์ อีกด้วย เมื่อเจ้าชายอับดุลลาห์ขึ้นครองราชย์ไม่กี่เดือน ก็ตั้ง อัล จูเบียร์เป็นรัฐมนตรี ดูเหมือนเขาจะเป็นคนธรรมดาคนแรกของซาอุ ที่ได้ดำรงตำแหน่งนี้

ประวัติดาราแบบนี้ คงทำให้มองเห็นภาพกันนะครับว่า ใครกำลังใช้ใคร จุดฝักแค แล้วฝักแคมันจะลามไปถึงไหน แผนเอาปั๊ม ไม่เอาคนนี่เล่นไม่ยากเลย ไม่ว่าที่ไหน เอาของไม่เอาคน ยุซ้าย แยงขวา เดี๋ยวเขาก็ตีกันเอง เราไม่ต้องกรีทาทัพมาให้เจ็บตาปลาเลยนะ จิ้งหรีดพันธุ์ไหน มันก็ปั่นได้ทั้งนั้นแหละ …ถ้ามันไม่รู้ตัวว่าถูกปั่น…

แล้วแบบนี้ฝ่ายรัสเซีย จีน อิหร่าน และไอ้นักไต่ลวดจอมเล่นเสียวตุรกีว่ายังไง ไม่พูดถึงเลยนะลุง

แหม ผมก็ไม่ได้มีโอกาสถามท่านทั้งสาม และนักไต่ลวดโดยตรงนะครับ แต่ผมว่า แผนปั่นจิ้งหรีด แผนจุดฝักแค ใครๆ เขาก็รู้กันทั้งนั้น ก็เล่นแบบซ้ำซาก

ผมเลยเดาเอาเองว่า อิหร่าน คงบอกเราคอยอยู่ ส่วนอาเฮีย คงอมยิ้ม และ คุณพี่ปูติน คงหัวร่อ หึ หึ ใน ลำคอ… ส่วนตุรกีนักไต่ลวด คงถอนหายใจยาว กูคงไม่ตายเดี่ยว….

สวัสดีครับ คนเล่านิทาน 8 ม.ค. 2559

เรื่อง จุดฝักแค

นิทานเรื่องจริง เรื่อง “จุดฝักแค”

ตอน 1

ตะวันออกกลาง ทำท่าจะเป็นแดนเดือดทั่วทะเลทรายไม่ให้น้อยหน้ากัน เดี๋ยวจะไม่เชื่อว่าเขาจะเอาแต่ปั้ม ไม่เอาคน…

ดูไบ แดนเศรษฐี (หนีคุก) เริ่มฉลองปีใหม่ด้วยไฟใหม้ตึกสูงโรงแรมหรู ระหว่างนับถอยหลังก่อนถึงปีใหม่ เล่นเอาชาวดูไบที่มาดูไฟ ยืนอ้าปากค้าง โห บ้านเรานี่ถ้าจะรวยจริงนะ แทนที่จะจุดพลุขึ้นฟ้าฉลองปีใหม่ นี่เล่นจุดไฟเผาตึกฉลองเลยเหรอ เอะ แล้วไอ้เหลี่ยมร้ายมันอยู่แถวนั้นหรือเปล่านะ ม่ายน่อ เขาว่ามันมาสั่งการกวนตีนลุงตู่ ระหว่างรอรับน้องสาวเตรียมหนีคดีออกนอกประเทศ อยู่ไม่ใกล้ไม่ไกลแถวนี้ต่างหาก

ซีเอนเอน ท่าจะรับค่าอุปถัมภ์รายการไปแยะ ตอนแรกเจ้าหน้าที่ถ่ายถอดทำหน้าที่ตามอาชีพ แบ่งจอให้ดูเลย ด้านซ้ายฉลองปีใหม่ด้วยไฟไหม้ตึก ไฟลุกโชนทั้งตึก มีตัววิ่งขึ้นว่า hotel inferno โรมแรมไฟนรก ด้านขวาของจอถ่ายทอดยิงพลุ เดี๋ยวโป้ง เดี๋ยวโป้ง ข่าวบอก 2 เหตุการณ์ อยู่ห่างกันไม่กี่กิโลเมตร ชาวดูไบ ดูพลุ สลับกับดูไฟไหม้คอเกือบเคล็ด เพราะรัฐบาลดูไบบอก ไฟไหม้ยังไงเราก็ไม่เลิกการจุดพลุให้ประชาชนชื่นชม ให้ตายเถอะโรบิน ผมเชื่อแล้วว่าเขารวยจริง

คุณเบ็กกี้ ผู้จัดรายการสาวใหญ่ ของซีเอนเอน ไม่รู้ใครไปปลุกหล่อนมาเข้าฉากกลางดึก หลังจากพลุเลิกแล้ว แต่ไฟไหม้ยังไม่เลิก คุณเบ็กกี้ประกาศปากคอสั่นว่า ไฟไหม้โรงแรมแค่ข้างนอกนะฮ้า ไม่เข้าข้างในตึกเลยฺฮ่า เสียหายนิดหน่อยเองฮ่ะ ไม่มีใครเป็นอันตรายร้ายแรงเล้ย ว่าแล้วคุณเธอก็หายวับกลับไปนอนต่อ

วาว.. มัน ซี เอน เอน จริงๆ แล้ววันรุ่งขึ้น ข่าวไฟไหม้โรงแรมหรูที่ดูไบก็หายไปเหมือนถูกชักโครกทิ้ง…จะออกข่าวทำไมให้ เสียเวลา มึงไว้ทำข่าวว่ารัสเซียกำลังจะอดตาย จีนแผ่นดินถล่ม ไทยผลิตอาหารไม่ได้มาตรฐาน อะไรทำนองนั้นซีวะ… ผมสงสัยว่า ไอ้คนถ่ายทอดไฟไหม้โรงแรม อาจจะตกงานไปแล้วเรียบร้อย

หลังจากดู ดูไบจุดไฟตึกฉลองปีใหม่เสร็จ ผมก็กลับไปนอนต่อ ผมยังไม่ทันฟื้นจากการนอนข้ามปีของผม ผ่านปีใหม่ไปไม่ถึง 2 วัน ซาอุดิอารเบีย เสี่ยปั๊มใหญ่ของผม ก็เริ่มศักราชใหม่ด้วยการสั่งประหารชีวิตนักโทษ วันเดียวฉับไป 47 หัว ส่วนใหญ่บอกว่าเป็นพวกก่อการร้ายพันธ์อัลไคด้า ที่เคยหาเรื่องซ่าใส่ซาอุ แต่มี 3 คนเป็นรายการแถมนอกเหนือจาก อัลไคด้า

นับเป็นการประหารชีวิตในวันเดียวมากที่สุดในรอบ35 ปีของซาอุ เสี่ยปั๊มใหญ่เล่นแรงจริง สงสัยเจอพิษแมงกะแท้ทะเลทราย

แต่ปรากฏว่ารายการแถม ทำท่าจะเป็นชนวนฝักแค จุดลุกลาม จนตะวันออกกลางอาจจะกลายเป็นทะเลทรายเลือด …. ตามแผนของใครไม่รู้

ชนวนใหญ่ของฟักแคชื่อ Sheik Nimr Baqr al-Nimr ชิ๊ค อัล นิมร์ เป็นผู้สอนศาสนานิกายชีอะที่อยู่ในซาอุ เป็นที่เคารพ และรู้จักกันทั่วของฝ่ายชีอะทั้งในและนอกซาอุดิอารเบีย แต่ซาอุบอกว่า ชิ๊ค อัล นิมร์ เป็นพวกหัวรุนแรง นักเคลื่อนไหวที่ก่อความวุ่นวาย พยายามยุยงให้พวกชีอะก่อความไม่สงบในซาอุ มาตั้งแต่ ปี ค.ศ.2011 แล้วนะ แล้วก็ทำให้ซาอุเกือบจะมีเทศกาลอาหรับสปริงกับเขาด้วยในช่วงปีนั้น ว่าเข้านั้น

การตัดสินประหารชีวิต ชี้ค อัล นิมร์ ได้รับการเตือนจากนานาประเทศทั้งในและตะวันออกกลางว่า ระวังมันจะบานปลายจนหุบไม่เข้า เพราะมันอาจจะมากกว่าเป็นการจุดไฟสงครามระหว่างนิกายศาสนาก็ได้…

แต่ซาอุดิ อารเบียบอกว่า…. อัล นิมร์ คุกคามพระราชวงศ์ของเรา เราต้องการให้เป็นที่รู้กันว่า ใครจะมากดดันเราไม่ได้…..นี่ มันต้องอย่างนี้ มีหน้าไหนกล้าเข้าไปยุ่งในบ้านเขาบ้าง

และก็ได้ผล…กระทรวงต่างประเทศของอเมริกา ไม่ได้ “ทักท้วง” การตัดสินของซาอุดิอารเบียในเรื่องนี้ เพียงแต่ให้ความเห็นว่า อเมริกามีความเป็นห่วงอย่างยิ่งยวดว่า เรื่องนี้จะทำให้การขัดแย้งระหว่างนิกายทางศาสนาจะรุนแรงขึ้น และทางกระทรวง ขอให้ผู้นำภูมิภาค ใช้ความพยายามเป็นสองเท่า ที่จะลดระดับความตึงเครียดในภูมิภาคลงมา

ประชาธิปไตยสักกะบวยอะไรของมึง ฉับหัววันเดียว 47 คน มึงบอกว่า ให้ผู้นำ(คนอื่น) ใช้ความพยายามเป็น 2 เท่าที่จะลดความตึงเครียด แต่กับคนสั่งฉับ มึงไม่กล้าแตะเขาเลย ปาหี่ ฉิบหาย

ตกลงนี่ มันอเมริกาเดียวกันกับที่เข้ามาเสือกในบ้านเราทุกเรื่องหรือเปล่าครับ

ที่บ้านเรา ผมเห็นมันมายืนชี้นิ้วเสือกสาระพัด ทั้งๆที่ยังไม่ได้ฉับใครสักหัว แค่เชิญมาปรับทัศนคติ…..มันก็หาว่าเราละเมิดสิทธิมนุษยชน ก็ได้แต่บ่นกันเองหน้าจอ ไหนบอกว่าเป็นช้างศึกไงครับ ไม่ใช่สมันน้อยแล้วนะ ลุงนิทานอย่ามาเรียกสมันน้อยอีกนะ ฮา

###############

ตอน 2

ซาอุดิอารเบีย ประหารชีวิต ชิ๊ค อัล นิมร์ เมื่อวันเสาร์ที่ 2 มกราคม หลังจากข่าวออกไม่กี่ชั่วโมง ชาวอิหร่าน ซึ่งนับถืออิสลามนิกายชีอะ ต่างออกมาประท้วงการประหารชีวิต และพากันเดินขบวนไปหน้าสถานทูตซาอุดิอารเบียในกรุงเตหะราน หลังจากนั้นการประท้วงก็รุนแรงขึ้น มีการบุกเข้าไปเผาสถานกงสุลของซาอุดิอารเบีย ที่เมืองมาชาดในอิหร่าน ตามมาด้วยการเผาสถานทูตของซาอุดิอารเบีย ที่กรุงเตหะราน

หลังจากมีข่าวว่า สถานทูตถูกเผาในวันเสาร์ที่ 2 มกราคม วันอาทิตย์รุ่งขึ้น รัฐมนตรีต่างประเทศของซาอุดิอารเบีย นาย Adel al-Jubeir ก็ออกมาทำหน้าเครียดให้สัมภาษณ์ผ่านวิทยุประเภทกรมกร๊วกของซาอุ ทันที

… อิหร่าน มีประวัติการละเมิดต่างประเทศอย่างนี้มานานแล้ว จำไม่ได้หรือ ปี ค.ศ.1979 นั่นไง (ที่อิหร่านบุกสถานทูตอเมริกา และจับตัวเจ้าหน้าที่สถานทูตเป็นตัวประกัน : คนเล่านิทาน) มันแสนจะอื้อฉาว และละเมิดกฎหมายข้อตกลงระหว่างประเทศจนหมดสิ้น….

…. อิหร่าน ยังมีนโยบายที่ก้าวร้าว โดยมีเป้าหมายที่จะทำลายความมั่นคงของภูมิภาค … อิหร่านลักลอบขนทั้งอาวุธ และระเบิด เข้ามาสร้างผู้ก่อการร้ายในซาอุดิอารเบียและประเทศอื่นๆ ในภูมิภาคด้วย… เราจะไม่มีวันยอมให้อิหร่านมาบ่อนทำลายความมั่นคงของเราอย่างเด็ดขาด….

…. ประวัติศาสตร์ของอิหร่าน มีแต่เรื่องแย่ๆ มีแต่เข้าไปแทรกแซงอย่างไม่เป็นมิตร กับประเทศในภูมิภาค และพร้อมที่จะทำลายล้างเขาไปทั่ว รวมทั้งฆ่าคนบริสุทธิ์…

หลังจากด่าอิหร่านอย่างยืดยาว รสเผ็ดเจ็บร้อนถึงใจเสร็จ ท่านรัฐมนตรีต่างประเทศ อัล จูเบียร์ ก็ประกาศตัดสัมพันธ์ทางการทูตดังฉับ …กับอิหร่านทันที พร้อมกับมีคำสั่ง ไล่ทูตอิหร่านประจำซาอุ ให้ออกไปจากซาอุดิอารเบียภายใน 48 ชั่วโมง รวดเร็วชนิดเก็บได้แต่ของสำคัญ เช่นไม้แคะหูกับรองเท้าแตะฯลฯ ที่เหลือทิ้งมันไป…

ซาอุดิ อารเบีย ยังไม่หายร้อน ตามต่อด้วยการสั่งห้ามเครื่องบินอิหร่าน บินลงซาอุ และห้ามเครื่องบินซาอุไปลงอิหร่าน จะเดินทางไปหากันก็จงใช้อูฐอย่างเมื่อร้อยปีก่อน

เด็ดขาดจริงๆ สื่ออเมริกัน ต่างลงข่าวทั้งหมดนี้อย่างพร้อมเพรียง และละเอียดถี่ถ้วน คาดว่า ไม่น่ามีใครตกข่าวเลย คงแจกทั่วถึงกันหมด

หลังจากนั้นเหตุการณ์ต่อเนื่องจากการประหารชีวิต ชิ้ค อัล นิมร์ ก็ลามอย่างรวดเร็ว ไล่ไปตั้งแต่บาห์เรน จนถึง ปากีสถาน เหมือนอย่างกับใครกำลังจุดฟักแคลูกระเบิด หรือฟักแคเผาผี ผมไม่แน่ใจว่าจะเป็นอย่างไหน แต่จะอย่างไหน มันก็ไม่ใช่เป็นมงคล สำหรับการเริ่มปีใหม่ ของชาวตะวันออกกลางทั้งสิ้น

ที่บาห์เรน กลุ่มชีอะ ออกมาประท้วงในหลายเมือง พร้อมทั้งตะโดนด่าราชวงศ์ Al Saud ที่กำลังปกครองซาอุดิอารเบีย ที่ก็ถือว่าเป็นลูกพี่ใหญ่ของบาห์เรน หลังจากนั้น บาห์เรนก็ประกาศตัดสัมพันธ์ทางการทูตกับอิหร่าน ตามลูกพี่ ไปเรียบร้อยอีกหนึ่งฉับ

ตามมาด้วยเอมิเรต ประกาศลดระดับความสัมพันธ์ทางการทูตกับอิหร่าน ลดจำนวนเจ้าหน้าที่สถานทูตของซาอุ ที่ประจำอยู่ที่กรุงเตหะราน เรียกว่ายังไม่ถึงกับฉับ แค่เฉาะให้อิหร่านรู้สึก

ส่วนคูเวต ในฐานะสมาชิกชาวอ่าว ก็รีบตัดฉับสัมพันธ์อิหร่านตามลูกพี่เหมือนกัน

แต่จอร์แดน แค่เรียกทูตอิหร่านประจำจอร์แดนมาด่ายับ เรื่องเหตุการณ์เผาสถานทูตซาอุ แต่ยังไม่ฉับตามซาอุ เพราะจอร์แดนถือตัวว่า ไม่ใช่ลูกกะเป๋งของซาอุ แค่ซาอุช่วยสนับสนุนช่วยเหลือทางการเงินให้เท่านั้น … ฟังแล้วงง

สำหรับการ์ต้า เพิ่งประกาศฉับไปเมื่อวาน เรียกทูตกลับบ้าน ประกาศเป็นรายสุดท้าย แหม นึกว่าแน่ เห็นคิดอยู่หลายวันเลยนะเสี่ยปั้มสิงห์สำอาง ในที่สุดก็ต้องฉับตามลูกพี่

ส่วนโอมาน ประกาศตัวเป็นกลางเหมือนทุกเรื่อง เราไม่ชอบยุ่งกับเรื่องขัดแย้งของใคร แหะ แหะ แต่เราเอนตัวไปทางอิหร่านนานแล้วโยม จ่อหน้ากันอยู่ตรงนั้นมันก็น่าเสียวแทน

การปะทะทางการทูต ลามไปถึงอาฟริกา ซูดาน ซึ่งประชากรส่วนใหญ่เป็นมุสลิมสุนนี่ ก็ไล่ทูตอิหร่านพร้อมเจ้าหน้าที่สถานทูตทั้งหมดกลับบ้านกับเขาด้วย และเรียกทูตของตนที่ประจำอยู่ที่อิหร่านกลับซูดาน

ซูดานแถลงว่า เพราะอิหร่านเข้าไปแทรกแซงในกิจการบ้านคนอื่นเกี่ยวกับเรื่องศาสนา ….รัศมีเสี่ยปั๊มใหญ่นี่แผ่ไพศาลเอาเรื่อง

แต่ที่เบรุต Hassan Nasrallah หัวหน้ากลุ่มเฮสบอลเลาะห์ กล่าวสรรเสริญ ชิ้ค อัล นิมร์ว่า เป็นผู้สละชีวิตเพื่อศาสนา เป็นนักรบที่ควรแก่เคารพ

เหตุการณ์ประหารชีวิตของ ชิ้ค อัล นิมร์ ทำให้ฝ่ายอิหร่านออกมาตอบโต้ว่า ซาอุดิอารเบีย เจ้าจงเตรียมตัว การล้างแค้นอย่างรุนแรงจะต้องเกิดขึ้นอย่างแน่นอน…

###############

ตอน 3

ชิ้ค อัล นิมร์ เป็นชาวซาอุดิ ที่นับถืออิสลามนิกายชีอะ ซึ่งมีเพียงประมาณ 15% ในซาอุดิอารเบีย ที่นับนิกายสุนนี่เป็นนิกายทางการ ในขณะที่หัวหน้าชีอะอื่นๆในซาอุ อยู่ในซาอุแบบเจียมตัว พยายามทำตัวคล้อยไปกับสังคมของสุนนี่ แต่ อัล นิมร์ ลุกขึ้นประกาศว่า มันไม่ควรเป็นเช่นนั้น ซาอุดิ อารเบีย ควรใจกว้างกับทุกนิกายเช่นเดียวกัน

อัล นิมร์ พูดแสดงความเห็นเช่นนี้ไปเรื่อยๆ เสียงเขาดังอยู่ในหัวของชีอะเกือบทุกคน โดยเฉพาะที่อยู่ในซาอุดิอารเบีย ในที่สุดเมื่อเกิดเหตุการประท้วงรุนแรงในซาอุดิอารเบีย โดยกลุ่มชีอะ ในปี ค.ศ.2011 ที่ตะวันตกอ้างว่าลามมาจากเทศกาลอาหรับ แต่พวกชีอะบอกว่า เราไม่ได้มาเรียกร้องเอาประซาธิปไตยนะ แต่เราต้องการให้พวกชีอะ ได้รับการปฏิบัติ ที่ดีขึ้นกว่าเดิมในซาอุดิอารเบียต่างหาก แต่รัฐบาลซาอุดิ อารเบีย ใช้ยาแรงในการปราบปรามการประท้วงของพวกชีอะ ด้วยการใช้กระสุนจริง และก็มีชาวซาอุชีอะตายจริงหลายสิบ

ทางการซาอุ สั่งจับ อัล นิมร์ ในปี ค.ศ.2012 และตั้งข้อหาว่า เขาเป็นผู้มีส่วน ที่ทำให้เกิดความไม่สงบดังกล่าว แถมยิงต่อสู้ตำรวจที่มาจับ และพยายามชักชวนให้ต่างชาติเข้ามามีส่วนวุ่นวายในกิจการในประเทศ ว่าแล้วก็มีคำสั่งในปี ค.ศ.2014 ให้ตัดสินประหารชีวิต อัล นิมร์

หลายฝ่ายที่ติดตามเหตุการณ์ของ อัล นิมร์ มาตลอด หวังว่าเขาจะได้รับการอภัยโทษ แต่นอกจากการอภัยโทษไม่เกิดขึ้นแล้ว ยังมีนักวิเคระาห์การเมืองตะวันตก ออกมาให้ความเห็นว่า อัล นิมร์ ติดคุกมาปีกว่า ทำไมถึงมาทำการประหารชีวิตเขาในตอนนี้ เหมือนเป็นการเลือกจังหวะเวลา…

ก่อนสิ้นปี ค.ศ.2015 อเมริกาเคาะถามรัสเซียว่า จะเอาอย่างไรเรื่องซีเรีย สุ่มเสียงอ่อนลงว่า อัสสาดจะอยู่ต่อก็ได้นะ แต่ถ้าเลือกตั้งแพ้แล้วต้องไปนะ รัสเซียบอก เราก็พูดอย่างนี้มาตั้งแต่แรก มึงฟังไม่ได้ศัพท์เลยหรือไง ทำเอาอเมริกากลับไปตั้งหลัก หลังปีใหม่ค่อยมาว่ากันต่อ

ส่วนเรื่องเยเมน ซาอุดิอารเบียนำทัพเข้าไปลุยเยเมน แต่ดันติดหล่มมาตั้งแต่แต่กลางปี ค.ศ.2015 ขึ้นจากหล่มไม่ได้ ไปต่อไม่เป็น เลยมีการเจรจาสงบศึกชั่วคราว แต่การสงบศึกก็ดูเหมือนไม่สงบจริง เพราะยังขึ้นจากหล่มไม่ได้ ติดหล่มทรายนานๆ นี่ถึงตายนะครับ

ที่ซีเรีย มีกองกำลังของจริงของอิหร่าน คอยช่วยอัสสาด รบสู้กับพวกกบฎซีเรีย ขณะเดียวกัน ก็มีกองกำลังของผู้ก่อการร้ายเติมเงิน ที่ซาอุดิอารเบียและพวกคอยสนับสนุนเติมเงินเติมอาวุธ มาช่วยกบฏซีเรียรบสู้ กับรัฐบาลอัสสาด…. มึนหัวแทนคนอ่าน ค่อยๆอ่านนะครับ

ที่เยเมน มีกองกำลังของจริงของซาอุดิอารเบียและพวก กำลังรบกับพวกที่ซาอุ เรียกว่าเป็นกบฏในเยเมน ซึ่งขณะนี้ พวกกบฏ รบชนะฝ่ายรัฐบาลเยเมน และไล่รัฐบาลเยเมนแตกกระเจิง จนตัวนายกรัฐมนตรีเยเมนหนีไปพึ่งใบบุญซาอุดิอารเบีย ฝ่ายกบฏที่กำลังสู้กับกองกำลังซาอุ มีกลุ่มนักรบฮูตติเป็นตัวยืน เป็นฮูตติ ที่อิหร่านให้การสนับสนุนทั้งด้านกองกำลังและอาวุธ

ที่อิรัค มีกองกำลังของชาวอิรัค กำลังรบเพื่อยึดเอาบ้านเมือง กลับคืนมาจากที่ผู้ก่อการร้าย หรือนักรบเติมเงินยึดเอาไว้ และเริ่มตั้งแต่ปลายปีที่แล้วมานี้ ชาวอิรัค ทำท่าจะยึดเมืองใหญ่คืนมาได้ โดยเป็นที่รู้กันดีว่า ฝ่ายรัสเซียอิหร่านให้การสนับสนุนชาวอิรัค ในการยึดเมืองคืน ส่วนซาอุดิอารเบียและพวก รวมทั้งตุรกี และฝ่ายตะวันตก เป็นผู้สนับสนุนพวกนักรบเติมเงิน ในการยึดอิรัคตั้งแต่เริ่ม….

และเมื่ออิรัค เริ่มยึดเมืองกลับคืนได้ อเมริการีบออกมาให้ข่าวทุกวันว่า เป็นผลงานของตน แต่ชาวบ้านที่ติดตามข่าวมาตลอด โดยไม่มีกระป๋องครอบหัวไว้ ก็คงพอรู้ว่าเรื่องจริงเป็นอย่างไร

พวกเขาวุ่นวายกันขนาดนี้ ยังคิดว่า การประหารชีวิต อัล นิมร์ นั้น มาจากการกระทำของอัล นิมร์ ที่ซาอุดิอารเบีย อ้างว่า เป็นการกดดัน และคุกคามราชวงศ์ซาอุด…อย่างนั้นหรือ……

###############

ตอน 4 (จบ)

ตั้งแต่กษัตริย์อับดุลลาห์ ขึ้นครองราชย์เมื่อต้นปี ค.ศ.2015 นโยบายด้านต่างประเทศของซาอุดิอารเบีย ดูเหมือนจะเปลี่ยนเป็นเชิงรุก(ราน) อย่างเห็นได้ชัด

แต่ไหนแต่ไรมา ซาอุดิอารเบียกับอิหร่านก็ไม่รักกันอยู่แล้ว ซาอุมองอิหร่านเป็นคู่แข่งทางการเมืองที่สำคัญ แย่งชิงกันเป็นผู้นำของตะวันออกกลางมาตลอด แต่ซาอุดิอารเบีย ย่อมคิดว่าตนเองได้เปรียบอิหร่าน เพราะมีแบ๊กแข็งโป๊กอย่างอเมริกา ส่วนอิหร่าน แม้จะมีรัสเซีย จีน เป็นเพื่อน แต่ในสายตาชาวโลกที่หัวติดอยู่ในกระป๋องสี่เหลี่ยม ย่อมมองรัสเซีย จีน ต่างกับมองเจ้าพ่อใหญ่ใบตองแห้ง

ซาอุดิ อารเบีย มาเสียเส้น ก็ตอนเจ้าพ่อใหญ่ใบตองแห้งใช้เวลาเจรจาเรื่องนิวเคลียร์กับอิหร่านนานไป หน่อย เล่นเอาซาอุดิอารเบียงอนจนเตียงแถบหัก แค่นั้นซาอุดิ อารเบีย ก็ยังลงบัญชีงอนเอาไว้ไม่เลิกพ้อ แต่พอคุณพี่ปูติน ที่เป็นเพื่อนกับอิหร่านและซีเรีย ยกทัพเข้ามาในซีเรีย นี่ 3 เดือนกว่าแล้ว และยังไม่มีที่ท่าว่าจะเคลื่อนย้ายออกไป แถมทำท่าจะปักหลักพักนาน แบบนี้ ซาอุดิ อารเบีย จะใช้แค่บทแง่งอน มันคงไม่พอกระตุกคอคู่รักให้หันมาสนใจ

อเมริกา คู่รักฝักแค ยังไม่แสดงที่ท่าว่าจะกระดิกตัว ออกมาปกป้องฝ่ายซาอุดิจากการบุกมาของรัสเซียเลย ได้แต่ส่งเสียงตามลม โหยหวนเหมือนเวลาเห็นใบตองไหว ก็แค่นั้น แล้วแบบนี้เสี่ยปั๊มใหญ่ จะให้เสี่ยปั๊มใหญ่ถูกหยามหน้าต่อไปได้ยังไง

นี่ถ้า รัสเซียไม่ขยับไปไหน นั่งรับลมทะเลทรายเปลี่ยนบรรยากาศไปอีกนาน อิหร่านก็คงใหญ่ขึ้น ใหญ่ขึ้น แถมซีเรีย ที่เราลงทุนเติมเงินลงไปเสียนับไม่ถ้วน ก็ยังไม่ล่ม แค่เละ เจ้าอัสสาดคนนอกศาสนา ก็ยังอยู่ได้ แล้วนี่อิรัคยังมีทีท่าว่า อาจจะไปซบอิหร่านเต็มตัว ยิ่งจะทำให้อิหร่านใหญ่ขึ้นไปอีก โอ้ย… คิดมาถึงตรงนี้แล้ว เสี่ยปั๊มใหญ่ น่าจะรับไม่ไหว มันเลยต้องฉับ ฉับ …

หลังจาก ฉับ ฉับ ไปแล้ว ความร้อนก็ยังไม่ลด ซาอุดิ อารเบีย เลยต้องกระแทกให้อีกดอกว่า …. ถึง จุดนี้ ซาอุดิอารเบีย ไปไกลเกินกว่าที่จะสนใจแล้ว ว่าโอบามาคิดอย่างไร…. ซาอุดิ อารเบีย ไม่สนใจว่าจะทำให้ทำเนียบขาวโกรธหรือไม่…

…..พอ ก็คือ พอ enough is enough …..เอะ นี่เป็น ข้อความส่งถึงอิหร่าน หรือถึงอเมริกากันแน่ ผมชักไม่แน่ใจ

บทนี้ ถ้าฮอลลีวู้ด ไม่รีบเอาไปทำหนัง เสียดายตายห่าเลยครับ

ผมเกือบลืมเล่าถึงดาราตัวเอก ที่ตอนนี้ออกฉากมาพูดแทนซาอุดิอารเบียคือนาย อัล จูเบียร์

อัล จูเบียร์ นี่ ก่อนหน้าจะมารับตำแหน่งเป็นรัฐมนตรีต่างประเทศของซาอุดิ เขาเป็น ทูตซาอุ ประจำอเมริกาตั้งแต่ปี ค.ศ.2007 ถึง 2015 เรียกว่า ซี้ย่ำปึกกับอเมริกา มาตั้งแต่สมัยคาวบอยบุช นอกจากนี้ อัล จูเบียร์ ยังเป็นที่ปรึกษาด้านการต่างประเทศประจำตัวของกษัตริย์อับดุลลาห์ อีกด้วย เมื่อเจ้าชายอับดุลลาห์ขึ้นครองราชย์ไม่กี่เดือน ก็ตั้ง อัล จูเบียร์เป็นรัฐมนตรี ดูเหมือนเขาจะเป็นคนธรรมดาคนแรกของซาอุ ที่ได้ดำรงตำแหน่งนี้

ประวัติดาราแบบนี้ คงทำให้มองเห็นภาพกันนะครับว่า ใครกำลังใช้ใคร จุดฝักแค แล้วฝักแคมันจะลามไปถึงไหน แผนเอาปั๊ม ไม่เอาคนนี่เล่นไม่ยากเลย ไม่ว่าที่ไหน เอาของไม่เอาคน ยุซ้าย แยงขวา เดี๋ยวเขาก็ตีกันเอง เราไม่ต้องกรีทาทัพมาให้เจ็บตาปลาเลยนะ จิ้งหรีดพันธุ์ไหน มันก็ปั่นได้ทั้งนั้นแหละ …ถ้ามันไม่รู้ตัวว่าถูกปั่น…

แล้วแบบนี้ฝ่ายรัสเซีย จีน อิหร่าน และไอ้นักไต่ลวดจอมเล่นเสียวตุรกีว่ายังไง ไม่พูดถึงเลยนะลุง

แหม ผมก็ไม่ได้มีโอกาสถามท่านทั้งสาม และนักไต่ลวดโดยตรงนะครับ แต่ผมว่า แผนปั่นจิ้งหรีด แผนจุดฝักแค ใครๆ เขาก็รู้กันทั้งนั้น ก็เล่นแบบซ้ำซาก

ผมเลยเดาเอาเองว่า อิหร่าน คงบอกเราคอยอยู่ ส่วนอาเฮีย คงอมยิ้ม และ คุณพี่ปูติน คงหัวร่อ หึ หึ ใน ลำคอ… ส่วนตุรกีนักไต่ลวด คงถอนหายใจยาว กูคงไม่ตายเดี่ยว….

สวัสดีครับ

คนเล่านิทาน

8 ม.ค. 2559

0 Comments

0 Shares

121 Views

0 Reviews