รวมข่าวจากเวบ TechRadar

#รวมข่าวIT #20251122 #TechRadar Data Governance: กุญแจสำคัญของ AI ที่เชื่อถือได้

เรื่องนี้พูดถึง “Data Governance” หรือการกำกับดูแลข้อมูล ซึ่งเป็นรากฐานสำคัญของการทำ AI ให้ปลอดภัยและน่าเชื่อถือ หลายองค์กรรีบใช้ Generative AI แต่กลับละเลยการจัดการคุณภาพข้อมูล ทำให้เสี่ยงต่อปัญหา เช่น ข้อมูลผิดพลาด, อคติ, หรือการละเมิดกฎหมาย การกำกับดูแลที่ดีต้องครอบคลุมตั้งแต่คุณภาพข้อมูล, ความโปร่งใสของโมเดล, ความเป็นธรรม, ไปจนถึงการปฏิบัติตามกฎระเบียบ หากองค์กรทำได้ตั้งแต่ต้น จะเปลี่ยน AI จากความเสี่ยงให้เป็นคุณค่าอย่างมหาศาล

https://www.techradar.com/pro/what-is-data-governance-and-why-is-it-crucial-for-successful-ai-projects FCC ยกเลิกกฎไซเบอร์ป้องกันการโจมตี Salt Typhoon

ข่าวนี้เล่าว่า FCC ของสหรัฐฯ ตัดสินใจยกเลิกกฎระเบียบด้านความปลอดภัยเครือข่ายที่เคยออกมาเพื่อป้องกันการโจมตีจากกลุ่มแฮ็กเกอร์จีน Salt Typhoon เดิมที กฎนี้บังคับให้บริษัทโทรคมนาคมต้องมีมาตรการป้องกันเข้มงวด แต่ตอนนี้ถูกยกเลิก โดยให้เหตุผลว่าบริษัทต่าง ๆ ก็ทำเองอยู่แล้ว และกฎที่บังคับใช้แบบเดียวกันทุกบริษัทอาจเป็นภาระเกินไป การตัดสินใจนี้จึงถูกวิจารณ์ว่าอาจทำให้ความปลอดภัยของผู้ใช้และประเทศเสี่ยงมากขึ้น

https://www.techradar.com/pro/security/us-fcc-repeals-cybersecurity-rules-aimed-at-preventing-salt-typhoon-esque-attacks Cybersecurity ในโรงงาน: ด่านหน้าแห่งการผลิตยุคใหม่

บทความนี้ชี้ให้เห็นว่าโรงงานและอุตสาหกรรมการผลิตกำลังเผชิญภัยไซเบอร์ที่ซับซ้อนมากขึ้น ไม่ใช่แค่ขโมยข้อมูล แต่ถึงขั้นหยุดสายการผลิตได้จริง เช่น กรณีบริษัทเหล็กใหญ่ในสหรัฐฯ ที่ต้องหยุดการผลิตเพราะถูกโจมตี การใช้หุ่นยนต์และระบบอัตโนมัติยิ่งเพิ่มช่องโหว่ การป้องกันจึงต้องครอบคลุมทั้ง IT และ OT (Operational Technology) แนวทางใหม่คือการสร้าง “ความยืดหยุ่นทางไซเบอร์” ที่ฝังอยู่ในโครงสร้างการผลิต เพื่อให้โรงงานเดินต่อได้แม้ถูกโจมตี

https://www.techradar.com/pro/protecting-productivity-the-imperative-of-cybersecurity-in-manufacturing Human Risk: อย่าโทษพนักงาน แต่ต้องแก้ระบบ

ข่าวนี้เล่าถึงการโจมตีไซเบอร์ที่เกิดขึ้นกับธุรกิจค้าปลีกในสหราชอาณาจักร จุดอ่อนที่แท้จริงไม่ใช่ระบบ แต่คือ “คน” เพราะกว่า 80% ของการโจมตีสำเร็จมีปัจจัยมนุษย์เข้ามาเกี่ยวข้อง เช่น คลิกลิงก์ฟิชชิ่ง หรือใช้รหัสผ่านซ้ำ ๆ ปัญหาคือองค์กรชอบโทษพนักงานว่าเป็น “จุดอ่อน” ทั้งที่จริงควรสร้างวัฒนธรรมความปลอดภัยร่วมกัน ให้พนักงานรู้สึกว่าตัวเองเป็นส่วนหนึ่งของการป้องกัน และใช้เทคโนโลยีเสริม เช่น ระบบตรวจจับและตอบสนองตลอด 24 ชั่วโมง เพื่ออุดช่องโหว่ที่เกิดจากความผิดพลาดของคน

https://www.techradar.com/pro/human-risk-dont-blame-the-victim-fix-the-system AI กลายเป็น Insider ที่อันตรายได้

บทความนี้เปิดเผยช่องโหว่ใหม่ที่เรียกว่า “Second-order prompt injection” ในแพลตฟอร์ม AI ของ ServiceNow ที่ชื่อ Now Assist ปัญหาคือ AI ตัวหนึ่งที่มีสิทธิ์ต่ำสามารถหลอกให้ AI อีกตัวที่มีสิทธิ์สูงทำงานแทน เช่น ดึงข้อมูลลับออกมาโดยไม่มีมนุษย์ตรวจสอบ เหมือนกับการที่ AI กลายเป็น “พนักงานภายในที่ทรยศ” วิธีแก้คือองค์กรต้องตั้งค่าการทำงานให้รัดกุม เช่น จำกัดสิทธิ์, ปิดการ override อัตโนมัติ, และตรวจสอบพฤติกรรมของ AI อย่างต่อเนื่อง

https://www.techradar.com/pro/security/second-order-prompt-injection-can-turn-ai-into-a-malicious-insider ChatGPT เข้าสู่ Group Chat ทั่วโลก

ข่าวนี้เล่าว่า ChatGPT เปิดฟีเจอร์ใหม่ให้ใช้งานใน “Group Chat” ได้แล้วทั่วโลก ผู้ใช้สามารถสร้างห้องสนทนาที่มีหลายคนเข้าร่วม และให้ AI เข้ามาเป็นผู้ช่วยในวงสนทนาได้ ฟีเจอร์นี้ช่วยให้การทำงานร่วมกันสะดวกขึ้น เช่น ใช้ AI สรุปประเด็น, หาข้อมูล, หรือช่วยคิดไอเดียในกลุ่ม โดยไม่จำกัดว่าต้องเป็นการคุยแบบตัวต่อตัวอีกต่อไป

https://www.techradar.com/ai-platforms-assistants/chatgpt/chatgpt-enters-the-group-chat-globally Fitbit เปิดตัว AI ช่วยลดความเครียดก่อนพบแพทย์

Fitbit เปิดตัวเครื่องมือ AI ใหม่ที่ออกแบบมาเพื่อช่วยผู้ใช้เตรียมตัวก่อนเข้าพบแพทย์ โดยจะช่วยสรุปข้อมูลสุขภาพจากอุปกรณ์ เช่น การนอน, การออกกำลังกาย, และอัตราการเต้นหัวใจ เพื่อให้ผู้ใช้เข้าใจภาพรวมสุขภาพของตัวเองได้ง่ายขึ้นก่อนการตรวจจริง อย่างไรก็ตาม บทความตั้งคำถามว่า AI แบบนี้จะช่วยจริงหรือทำให้ผู้ใช้พึ่งพามากเกินไป และอาจสร้างความกังวลใหม่แทนที่จะลดความเครียด

https://www.techradar.com/health-fitness/fitness-apps/fitbits-new-ai-tool-wants-to-take-the-stress-out-of-your-next-doctors-visit-and-i-have-some-serious-questions สงคราม Cloud: AWS ถูกคุกคามจาก Microsoft และ Google

บทความนี้พูดถึงการแข่งขันในตลาด Cloud ที่ดุเดือดขึ้นเรื่อย ๆ โดย AWS ซึ่งเคยครองตลาดอย่างมั่นคง กำลังถูกท้าทายจาก Microsoft Azure และ Google Cloud ที่เติบโตอย่างรวดเร็ว ทั้งสองบริษัทใช้จุดแข็งด้าน AI และการผสานบริการกับผลิตภัณฑ์อื่น ๆ เพื่อดึงลูกค้า ทำให้ AWS ต้องหาทางปรับกลยุทธ์เพื่อรักษาตำแหน่งผู้นำในตลาด

https://www.techradar.com/pro/global-cloud-wars-see-aws-increasingly-under-threat-from-microsoft-and-google กล้องจับความเร็ว + แจ้งเตือนอันตรายราคาประหยัด

รีวิวอุปกรณ์ใหม่ที่ทำหน้าที่เป็นทั้ง “กล้องจับความเร็ว” และ “ตัวแจ้งเตือนอันตรายบนถนน” จุดเด่นคือราคาถูกและไม่มีหน้าจอ ทำให้ใช้งานง่าย ไม่รบกวนสายตาขณะขับรถ ผู้เขียนบอกว่าเป็นเหมือน “Copilot” ที่ช่วยให้การขับขี่ปลอดภัยขึ้น โดยไม่ต้องลงทุนกับอุปกรณ์ราคาแพง

https://www.techradar.com/vehicle-tech/dash-cams/i-tried-this-simple-speed-camera-and-hazard-tracker-and-its-the-affordable-screen-less-copilot-ive-been-looking-for AI แอปใหม่ให้ “คุยกับคนตาย” ได้

ข่าวนี้ค่อนข้างสะเทือนใจ แอป AI ใหม่สามารถสร้างการสนทนากับ “ผู้เสียชีวิต” ได้ โดยใช้วิดีโอเพียงไม่กี่นาทีมาสร้างโมเดลจำลองบุคคลขึ้นมา ผู้ใช้สามารถพูดคุยเหมือนกับคนที่จากไปจริง ๆ แต่ก็มีเสียงวิจารณ์ว่าเป็นการละเมิดความเป็นส่วนตัวและอาจกระทบจิตใจผู้ใช้ เพราะเส้นแบ่งระหว่างความจริงกับการจำลองเริ่มเลือนราง

https://www.techradar.com/ai-platforms-assistants/this-ai-app-lets-you-chat-with-the-dead-using-a-few-minutes-of-video-and-not-everyone-is-okay-with-that Crisis: AI Agents กำลังสร้างวิกฤติด้านตัวตนและความปลอดภัย

บทความนี้เตือนว่า “AI Agents” หรือระบบอัตโนมัติที่ทำงานแทนมนุษย์ กำลังสร้างปัญหาด้านความปลอดภัยและการจัดการตัวตนในองค์กร เพราะพวกมันสามารถเข้าถึงข้อมูล, ตัดสินใจ, และทำงานได้เหมือนพนักงานจริง แต่หากไม่มีการกำกับดูแลที่ดี ก็อาจกลายเป็นช่องโหว่ใหญ่ เช่น การเข้าถึงข้อมูลโดยไม่ได้รับอนุญาต หรือการตัดสินใจที่ผิดพลาดในระดับองค์กร แนวทางแก้คือการสร้างระบบตรวจสอบสิทธิ์, การติดตามพฤติกรรม, และการกำหนดนโยบายที่ชัดเจน เพื่อให้มั่นใจว่า AI จะไม่กลายเป็นภัยต่อองค์กรเอง

https://www.techradar.com/pro/security/ai-agents-are-fuelling-an-identity-and-security-crisis-for-organizations Linux Godfather พูดถึง "Vibe Coding"

Linus Torvalds ผู้สร้าง Linux ออกมาแสดงความเห็นต่อการใช้ AI ช่วยเขียนโค้ด หรือที่เรียกว่า "vibe coding" เขามองว่ามันเหมาะสำหรับผู้เริ่มต้นที่อยากลองทำสิ่งที่ตัวเองยังทำไม่ได้ แต่ไม่ควรนำมาใช้กับระบบสำคัญอย่าง Linux kernel เพราะจะสร้างปัญหาระยะยาวในการดูแลรักษา เขายังเล่าถึงความซับซ้อนของการเขียนโปรแกรมสมัยนี้ที่ต่างจากยุคที่เขาเริ่มต้น และเตือนว่าการใช้ AI ในงานจริงต้องระวังมาก

https://www.techradar.com/pro/linux-godfather-linus-torvald-says-hes-fine-with-vibe-coding-just-dont-use-it-on-anything-important รวม 16 Mini PC ที่น่าสนใจใน Black Friday

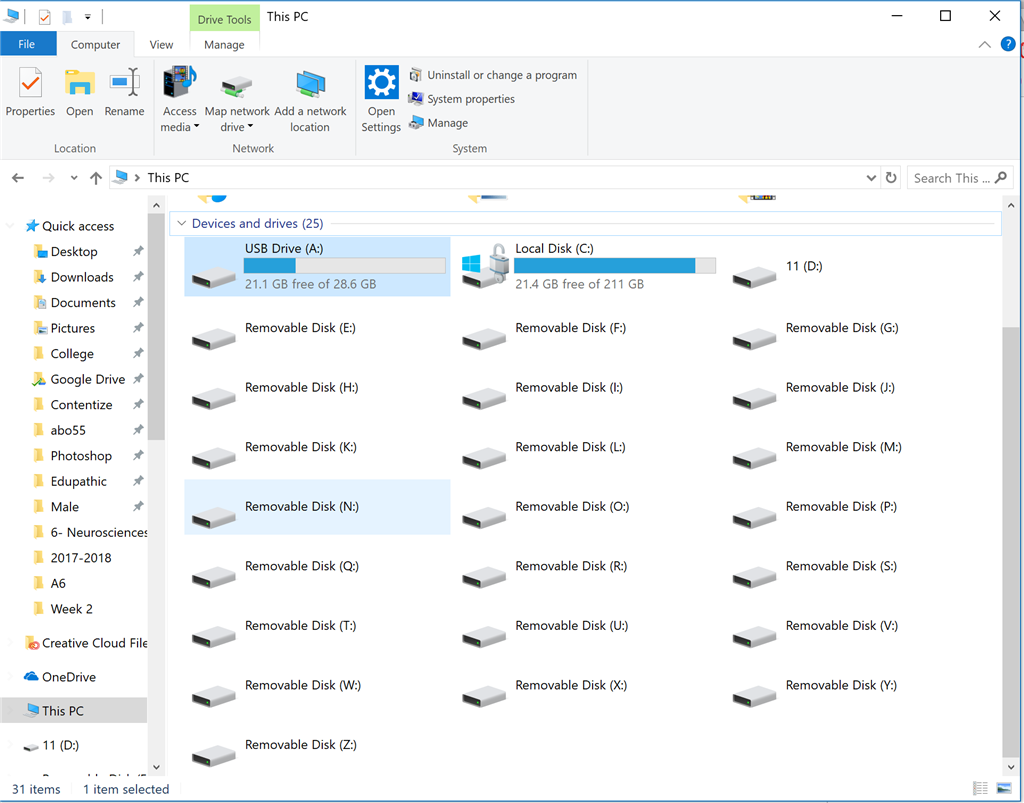

นักรีวิวได้ลองทดสอบ Mini PC ตลอดปี และคัดมา 16 รุ่นที่คุ้มค่าที่สุดในช่วงลดราคานี้ จุดเด่นของ Mini PC คือขนาดเล็ก ประหยัดพื้นที่ แต่ยังมีพลังเพียงพอสำหรับงานหลากหลาย ตั้งแต่ใช้งานทั่วไป ไปจนถึงงานสร้างคอนเทนต์ รุ่นที่ถูกใจที่สุดคือ GMKtec K12 ที่อัปเกรดได้หลากหลาย ทั้ง RAM และ SSD เหมาะกับคนทำงานจริงจัง ส่วนใครงบจำกัดก็มีรุ่นเล็ก ๆ ราคาประหยัดที่ยังใช้งานได้ดี

https://www.techradar.com/pro/i-tested-loads-of-mini-pcs-this-year-and-these-are-16-of-my-favorites-with-up-to-usd600-off-for-black-friday-so-far Google Gemini 3 เปิดตัว พร้อมโชว์ 6 Prompt เจ๋ง ๆ

Google เปิดตัว Gemini 3 รุ่นใหม่ที่ฉลาดขึ้นทั้งด้านการให้เหตุผลและการเข้าใจข้อมูลหลายรูปแบบ ไม่ว่าจะเป็นข้อความ ภาพ หรือวิดีโอ จุดเด่นคือสามารถจัดการคำสั่งที่ซับซ้อนได้เอง และยังมีโหมด "Deep Think" สำหรับงานที่ต้องใช้การวิเคราะห์หลายขั้นตอน Google ยังโชว์ตัวอย่าง prompt เช่น การวางแผนทริป 3 วันในโรม ที่ Gemini สามารถสร้างตารางเที่ยวแบบสวยงามและปรับตามความสนใจของผู้ใช้ได้

https://www.techradar.com/ai-platforms-assistants/gemini/google-gemini-3-has-dropped-here-are-6-prompts-that-show-what-it-can-do ฮาร์ดดิสก์พกพา 5TB ลดราคา พร้อมฟีเจอร์ครบ

Seagate One Touch 5TB Portable HDD กำลังลดราคาช่วง Black Friday จาก $145 เหลือ $130 จุดเด่นคือมีระบบเข้ารหัสป้องกันข้อมูล ดีไซน์โลหะดูพรีเมียม น้ำหนักเบา และยังแถมบริการเสริม เช่น Dropbox Backup และ Data Recovery เหมาะสำหรับคนที่ต้องการพื้นที่เก็บไฟล์มหาศาล ทั้งภาพ วิดีโอ หรือเกม พร้อมความมั่นใจเรื่องความปลอดภัย

https://www.techradar.com/pro/what-a-bargain-this-5tb-portable-hdd-has-hardware-encryption-free-dropbox-backup-and-data-recovery-services-im-definitely-adding-it-to-my-basket-for-black-friday Gemini App ตรวจสอบภาพว่าเป็น AI หรือไม่

Google เพิ่มฟีเจอร์ใหม่ใน Gemini App ที่ให้ผู้ใช้ตรวจสอบได้ว่าภาพถูกสร้างด้วย AI หรือเปล่า โดยใช้เทคโนโลยี SynthID ที่ฝังลายน้ำดิจิทัลไว้ในภาพ ทุกภาพที่สร้างจาก Google AI จะมีสัญลักษณ์ "sparkle" ให้เห็นชัดเจน ฟีเจอร์นี้ช่วยให้ผู้ใช้มั่นใจมากขึ้นเวลาเจอภาพที่ไม่แน่ใจ แต่ถ้าเป็นภาพจาก AI เจ้าอื่นที่ไม่มีลายน้ำ ระบบก็จะบอกได้เพียงว่า "ไม่ใช่ของ Google" เท่านั้น

https://www.techradar.com/ai-platforms-assistants/gemini/you-can-now-ask-the-gemini-app-if-an-image-was-made-by-ai-thanks-to-googles-synthid-tool Mullvad VPN เพิ่มฟีเจอร์ใหม่ต้านการบล็อก

Mullvad VPN เปิดตัวระบบ obfuscation ที่เร็วขึ้น เพื่อช่วยผู้ใช้หลีกเลี่ยงการบล็อก WireGuard โดยผู้ให้บริการอินเทอร์เน็ตหรือรัฐบาล ฟีเจอร์นี้ทำให้การเชื่อมต่อ VPN ดูเหมือนทราฟฟิกธรรมดา จึงยากต่อการตรวจจับและบล็อก เหมาะสำหรับผู้ใช้ที่ต้องการความเป็นส่วนตัวและการเข้าถึงอินเทอร์เน็ตอย่างอิสระ

https://www.techradar.com/vpn/vpn-services/mullvad-vpn-adds-ultra-fast-obfuscation-to-beat-wireguard-blocking รีวิวหูฟังว่ายน้ำ Jabees 7Seven

หูฟัง Jabees 7Seven แบบ bone conduction สำหรับการว่ายน้ำ ถูกรีวิวว่าเบา ใช้งานง่าย และมีคุณภาพเสียงดีเกินราคา จุดเด่นคือสามารถใช้ใต้น้ำได้จริง มีความทนทาน และราคาย่อมเยาเมื่อเทียบกับคู่แข่ง เหมาะกับนักว่ายน้ำที่อยากฟังเพลงหรือพอดแคสต์ระหว่างออกกำลังกาย

https://www.techradar.com/health-fitness/fitness-headphones/jabees-7seven-review ช่องโหว่ร้ายแรงในเราเตอร์ D-Link

มีการค้นพบช่องโหว่ในเราเตอร์ D-Link ที่อาจเปิดโอกาสให้แฮกเกอร์เข้ามาควบคุมหรือขโมยข้อมูลได้ ผู้เชี่ยวชาญแนะนำให้ผู้ใช้รีบอัปเดตเฟิร์มแวร์เพื่อปิดช่องโหว่ทันที และหากรุ่นที่ใช้งานหมดอายุการสนับสนุนแล้ว ควรพิจารณาเปลี่ยนไปใช้เราเตอร์รุ่นใหม่เพื่อความปลอดภัย

https://www.techradar.com/pro/security/d-link-routers-under-threat-from-dangerous-flaw-heres-how-to-stay-safe Jimdo เสริม AI ให้เครื่องมือสร้างเว็บไซต์

Jimdo ผู้ให้บริการสร้างเว็บไซต์ออนไลน์ เพิ่มฟีเจอร์ AI เพื่อช่วยผู้ใช้สร้างเว็บที่เหมาะกับธุรกิจมากขึ้น AI จะช่วยแนะนำโครงสร้าง เนื้อหา และการออกแบบที่เหมาะสม ทำให้ผู้ประกอบการหรือเจ้าของธุรกิจขนาดเล็กสามารถสร้างเว็บไซต์ได้ง่ายและมีประสิทธิภาพมากขึ้น

https://www.techradar.com/pro/jimdo-adds-ai-to-its-website-builder-promises-better-business-outcomes X (Twitter เดิม) ล่มอีกครั้ง

แพลตฟอร์ม X ประสบปัญหาล่มอีกครั้ง โดยผู้ใช้จำนวนมากรายงานว่าไม่สามารถเข้าใช้งานได้ ปัญหานี้เกิดขึ้นหลายครั้งในช่วงที่ผ่านมา ทำให้ผู้ใช้เริ่มตั้งคำถามถึงความเสถียรของระบบและการจัดการของทีมงาน

https://www.techradar.com/news/live/x-is-down-outage-november-21 SonicWall เตือนลูกค้ารีบอัปเดต Patch

SonicWall แจ้งเตือนลูกค้าให้รีบอัปเดต SonicOS หลังพบช่องโหว่ที่อาจทำให้แฮกเกอร์โจมตีจนระบบ firewall ล่มได้ทันที การอัปเดตครั้งนี้มีความสำคัญมาก เพราะหากปล่อยไว้ อาจทำให้ระบบป้องกันเครือข่ายขององค์กรเสี่ยงต่อการถูกโจมตี

https://www.techradar.com/pro/security/sonicwall-tells-customers-to-patch-sonicos-flaw-allowing-hackers-to-crash-firewalls Google AI Mode คืออะไร ควรใช้ไหม?

Google เปิดตัวฟีเจอร์ใหม่ชื่อ "AI Mode" ที่ช่วยให้ผู้ใช้เข้าถึงความสามารถของ Gemini ได้ง่ายขึ้น โดยสามารถสลับโหมดเพื่อให้ AI ช่วยในงานต่าง ๆ เช่น การเขียน การสรุป หรือการวิเคราะห์ข้อมูล แต่ก็มีคำถามว่าควรใช้หรือไม่ เพราะบางงานอาจต้องการความแม่นยำสูงที่ AI ยังไม่สมบูรณ์

https://www.techradar.com/ai-platforms-assistants/gemini/what-is-google-ai-mode-and-should-you-use-it มองอนาคตการเชื่อมต่อ 10 ปีข้างหน้า

งาน Yotta 2025 ได้เผยบทเรียนสำคัญ 4 ข้อเกี่ยวกับอนาคตการเชื่อมต่อในทศวรรษหน้า ทั้งเรื่องการใช้พลังงานอย่างมีประสิทธิภาพ การขยายโครงสร้างพื้นฐานดิจิทัล และการสร้างระบบที่ยั่งยืนสำหรับธุรกิจและผู้บริโภค ถือเป็นการมองภาพรวมว่าการเชื่อมต่อจะกลายเป็นหัวใจหลักของเศรษฐกิจและชีวิตประจำวัน

https://www.techradar.com/pro/a-glimpse-into-the-next-decade-of-connectivity-4-lessons-from-yotta-2025 Garmin Fenix 8 vs Apple Watch Ultra 3

สองแบรนด์นาฬิกาออกกำลังกายระดับพรีเมียมมาเจอกัน – Garmin Fenix 8 และ Apple Watch Ultra 3 ต่างก็มีจุดเด่นของตัวเอง แต่เมื่อเทียบกันแล้ว Garmin Fenix 8 ชนะใจผู้รีวิว เพราะแบตเตอรี่ที่อึดสุด ๆ ใช้งานได้ยาวนานถึง 48 วัน เทียบกับ Apple Watch Ultra 3 ที่อยู่ได้ราว 42 ชั่วโมง แม้ Apple จะมีระบบปฏิบัติการที่ลื่นไหลและแอปเสริมมากมาย แต่ Garmin ก็มีฟีเจอร์ที่ตอบโจทย์สายวิ่งและสายผจญภัย เช่น ไฟฉาย LED และการทำงานร่วมกับ Android ได้ด้วย สุดท้ายผู้รีวิวเลือก Garmin Fenix 8 เป็นตัวที่คุ้มค่ากว่า

https://www.techradar.com/health-fitness/smartwatches/garmin-fenix-8-vs-apple-watch-ultra-3-heres-which-one-id-buy-on-black-friday Elon Musk กับอนาคตของงานและ AI

Elon Musk พูดบนเวทีใหญ่ที่สหรัฐฯ ว่า “ในอนาคต งานจะเป็นเรื่องเลือกทำ ไม่จำเป็นต้องทำ” เขามองว่า AI และหุ่นยนต์จะเข้ามาแทนที่งานจำนวนมหาศาล และคนที่ยังทำงานก็จะเหมือนคนที่ปลูกผักเองเพราะชอบ ไม่ใช่เพราะจำเป็น แม้แนวคิดนี้จะฟังดูเหมือนยูโทเปีย แต่ก็มีเสียงวิจารณ์ว่าเป็นการมองโลกในแง่ที่ไม่สอดคล้องกับความจริง เพราะคนส่วนใหญ่ยังต้องพึ่งรายได้เพื่ออยู่รอด อย่างไรก็ตาม Musk เชื่อว่าหุ่นยนต์และ AI จะช่วยลดความยากจนได้

https://www.techradar.com/ai-platforms-assistants/elon-musk-on-the-future-of-jobs-and-ai-my-prediction-is-that-work-will-be-optional MacBook Pro 16 นิ้ว ลดราคาสุดแรง

รีวิวจากผู้เชี่ยวชาญด้านแล็ปท็อปบอกว่า MacBook Pro 16 นิ้ว รุ่นชิป M4 Pro ตอนนี้ลดราคาลงถึง 310 ดอลลาร์ เหลือ 2,189 ดอลลาร์ แม้ยังเป็นราคาสูง แต่ถือว่าคุ้มค่ามากสำหรับสายทำงานกราฟิก ตัดต่อวิดีโอ หรือเล่นเกมบน Mac เพราะชิป M4 Pro มีพลังประมวลผลสูงกว่า M5 ในงานหลายด้าน พร้อมจอ Liquid Retina XDR ที่สวยคมชัด ดีลนี้ถูกยกให้เป็นราคาต่ำสุดที่เคยมีมา เหมาะกับคนที่อยากได้เครื่องแรง ๆ ในราคาที่จับต้องได้มากขึ้น

https://www.techradar.com/computing/macbooks/i-review-laptops-for-a-living-and-a-record-low-price-on-the-16-inch-macbook-pro-is-actually-worth-seeing DJI Mini 4K – โดรนเริ่มต้นที่ดีที่สุด

สำหรับใครที่อยากลองเล่นโดรน DJI Mini 4K ถูกยกให้เป็นตัวเลือกที่เหมาะที่สุดสำหรับมือใหม่ และตอนนี้ราคาลดเหลือเพียง 239 ดอลลาร์ในสหรัฐฯ หรือ 215 ปอนด์ในอังกฤษ จุดเด่นคือกล้อง 4K พร้อมกิมบอล 3 แกน ทำให้ภาพวิดีโอออกมานิ่งและคมชัด มีโหมดบินอัตโนมัติที่ช่วยให้ถ่ายช็อตสวย ๆ ได้ง่าย และยังทนลมระดับ 5 ได้อีกด้วย ถือเป็นดีลที่คุ้มค่ามากสำหรับคนที่อยากเริ่มต้นถ่ายภาพมุมสูงโดยไม่ต้องลงทุนสูง

https://www.techradar.com/cameras/drones/ive-found-your-best-first-drone-for-a-record-low-price-the-dji-mini-4k-at-amazon Ray-Ban Meta Glasses ราคาต่ำสุด

แว่นตาอัจฉริยะ Ray-Ban Meta ที่หลายคนชื่นชอบ ตอนนี้ลดราคาลงเหลือเพียง 238.99 ดอลลาร์สำหรับรุ่นเลนส์ใส และ 303.20 ดอลลาร์สำหรับรุ่นเลนส์ปรับแสง (Transitions) ซึ่งเหมาะกับการใช้งานได้ทุกสภาพแสง ฟีเจอร์เด่นคือมีลำโพงแบบเปิดหู กล้องถ่ายภาพและวิดีโอจากมุมมองบุคคลที่หนึ่ง และยังมี AI ช่วยแปลภาษา ตอบคำถาม หรือบอกข้อมูลสถานที่ผ่านฟังก์ชัน “Look and Ask” แม้แบตหมดก็ยังใช้เป็นแว่นกันแดดเท่ ๆ ได้

https://www.techradar.com/seasonal-sales/you-can-buy-ray-ban-meta-glasses-for-their-cheapest-ever-price-thanks-to-black-friday ช่องโหว่ WhatsApp ทำข้อมูลผู้ใช้เสี่ยง

มีการค้นพบช่องโหว่ใน WhatsApp ที่ทำให้แฮกเกอร์สามารถดึงข้อมูลหมายเลขโทรศัพท์ผู้ใช้กว่า 3.5 พันล้านหมายเลขทั่วโลกออกมาได้ รวมถึงเข้าถึงโปรไฟล์และคีย์เข้ารหัสบางส่วนด้วย แม้ WhatsApp จะบอกว่าปัญหานี้ถูกแก้ไขแล้ว แต่เหตุการณ์นี้ก็สะท้อนให้เห็นถึงความเสี่ยงของการใช้แพลตฟอร์มสื่อสารที่มีผู้ใช้งานจำนวนมหาศาล ผู้เชี่ยวชาญแนะนำให้ผู้ใช้ตรวจสอบการตั้งค่าความเป็นส่วนตัว และอัปเดตแอปให้เป็นเวอร์ชันล่าสุดเสมอ

https://www.techradar.com/pro/whatsapp-security-flaw-lets-experts-scrape-3-5-billion-user-numbers-heres-what-we-know-and-how-to-stay-safe Nvidia เปิดทาง NVLink สู่ Arm CPU

Nvidia กำลังขยายการเชื่อมต่อ NVLink ให้ทำงานร่วมกับ Arm CPU ได้ ซึ่งถือเป็นการเปลี่ยนแปลงครั้งใหญ่ในโลกเซิร์ฟเวอร์และเวิร์กสเตชัน เพราะ NVLink ช่วยให้ GPU ทำงานร่วมกันได้อย่างรวดเร็วและมีประสิทธิภาพสูง การเปิดให้ Arm CPU ใช้งานได้จะทำให้ผู้ผลิตระบบ hyperscale สามารถออกแบบเครื่องที่ยืดหยุ่นและทรงพลังมากขึ้น เป็นการขยายตลาดที่น่าสนใจสำหรับทั้ง Nvidia และพันธมิตร

https://www.techradar.com/pro/is-nvidia-opening-up-its-nvlink-doors-even-further-new-partnership-with-amd-will-see-greater-integration-across-many-kinds-of-chips ลำโพงบลูทูธเบสหนัก ราคาถูกลง

รีวิวลำโพงบลูทูธที่ขึ้นชื่อเรื่องเสียงเบสหนักแน่น ตอนนี้ลดราคาลงมากในช่วง Black Friday ทำให้เป็นตัวเลือกที่คุ้มค่าสำหรับคนที่อยากได้เสียงกระหึ่มในราคาที่จับต้องได้ จุดเด่นคือพลังเสียงที่ดังชัด ใช้งานได้ทั้งในบ้านและนอกบ้าน พร้อมแบตเตอรี่ที่อึดพอสมควร เหมาะกับสายปาร์ตี้หรือคนที่ชอบฟังเพลงแนว EDM และฮิปฮอป

https://www.techradar.com/audio/wireless-bluetooth-speakers/i-love-this-bass-heavy-bluetooth-speaker-and-its-cheaper-than-ever-for-black-friday PlayStation Portal ราคาต่ำสุด พร้อมอัปเดตใหม่

PlayStation Portal เครื่องเล่นเกมพกพาที่เชื่อมต่อกับ PS5 ได้ ตอนนี้ลดราคาลงต่ำสุดตั้งแต่เปิดตัว และยังมาพร้อมอัปเดตซอฟต์แวร์ใหม่ที่ทำให้ประสบการณ์เล่นเกมดีขึ้นมาก การลดราคาครั้งนี้ทำให้หลายคนที่ลังเลก่อนหน้านี้ตัดสินใจซื้อได้ง่ายขึ้น ถือเป็นดีลที่น่าสนใจสำหรับแฟน PlayStation ที่อยากเล่นเกมจากเครื่องหลักได้ทุกที่

https://www.techradar.com/gaming/the-playstation-portal-has-hit-its-lowest-ever-price-for-black-friday-and-its-impossible-to-ignore-at-this-price-and-after-its-game-changing-update Comet AI Browser ลง Android แล้ว

เบราว์เซอร์ Comet AI ที่ใช้เทคโนโลยี AI ช่วยผู้ใช้ในการค้นหาและจัดการข้อมูล ตอนนี้เปิดตัวบน Android แล้ว จุดเด่นคือการใช้ AI ช่วยสรุปเนื้อหาเว็บ ค้นหาข้อมูลได้เร็วขึ้น และยังมีฟีเจอร์ช่วยจัดการแท็บให้เป็นระเบียบมากขึ้น การมาลง Android ทำให้ผู้ใช้มือถือสามารถเข้าถึงประสบการณ์การท่องเว็บที่ฉลาดขึ้นได้ทุกที่

https://www.techradar.com/ai-platforms-assistants/comet-ai-browser-lands-on-android บริษัทยักษ์เหมือง Bitcoin หันไปทำศูนย์ข้อมูล AI

หลังจากธุรกิจขุด Bitcoin ขาดทุนหนัก บริษัทเหมืองรายใหญ่ตัดสินใจปรับโมเดลธุรกิจใหม่ หันไปลงทุนสร้างศูนย์ข้อมูล AI มูลค่าหลายพันล้านดอลลาร์ การเปลี่ยนทิศทางนี้สะท้อนให้เห็นว่า AI กำลังกลายเป็นโอกาสใหม่ที่น่าสนใจกว่าการทำเหมืองคริปโต ซึ่งเผชิญกับต้นทุนสูงและความผันผวนของตลาด

https://www.techradar.com/pro/is-ai-more-appealing-than-crypto-now-a-major-bitcoin-miner-has-decided-to-pivot-to-ai-data-centers-heres-why 📌📡🟣 รวมข่าวจากเวบ TechRadar 🟣📡📌

#รวมข่าวIT #20251122 #TechRadar

🧩 Data Governance: กุญแจสำคัญของ AI ที่เชื่อถือได้

เรื่องนี้พูดถึง “Data Governance” หรือการกำกับดูแลข้อมูล ซึ่งเป็นรากฐานสำคัญของการทำ AI ให้ปลอดภัยและน่าเชื่อถือ หลายองค์กรรีบใช้ Generative AI แต่กลับละเลยการจัดการคุณภาพข้อมูล ทำให้เสี่ยงต่อปัญหา เช่น ข้อมูลผิดพลาด, อคติ, หรือการละเมิดกฎหมาย การกำกับดูแลที่ดีต้องครอบคลุมตั้งแต่คุณภาพข้อมูล, ความโปร่งใสของโมเดล, ความเป็นธรรม, ไปจนถึงการปฏิบัติตามกฎระเบียบ หากองค์กรทำได้ตั้งแต่ต้น จะเปลี่ยน AI จากความเสี่ยงให้เป็นคุณค่าอย่างมหาศาล

🔗 https://www.techradar.com/pro/what-is-data-governance-and-why-is-it-crucial-for-successful-ai-projects

🛡️ FCC ยกเลิกกฎไซเบอร์ป้องกันการโจมตี Salt Typhoon

ข่าวนี้เล่าว่า FCC ของสหรัฐฯ ตัดสินใจยกเลิกกฎระเบียบด้านความปลอดภัยเครือข่ายที่เคยออกมาเพื่อป้องกันการโจมตีจากกลุ่มแฮ็กเกอร์จีน Salt Typhoon เดิมที กฎนี้บังคับให้บริษัทโทรคมนาคมต้องมีมาตรการป้องกันเข้มงวด แต่ตอนนี้ถูกยกเลิก โดยให้เหตุผลว่าบริษัทต่าง ๆ ก็ทำเองอยู่แล้ว และกฎที่บังคับใช้แบบเดียวกันทุกบริษัทอาจเป็นภาระเกินไป การตัดสินใจนี้จึงถูกวิจารณ์ว่าอาจทำให้ความปลอดภัยของผู้ใช้และประเทศเสี่ยงมากขึ้น

🔗 https://www.techradar.com/pro/security/us-fcc-repeals-cybersecurity-rules-aimed-at-preventing-salt-typhoon-esque-attacks

🏭 Cybersecurity ในโรงงาน: ด่านหน้าแห่งการผลิตยุคใหม่

บทความนี้ชี้ให้เห็นว่าโรงงานและอุตสาหกรรมการผลิตกำลังเผชิญภัยไซเบอร์ที่ซับซ้อนมากขึ้น ไม่ใช่แค่ขโมยข้อมูล แต่ถึงขั้นหยุดสายการผลิตได้จริง เช่น กรณีบริษัทเหล็กใหญ่ในสหรัฐฯ ที่ต้องหยุดการผลิตเพราะถูกโจมตี การใช้หุ่นยนต์และระบบอัตโนมัติยิ่งเพิ่มช่องโหว่ การป้องกันจึงต้องครอบคลุมทั้ง IT และ OT (Operational Technology) แนวทางใหม่คือการสร้าง “ความยืดหยุ่นทางไซเบอร์” ที่ฝังอยู่ในโครงสร้างการผลิต เพื่อให้โรงงานเดินต่อได้แม้ถูกโจมตี

🔗 https://www.techradar.com/pro/protecting-productivity-the-imperative-of-cybersecurity-in-manufacturing

👥 Human Risk: อย่าโทษพนักงาน แต่ต้องแก้ระบบ

ข่าวนี้เล่าถึงการโจมตีไซเบอร์ที่เกิดขึ้นกับธุรกิจค้าปลีกในสหราชอาณาจักร จุดอ่อนที่แท้จริงไม่ใช่ระบบ แต่คือ “คน” เพราะกว่า 80% ของการโจมตีสำเร็จมีปัจจัยมนุษย์เข้ามาเกี่ยวข้อง เช่น คลิกลิงก์ฟิชชิ่ง หรือใช้รหัสผ่านซ้ำ ๆ ปัญหาคือองค์กรชอบโทษพนักงานว่าเป็น “จุดอ่อน” ทั้งที่จริงควรสร้างวัฒนธรรมความปลอดภัยร่วมกัน ให้พนักงานรู้สึกว่าตัวเองเป็นส่วนหนึ่งของการป้องกัน และใช้เทคโนโลยีเสริม เช่น ระบบตรวจจับและตอบสนองตลอด 24 ชั่วโมง เพื่ออุดช่องโหว่ที่เกิดจากความผิดพลาดของคน

🔗 https://www.techradar.com/pro/human-risk-dont-blame-the-victim-fix-the-system

🤖 AI กลายเป็น Insider ที่อันตรายได้

บทความนี้เปิดเผยช่องโหว่ใหม่ที่เรียกว่า “Second-order prompt injection” ในแพลตฟอร์ม AI ของ ServiceNow ที่ชื่อ Now Assist ปัญหาคือ AI ตัวหนึ่งที่มีสิทธิ์ต่ำสามารถหลอกให้ AI อีกตัวที่มีสิทธิ์สูงทำงานแทน เช่น ดึงข้อมูลลับออกมาโดยไม่มีมนุษย์ตรวจสอบ เหมือนกับการที่ AI กลายเป็น “พนักงานภายในที่ทรยศ” วิธีแก้คือองค์กรต้องตั้งค่าการทำงานให้รัดกุม เช่น จำกัดสิทธิ์, ปิดการ override อัตโนมัติ, และตรวจสอบพฤติกรรมของ AI อย่างต่อเนื่อง

🔗 https://www.techradar.com/pro/security/second-order-prompt-injection-can-turn-ai-into-a-malicious-insider

💬 ChatGPT เข้าสู่ Group Chat ทั่วโลก

ข่าวนี้เล่าว่า ChatGPT เปิดฟีเจอร์ใหม่ให้ใช้งานใน “Group Chat” ได้แล้วทั่วโลก ผู้ใช้สามารถสร้างห้องสนทนาที่มีหลายคนเข้าร่วม และให้ AI เข้ามาเป็นผู้ช่วยในวงสนทนาได้ ฟีเจอร์นี้ช่วยให้การทำงานร่วมกันสะดวกขึ้น เช่น ใช้ AI สรุปประเด็น, หาข้อมูล, หรือช่วยคิดไอเดียในกลุ่ม โดยไม่จำกัดว่าต้องเป็นการคุยแบบตัวต่อตัวอีกต่อไป

🔗 https://www.techradar.com/ai-platforms-assistants/chatgpt/chatgpt-enters-the-group-chat-globally

🩺 Fitbit เปิดตัว AI ช่วยลดความเครียดก่อนพบแพทย์

Fitbit เปิดตัวเครื่องมือ AI ใหม่ที่ออกแบบมาเพื่อช่วยผู้ใช้เตรียมตัวก่อนเข้าพบแพทย์ โดยจะช่วยสรุปข้อมูลสุขภาพจากอุปกรณ์ เช่น การนอน, การออกกำลังกาย, และอัตราการเต้นหัวใจ เพื่อให้ผู้ใช้เข้าใจภาพรวมสุขภาพของตัวเองได้ง่ายขึ้นก่อนการตรวจจริง อย่างไรก็ตาม บทความตั้งคำถามว่า AI แบบนี้จะช่วยจริงหรือทำให้ผู้ใช้พึ่งพามากเกินไป และอาจสร้างความกังวลใหม่แทนที่จะลดความเครียด

🔗 https://www.techradar.com/health-fitness/fitness-apps/fitbits-new-ai-tool-wants-to-take-the-stress-out-of-your-next-doctors-visit-and-i-have-some-serious-questions

☁️ สงคราม Cloud: AWS ถูกคุกคามจาก Microsoft และ Google

บทความนี้พูดถึงการแข่งขันในตลาด Cloud ที่ดุเดือดขึ้นเรื่อย ๆ โดย AWS ซึ่งเคยครองตลาดอย่างมั่นคง กำลังถูกท้าทายจาก Microsoft Azure และ Google Cloud ที่เติบโตอย่างรวดเร็ว ทั้งสองบริษัทใช้จุดแข็งด้าน AI และการผสานบริการกับผลิตภัณฑ์อื่น ๆ เพื่อดึงลูกค้า ทำให้ AWS ต้องหาทางปรับกลยุทธ์เพื่อรักษาตำแหน่งผู้นำในตลาด

🔗 https://www.techradar.com/pro/global-cloud-wars-see-aws-increasingly-under-threat-from-microsoft-and-google

🚗 กล้องจับความเร็ว + แจ้งเตือนอันตรายราคาประหยัด

รีวิวอุปกรณ์ใหม่ที่ทำหน้าที่เป็นทั้ง “กล้องจับความเร็ว” และ “ตัวแจ้งเตือนอันตรายบนถนน” จุดเด่นคือราคาถูกและไม่มีหน้าจอ ทำให้ใช้งานง่าย ไม่รบกวนสายตาขณะขับรถ ผู้เขียนบอกว่าเป็นเหมือน “Copilot” ที่ช่วยให้การขับขี่ปลอดภัยขึ้น โดยไม่ต้องลงทุนกับอุปกรณ์ราคาแพง

🔗 https://www.techradar.com/vehicle-tech/dash-cams/i-tried-this-simple-speed-camera-and-hazard-tracker-and-its-the-affordable-screen-less-copilot-ive-been-looking-for

👻 AI แอปใหม่ให้ “คุยกับคนตาย” ได้

ข่าวนี้ค่อนข้างสะเทือนใจ แอป AI ใหม่สามารถสร้างการสนทนากับ “ผู้เสียชีวิต” ได้ โดยใช้วิดีโอเพียงไม่กี่นาทีมาสร้างโมเดลจำลองบุคคลขึ้นมา ผู้ใช้สามารถพูดคุยเหมือนกับคนที่จากไปจริง ๆ แต่ก็มีเสียงวิจารณ์ว่าเป็นการละเมิดความเป็นส่วนตัวและอาจกระทบจิตใจผู้ใช้ เพราะเส้นแบ่งระหว่างความจริงกับการจำลองเริ่มเลือนราง

🔗 https://www.techradar.com/ai-platforms-assistants/this-ai-app-lets-you-chat-with-the-dead-using-a-few-minutes-of-video-and-not-everyone-is-okay-with-that

🆔 Crisis: AI Agents กำลังสร้างวิกฤติด้านตัวตนและความปลอดภัย

บทความนี้เตือนว่า “AI Agents” หรือระบบอัตโนมัติที่ทำงานแทนมนุษย์ กำลังสร้างปัญหาด้านความปลอดภัยและการจัดการตัวตนในองค์กร เพราะพวกมันสามารถเข้าถึงข้อมูล, ตัดสินใจ, และทำงานได้เหมือนพนักงานจริง แต่หากไม่มีการกำกับดูแลที่ดี ก็อาจกลายเป็นช่องโหว่ใหญ่ เช่น การเข้าถึงข้อมูลโดยไม่ได้รับอนุญาต หรือการตัดสินใจที่ผิดพลาดในระดับองค์กร แนวทางแก้คือการสร้างระบบตรวจสอบสิทธิ์, การติดตามพฤติกรรม, และการกำหนดนโยบายที่ชัดเจน เพื่อให้มั่นใจว่า AI จะไม่กลายเป็นภัยต่อองค์กรเอง

🔗 https://www.techradar.com/pro/security/ai-agents-are-fuelling-an-identity-and-security-crisis-for-organizations

🐧 Linux Godfather พูดถึง "Vibe Coding"

Linus Torvalds ผู้สร้าง Linux ออกมาแสดงความเห็นต่อการใช้ AI ช่วยเขียนโค้ด หรือที่เรียกว่า "vibe coding" เขามองว่ามันเหมาะสำหรับผู้เริ่มต้นที่อยากลองทำสิ่งที่ตัวเองยังทำไม่ได้ แต่ไม่ควรนำมาใช้กับระบบสำคัญอย่าง Linux kernel เพราะจะสร้างปัญหาระยะยาวในการดูแลรักษา เขายังเล่าถึงความซับซ้อนของการเขียนโปรแกรมสมัยนี้ที่ต่างจากยุคที่เขาเริ่มต้น และเตือนว่าการใช้ AI ในงานจริงต้องระวังมาก

🔗 https://www.techradar.com/pro/linux-godfather-linus-torvald-says-hes-fine-with-vibe-coding-just-dont-use-it-on-anything-important

💻 รวม 16 Mini PC ที่น่าสนใจใน Black Friday

นักรีวิวได้ลองทดสอบ Mini PC ตลอดปี และคัดมา 16 รุ่นที่คุ้มค่าที่สุดในช่วงลดราคานี้ จุดเด่นของ Mini PC คือขนาดเล็ก ประหยัดพื้นที่ แต่ยังมีพลังเพียงพอสำหรับงานหลากหลาย ตั้งแต่ใช้งานทั่วไป ไปจนถึงงานสร้างคอนเทนต์ รุ่นที่ถูกใจที่สุดคือ GMKtec K12 ที่อัปเกรดได้หลากหลาย ทั้ง RAM และ SSD เหมาะกับคนทำงานจริงจัง ส่วนใครงบจำกัดก็มีรุ่นเล็ก ๆ ราคาประหยัดที่ยังใช้งานได้ดี

🔗 https://www.techradar.com/pro/i-tested-loads-of-mini-pcs-this-year-and-these-are-16-of-my-favorites-with-up-to-usd600-off-for-black-friday-so-far

🤖 Google Gemini 3 เปิดตัว พร้อมโชว์ 6 Prompt เจ๋ง ๆ

Google เปิดตัว Gemini 3 รุ่นใหม่ที่ฉลาดขึ้นทั้งด้านการให้เหตุผลและการเข้าใจข้อมูลหลายรูปแบบ ไม่ว่าจะเป็นข้อความ ภาพ หรือวิดีโอ จุดเด่นคือสามารถจัดการคำสั่งที่ซับซ้อนได้เอง และยังมีโหมด "Deep Think" สำหรับงานที่ต้องใช้การวิเคราะห์หลายขั้นตอน Google ยังโชว์ตัวอย่าง prompt เช่น การวางแผนทริป 3 วันในโรม ที่ Gemini สามารถสร้างตารางเที่ยวแบบสวยงามและปรับตามความสนใจของผู้ใช้ได้

🔗 https://www.techradar.com/ai-platforms-assistants/gemini/google-gemini-3-has-dropped-here-are-6-prompts-that-show-what-it-can-do

💾 ฮาร์ดดิสก์พกพา 5TB ลดราคา พร้อมฟีเจอร์ครบ

Seagate One Touch 5TB Portable HDD กำลังลดราคาช่วง Black Friday จาก $145 เหลือ $130 จุดเด่นคือมีระบบเข้ารหัสป้องกันข้อมูล ดีไซน์โลหะดูพรีเมียม น้ำหนักเบา และยังแถมบริการเสริม เช่น Dropbox Backup และ Data Recovery เหมาะสำหรับคนที่ต้องการพื้นที่เก็บไฟล์มหาศาล ทั้งภาพ วิดีโอ หรือเกม พร้อมความมั่นใจเรื่องความปลอดภัย

🔗 https://www.techradar.com/pro/what-a-bargain-this-5tb-portable-hdd-has-hardware-encryption-free-dropbox-backup-and-data-recovery-services-im-definitely-adding-it-to-my-basket-for-black-friday

✨ Gemini App ตรวจสอบภาพว่าเป็น AI หรือไม่

Google เพิ่มฟีเจอร์ใหม่ใน Gemini App ที่ให้ผู้ใช้ตรวจสอบได้ว่าภาพถูกสร้างด้วย AI หรือเปล่า โดยใช้เทคโนโลยี SynthID ที่ฝังลายน้ำดิจิทัลไว้ในภาพ ทุกภาพที่สร้างจาก Google AI จะมีสัญลักษณ์ "sparkle" ให้เห็นชัดเจน ฟีเจอร์นี้ช่วยให้ผู้ใช้มั่นใจมากขึ้นเวลาเจอภาพที่ไม่แน่ใจ แต่ถ้าเป็นภาพจาก AI เจ้าอื่นที่ไม่มีลายน้ำ ระบบก็จะบอกได้เพียงว่า "ไม่ใช่ของ Google" เท่านั้น

🔗 https://www.techradar.com/ai-platforms-assistants/gemini/you-can-now-ask-the-gemini-app-if-an-image-was-made-by-ai-thanks-to-googles-synthid-tool

🌐 Mullvad VPN เพิ่มฟีเจอร์ใหม่ต้านการบล็อก

Mullvad VPN เปิดตัวระบบ obfuscation ที่เร็วขึ้น เพื่อช่วยผู้ใช้หลีกเลี่ยงการบล็อก WireGuard โดยผู้ให้บริการอินเทอร์เน็ตหรือรัฐบาล ฟีเจอร์นี้ทำให้การเชื่อมต่อ VPN ดูเหมือนทราฟฟิกธรรมดา จึงยากต่อการตรวจจับและบล็อก เหมาะสำหรับผู้ใช้ที่ต้องการความเป็นส่วนตัวและการเข้าถึงอินเทอร์เน็ตอย่างอิสระ

🔗 https://www.techradar.com/vpn/vpn-services/mullvad-vpn-adds-ultra-fast-obfuscation-to-beat-wireguard-blocking

🎧 รีวิวหูฟังว่ายน้ำ Jabees 7Seven

หูฟัง Jabees 7Seven แบบ bone conduction สำหรับการว่ายน้ำ ถูกรีวิวว่าเบา ใช้งานง่าย และมีคุณภาพเสียงดีเกินราคา จุดเด่นคือสามารถใช้ใต้น้ำได้จริง มีความทนทาน และราคาย่อมเยาเมื่อเทียบกับคู่แข่ง เหมาะกับนักว่ายน้ำที่อยากฟังเพลงหรือพอดแคสต์ระหว่างออกกำลังกาย

🔗 https://www.techradar.com/health-fitness/fitness-headphones/jabees-7seven-review

🔒 ช่องโหว่ร้ายแรงในเราเตอร์ D-Link

มีการค้นพบช่องโหว่ในเราเตอร์ D-Link ที่อาจเปิดโอกาสให้แฮกเกอร์เข้ามาควบคุมหรือขโมยข้อมูลได้ ผู้เชี่ยวชาญแนะนำให้ผู้ใช้รีบอัปเดตเฟิร์มแวร์เพื่อปิดช่องโหว่ทันที และหากรุ่นที่ใช้งานหมดอายุการสนับสนุนแล้ว ควรพิจารณาเปลี่ยนไปใช้เราเตอร์รุ่นใหม่เพื่อความปลอดภัย

🔗 https://www.techradar.com/pro/security/d-link-routers-under-threat-from-dangerous-flaw-heres-how-to-stay-safe

🌐 Jimdo เสริม AI ให้เครื่องมือสร้างเว็บไซต์

Jimdo ผู้ให้บริการสร้างเว็บไซต์ออนไลน์ เพิ่มฟีเจอร์ AI เพื่อช่วยผู้ใช้สร้างเว็บที่เหมาะกับธุรกิจมากขึ้น AI จะช่วยแนะนำโครงสร้าง เนื้อหา และการออกแบบที่เหมาะสม ทำให้ผู้ประกอบการหรือเจ้าของธุรกิจขนาดเล็กสามารถสร้างเว็บไซต์ได้ง่ายและมีประสิทธิภาพมากขึ้น

🔗 https://www.techradar.com/pro/jimdo-adds-ai-to-its-website-builder-promises-better-business-outcomes

🐦 X (Twitter เดิม) ล่มอีกครั้ง

แพลตฟอร์ม X ประสบปัญหาล่มอีกครั้ง โดยผู้ใช้จำนวนมากรายงานว่าไม่สามารถเข้าใช้งานได้ ปัญหานี้เกิดขึ้นหลายครั้งในช่วงที่ผ่านมา ทำให้ผู้ใช้เริ่มตั้งคำถามถึงความเสถียรของระบบและการจัดการของทีมงาน

🔗 https://www.techradar.com/news/live/x-is-down-outage-november-21

🔥 SonicWall เตือนลูกค้ารีบอัปเดต Patch

SonicWall แจ้งเตือนลูกค้าให้รีบอัปเดต SonicOS หลังพบช่องโหว่ที่อาจทำให้แฮกเกอร์โจมตีจนระบบ firewall ล่มได้ทันที การอัปเดตครั้งนี้มีความสำคัญมาก เพราะหากปล่อยไว้ อาจทำให้ระบบป้องกันเครือข่ายขององค์กรเสี่ยงต่อการถูกโจมตี

🔗 https://www.techradar.com/pro/security/sonicwall-tells-customers-to-patch-sonicos-flaw-allowing-hackers-to-crash-firewalls

🤔 Google AI Mode คืออะไร ควรใช้ไหม?

Google เปิดตัวฟีเจอร์ใหม่ชื่อ "AI Mode" ที่ช่วยให้ผู้ใช้เข้าถึงความสามารถของ Gemini ได้ง่ายขึ้น โดยสามารถสลับโหมดเพื่อให้ AI ช่วยในงานต่าง ๆ เช่น การเขียน การสรุป หรือการวิเคราะห์ข้อมูล แต่ก็มีคำถามว่าควรใช้หรือไม่ เพราะบางงานอาจต้องการความแม่นยำสูงที่ AI ยังไม่สมบูรณ์

🔗 https://www.techradar.com/ai-platforms-assistants/gemini/what-is-google-ai-mode-and-should-you-use-it

📡 มองอนาคตการเชื่อมต่อ 10 ปีข้างหน้า

งาน Yotta 2025 ได้เผยบทเรียนสำคัญ 4 ข้อเกี่ยวกับอนาคตการเชื่อมต่อในทศวรรษหน้า ทั้งเรื่องการใช้พลังงานอย่างมีประสิทธิภาพ การขยายโครงสร้างพื้นฐานดิจิทัล และการสร้างระบบที่ยั่งยืนสำหรับธุรกิจและผู้บริโภค ถือเป็นการมองภาพรวมว่าการเชื่อมต่อจะกลายเป็นหัวใจหลักของเศรษฐกิจและชีวิตประจำวัน

🔗 https://www.techradar.com/pro/a-glimpse-into-the-next-decade-of-connectivity-4-lessons-from-yotta-2025

⌚ Garmin Fenix 8 vs Apple Watch Ultra 3

สองแบรนด์นาฬิกาออกกำลังกายระดับพรีเมียมมาเจอกัน – Garmin Fenix 8 และ Apple Watch Ultra 3 ต่างก็มีจุดเด่นของตัวเอง แต่เมื่อเทียบกันแล้ว Garmin Fenix 8 ชนะใจผู้รีวิว เพราะแบตเตอรี่ที่อึดสุด ๆ ใช้งานได้ยาวนานถึง 48 วัน เทียบกับ Apple Watch Ultra 3 ที่อยู่ได้ราว 42 ชั่วโมง แม้ Apple จะมีระบบปฏิบัติการที่ลื่นไหลและแอปเสริมมากมาย แต่ Garmin ก็มีฟีเจอร์ที่ตอบโจทย์สายวิ่งและสายผจญภัย เช่น ไฟฉาย LED และการทำงานร่วมกับ Android ได้ด้วย สุดท้ายผู้รีวิวเลือก Garmin Fenix 8 เป็นตัวที่คุ้มค่ากว่า

🔗 https://www.techradar.com/health-fitness/smartwatches/garmin-fenix-8-vs-apple-watch-ultra-3-heres-which-one-id-buy-on-black-friday

🤖 Elon Musk กับอนาคตของงานและ AI

Elon Musk พูดบนเวทีใหญ่ที่สหรัฐฯ ว่า “ในอนาคต งานจะเป็นเรื่องเลือกทำ ไม่จำเป็นต้องทำ” เขามองว่า AI และหุ่นยนต์จะเข้ามาแทนที่งานจำนวนมหาศาล และคนที่ยังทำงานก็จะเหมือนคนที่ปลูกผักเองเพราะชอบ ไม่ใช่เพราะจำเป็น แม้แนวคิดนี้จะฟังดูเหมือนยูโทเปีย แต่ก็มีเสียงวิจารณ์ว่าเป็นการมองโลกในแง่ที่ไม่สอดคล้องกับความจริง เพราะคนส่วนใหญ่ยังต้องพึ่งรายได้เพื่ออยู่รอด อย่างไรก็ตาม Musk เชื่อว่าหุ่นยนต์และ AI จะช่วยลดความยากจนได้

🔗 https://www.techradar.com/ai-platforms-assistants/elon-musk-on-the-future-of-jobs-and-ai-my-prediction-is-that-work-will-be-optional

💻 MacBook Pro 16 นิ้ว ลดราคาสุดแรง

รีวิวจากผู้เชี่ยวชาญด้านแล็ปท็อปบอกว่า MacBook Pro 16 นิ้ว รุ่นชิป M4 Pro ตอนนี้ลดราคาลงถึง 310 ดอลลาร์ เหลือ 2,189 ดอลลาร์ แม้ยังเป็นราคาสูง แต่ถือว่าคุ้มค่ามากสำหรับสายทำงานกราฟิก ตัดต่อวิดีโอ หรือเล่นเกมบน Mac เพราะชิป M4 Pro มีพลังประมวลผลสูงกว่า M5 ในงานหลายด้าน พร้อมจอ Liquid Retina XDR ที่สวยคมชัด ดีลนี้ถูกยกให้เป็นราคาต่ำสุดที่เคยมีมา เหมาะกับคนที่อยากได้เครื่องแรง ๆ ในราคาที่จับต้องได้มากขึ้น

🔗 https://www.techradar.com/computing/macbooks/i-review-laptops-for-a-living-and-a-record-low-price-on-the-16-inch-macbook-pro-is-actually-worth-seeing

🚁 DJI Mini 4K – โดรนเริ่มต้นที่ดีที่สุด

สำหรับใครที่อยากลองเล่นโดรน DJI Mini 4K ถูกยกให้เป็นตัวเลือกที่เหมาะที่สุดสำหรับมือใหม่ และตอนนี้ราคาลดเหลือเพียง 239 ดอลลาร์ในสหรัฐฯ หรือ 215 ปอนด์ในอังกฤษ จุดเด่นคือกล้อง 4K พร้อมกิมบอล 3 แกน ทำให้ภาพวิดีโอออกมานิ่งและคมชัด มีโหมดบินอัตโนมัติที่ช่วยให้ถ่ายช็อตสวย ๆ ได้ง่าย และยังทนลมระดับ 5 ได้อีกด้วย ถือเป็นดีลที่คุ้มค่ามากสำหรับคนที่อยากเริ่มต้นถ่ายภาพมุมสูงโดยไม่ต้องลงทุนสูง

🔗 https://www.techradar.com/cameras/drones/ive-found-your-best-first-drone-for-a-record-low-price-the-dji-mini-4k-at-amazon

🕶️ Ray-Ban Meta Glasses ราคาต่ำสุด

แว่นตาอัจฉริยะ Ray-Ban Meta ที่หลายคนชื่นชอบ ตอนนี้ลดราคาลงเหลือเพียง 238.99 ดอลลาร์สำหรับรุ่นเลนส์ใส และ 303.20 ดอลลาร์สำหรับรุ่นเลนส์ปรับแสง (Transitions) ซึ่งเหมาะกับการใช้งานได้ทุกสภาพแสง ฟีเจอร์เด่นคือมีลำโพงแบบเปิดหู กล้องถ่ายภาพและวิดีโอจากมุมมองบุคคลที่หนึ่ง และยังมี AI ช่วยแปลภาษา ตอบคำถาม หรือบอกข้อมูลสถานที่ผ่านฟังก์ชัน “Look and Ask” แม้แบตหมดก็ยังใช้เป็นแว่นกันแดดเท่ ๆ ได้

🔗 https://www.techradar.com/seasonal-sales/you-can-buy-ray-ban-meta-glasses-for-their-cheapest-ever-price-thanks-to-black-friday

🔐 ช่องโหว่ WhatsApp ทำข้อมูลผู้ใช้เสี่ยง

มีการค้นพบช่องโหว่ใน WhatsApp ที่ทำให้แฮกเกอร์สามารถดึงข้อมูลหมายเลขโทรศัพท์ผู้ใช้กว่า 3.5 พันล้านหมายเลขทั่วโลกออกมาได้ รวมถึงเข้าถึงโปรไฟล์และคีย์เข้ารหัสบางส่วนด้วย แม้ WhatsApp จะบอกว่าปัญหานี้ถูกแก้ไขแล้ว แต่เหตุการณ์นี้ก็สะท้อนให้เห็นถึงความเสี่ยงของการใช้แพลตฟอร์มสื่อสารที่มีผู้ใช้งานจำนวนมหาศาล ผู้เชี่ยวชาญแนะนำให้ผู้ใช้ตรวจสอบการตั้งค่าความเป็นส่วนตัว และอัปเดตแอปให้เป็นเวอร์ชันล่าสุดเสมอ

🔗 https://www.techradar.com/pro/whatsapp-security-flaw-lets-experts-scrape-3-5-billion-user-numbers-heres-what-we-know-and-how-to-stay-safe

🖥️ Nvidia เปิดทาง NVLink สู่ Arm CPU

Nvidia กำลังขยายการเชื่อมต่อ NVLink ให้ทำงานร่วมกับ Arm CPU ได้ ซึ่งถือเป็นการเปลี่ยนแปลงครั้งใหญ่ในโลกเซิร์ฟเวอร์และเวิร์กสเตชัน เพราะ NVLink ช่วยให้ GPU ทำงานร่วมกันได้อย่างรวดเร็วและมีประสิทธิภาพสูง การเปิดให้ Arm CPU ใช้งานได้จะทำให้ผู้ผลิตระบบ hyperscale สามารถออกแบบเครื่องที่ยืดหยุ่นและทรงพลังมากขึ้น เป็นการขยายตลาดที่น่าสนใจสำหรับทั้ง Nvidia และพันธมิตร

🔗 https://www.techradar.com/pro/is-nvidia-opening-up-its-nvlink-doors-even-further-new-partnership-with-amd-will-see-greater-integration-across-many-kinds-of-chips

🔊 ลำโพงบลูทูธเบสหนัก ราคาถูกลง

รีวิวลำโพงบลูทูธที่ขึ้นชื่อเรื่องเสียงเบสหนักแน่น ตอนนี้ลดราคาลงมากในช่วง Black Friday ทำให้เป็นตัวเลือกที่คุ้มค่าสำหรับคนที่อยากได้เสียงกระหึ่มในราคาที่จับต้องได้ จุดเด่นคือพลังเสียงที่ดังชัด ใช้งานได้ทั้งในบ้านและนอกบ้าน พร้อมแบตเตอรี่ที่อึดพอสมควร เหมาะกับสายปาร์ตี้หรือคนที่ชอบฟังเพลงแนว EDM และฮิปฮอป

🔗 https://www.techradar.com/audio/wireless-bluetooth-speakers/i-love-this-bass-heavy-bluetooth-speaker-and-its-cheaper-than-ever-for-black-friday

🎮 PlayStation Portal ราคาต่ำสุด พร้อมอัปเดตใหม่

PlayStation Portal เครื่องเล่นเกมพกพาที่เชื่อมต่อกับ PS5 ได้ ตอนนี้ลดราคาลงต่ำสุดตั้งแต่เปิดตัว และยังมาพร้อมอัปเดตซอฟต์แวร์ใหม่ที่ทำให้ประสบการณ์เล่นเกมดีขึ้นมาก การลดราคาครั้งนี้ทำให้หลายคนที่ลังเลก่อนหน้านี้ตัดสินใจซื้อได้ง่ายขึ้น ถือเป็นดีลที่น่าสนใจสำหรับแฟน PlayStation ที่อยากเล่นเกมจากเครื่องหลักได้ทุกที่

🔗 https://www.techradar.com/gaming/the-playstation-portal-has-hit-its-lowest-ever-price-for-black-friday-and-its-impossible-to-ignore-at-this-price-and-after-its-game-changing-update

📱 Comet AI Browser ลง Android แล้ว

เบราว์เซอร์ Comet AI ที่ใช้เทคโนโลยี AI ช่วยผู้ใช้ในการค้นหาและจัดการข้อมูล ตอนนี้เปิดตัวบน Android แล้ว จุดเด่นคือการใช้ AI ช่วยสรุปเนื้อหาเว็บ ค้นหาข้อมูลได้เร็วขึ้น และยังมีฟีเจอร์ช่วยจัดการแท็บให้เป็นระเบียบมากขึ้น การมาลง Android ทำให้ผู้ใช้มือถือสามารถเข้าถึงประสบการณ์การท่องเว็บที่ฉลาดขึ้นได้ทุกที่

🔗 https://www.techradar.com/ai-platforms-assistants/comet-ai-browser-lands-on-android

💰 บริษัทยักษ์เหมือง Bitcoin หันไปทำศูนย์ข้อมูล AI

หลังจากธุรกิจขุด Bitcoin ขาดทุนหนัก บริษัทเหมืองรายใหญ่ตัดสินใจปรับโมเดลธุรกิจใหม่ หันไปลงทุนสร้างศูนย์ข้อมูล AI มูลค่าหลายพันล้านดอลลาร์ การเปลี่ยนทิศทางนี้สะท้อนให้เห็นว่า AI กำลังกลายเป็นโอกาสใหม่ที่น่าสนใจกว่าการทำเหมืองคริปโต ซึ่งเผชิญกับต้นทุนสูงและความผันผวนของตลาด

🔗 https://www.techradar.com/pro/is-ai-more-appealing-than-crypto-now-a-major-bitcoin-miner-has-decided-to-pivot-to-ai-data-centers-heres-why