สหรัฐฯ vs จีนในสมรภูมิ AI: ทำไมหลายบริษัทอเมริกันกลับเลือกใช้โมเดลจากจีน

กระแสการแข่งขันด้านปัญญาประดิษฐ์ระหว่างสหรัฐฯ และจีนกำลังทวีความเข้มข้น แต่ในอีกมุมหนึ่ง บริษัทและนักพัฒนาจำนวนไม่น้อยในสหรัฐฯ กลับหันไปใช้โมเดล AI แบบโอเพ่นซอร์สจากจีนมากขึ้นเรื่อยๆ แม้จะมีแรงกดดันทางภูมิรัฐศาสตร์ก็ตาม โมเดลจากค่ายจีนอย่าง Alibaba Qwen, DeepSeek R1, MiniMax, และ Z.ai ได้รับความนิยมเพราะราคาถูกกว่า ปรับแต่งได้มากกว่า และให้ประสิทธิภาพที่ “ดีพอ” สำหรับงานส่วนใหญ่ที่ไม่ต้องการความล้ำหน้าระดับ OpenAI หรือ Google

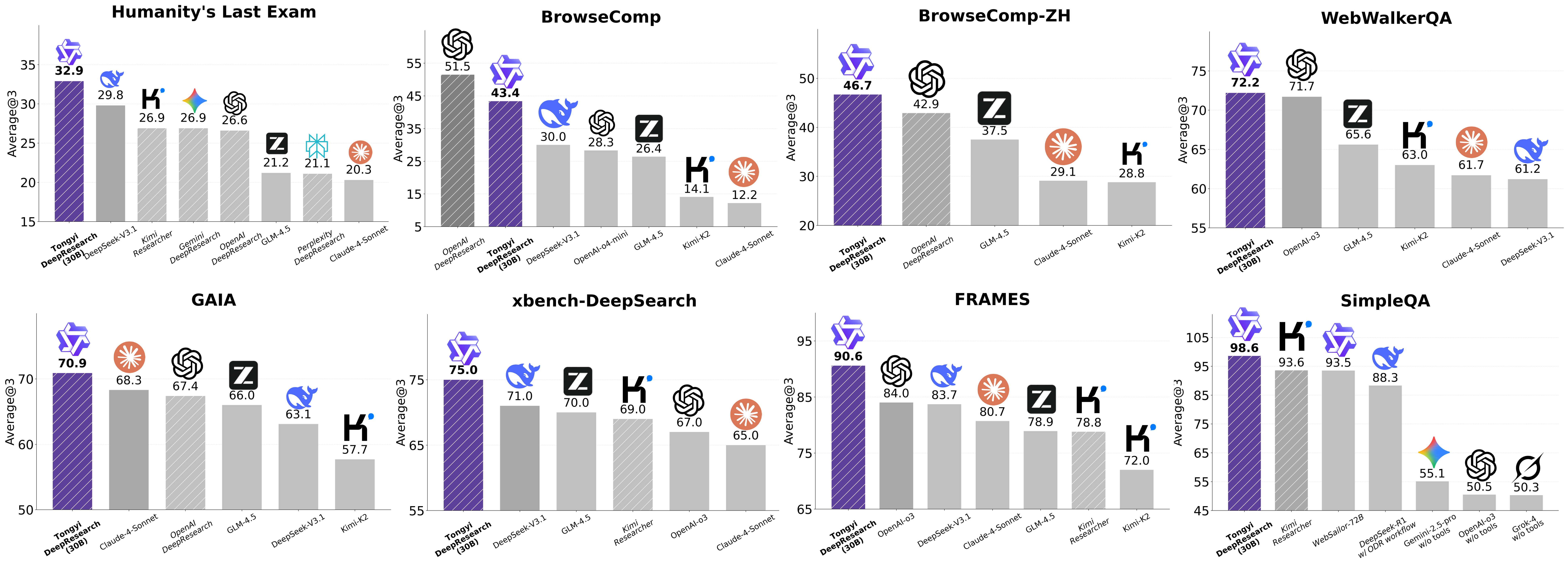

ในเวลาเดียวกัน การเติบโตของโมเดลโอเพ่นซอร์สจากจีนยังสะท้อนการเปลี่ยนแปลงเชิงกลยุทธ์ในอุตสาหกรรม AI ทั่วโลก จากเดิมที่สหรัฐฯ ครองความได้เปรียบด้านเทคโนโลยีอย่างชัดเจน แต่การเปิดตัวโมเดลอย่าง DeepSeek R1 ที่มีประสิทธิภาพสูงและต้นทุนต่ำ ทำให้หลายฝ่ายเริ่มตั้งคำถามว่า “จีนกำลังไล่ทันหรือแซงหน้าในบางด้านแล้วหรือไม่”

นอกจากนี้ รัฐบาลสหรัฐฯ เองก็เริ่มตระหนักถึงความสำคัญของโอเพ่นซอร์ส โดยออกแผน “AI Action Plan” เพื่อผลักดันโมเดลโอเพ่นซอร์สที่ยึดตามค่านิยมอเมริกัน แต่บริษัทใหญ่ในสหรัฐฯ กลับเดินไปในทิศทางตรงกันข้าม เช่น Meta ที่หันกลับไปเน้นโมเดลปิดมากขึ้น ขณะที่ฝั่งยุโรปอย่าง Mistral แม้ยังยืนหยัดในโอเพ่นซอร์ส แต่ก็ยังตามหลังจีนในด้านการใช้งานจริงทั่วโลก

อย่างไรก็ตาม แม้โมเดลจีนจะได้รับความนิยม แต่ก็ยังมีความกังวลด้านความเสี่ยง เช่น ความเป็นไปได้ของมาตรการคว่ำบาตรในอนาคต หรือความไม่มั่นใจของลูกค้าบางกลุ่มที่ไม่ต้องการใช้เทคโนโลยีจากจีน แม้ผู้เชี่ยวชาญหลายรายยืนยันว่าโมเดลโอเพ่นซอร์สเหล่านี้สามารถใช้งานได้โดยไม่ต้องเชื่อมต่อกับจีนโดยตรงก็ตาม

สรุปประเด็นสำคัญ

ความนิยมของโมเดลโอเพ่นซอร์สจากจีนเพิ่มขึ้นอย่างรวดเร็ว

การใช้งานทั่วโลกเพิ่มจาก 1.2% เป็นเกือบ 30% ภายในไม่ถึงปี

โมเดลอย่าง Qwen และ DeepSeek ได้รับความนิยมเพราะราคาถูกและปรับแต่งได้ดี

บริษัทสหรัฐฯ หลายแห่งหันมาใช้โมเดลจีน

ผู้ประกอบการบางรายประหยัดต้นทุนได้ถึง 400,000 ดอลลาร์ต่อปี

องค์กรใหญ่ เช่น Nvidia, Perplexity และ Stanford ก็ใช้ Qwen ในบางงาน

จีนก้าวหน้าในด้าน AI Agents และโมเดลรุ่นใหม่

โมเดล Kimi K2 และ DeepSeek R1 ถูกมองว่าเป็นแนวหน้าของยุค AI Agents

โมเดลจีนจำนวนมากเปิดให้ปรับแต่งได้มากกว่าโมเดลสหรัฐฯ

ความเสี่ยงด้านภูมิรัฐศาสตร์และการคว่ำบาตร

บริษัทกังวลว่าโมเดลจีนอาจถูกสหรัฐฯ แบนในอนาคต

ลูกค้าบางรายไม่มั่นใจเรื่องภาพลักษณ์และความสอดคล้องกับค่านิยมตะวันตก

ความไม่แน่นอนด้านทิศทางของบริษัทสหรัฐฯ

Meta หันกลับไปเน้นโมเดลปิด ทำให้ตลาดโอเพ่นซอร์สฝั่งตะวันตกอ่อนแรง

ความไม่ชัดเจนของนโยบายสหรัฐฯ อาจทำให้บริษัทลังเลในการเลือกเทคโนโลยี

https://www.thestar.com.my/tech/tech-news/2025/12/22/as-us-battles-china-on-ai-some-companies-choose-chinese

กระแสการแข่งขันด้านปัญญาประดิษฐ์ระหว่างสหรัฐฯ และจีนกำลังทวีความเข้มข้น แต่ในอีกมุมหนึ่ง บริษัทและนักพัฒนาจำนวนไม่น้อยในสหรัฐฯ กลับหันไปใช้โมเดล AI แบบโอเพ่นซอร์สจากจีนมากขึ้นเรื่อยๆ แม้จะมีแรงกดดันทางภูมิรัฐศาสตร์ก็ตาม โมเดลจากค่ายจีนอย่าง Alibaba Qwen, DeepSeek R1, MiniMax, และ Z.ai ได้รับความนิยมเพราะราคาถูกกว่า ปรับแต่งได้มากกว่า และให้ประสิทธิภาพที่ “ดีพอ” สำหรับงานส่วนใหญ่ที่ไม่ต้องการความล้ำหน้าระดับ OpenAI หรือ Google

ในเวลาเดียวกัน การเติบโตของโมเดลโอเพ่นซอร์สจากจีนยังสะท้อนการเปลี่ยนแปลงเชิงกลยุทธ์ในอุตสาหกรรม AI ทั่วโลก จากเดิมที่สหรัฐฯ ครองความได้เปรียบด้านเทคโนโลยีอย่างชัดเจน แต่การเปิดตัวโมเดลอย่าง DeepSeek R1 ที่มีประสิทธิภาพสูงและต้นทุนต่ำ ทำให้หลายฝ่ายเริ่มตั้งคำถามว่า “จีนกำลังไล่ทันหรือแซงหน้าในบางด้านแล้วหรือไม่”

นอกจากนี้ รัฐบาลสหรัฐฯ เองก็เริ่มตระหนักถึงความสำคัญของโอเพ่นซอร์ส โดยออกแผน “AI Action Plan” เพื่อผลักดันโมเดลโอเพ่นซอร์สที่ยึดตามค่านิยมอเมริกัน แต่บริษัทใหญ่ในสหรัฐฯ กลับเดินไปในทิศทางตรงกันข้าม เช่น Meta ที่หันกลับไปเน้นโมเดลปิดมากขึ้น ขณะที่ฝั่งยุโรปอย่าง Mistral แม้ยังยืนหยัดในโอเพ่นซอร์ส แต่ก็ยังตามหลังจีนในด้านการใช้งานจริงทั่วโลก

อย่างไรก็ตาม แม้โมเดลจีนจะได้รับความนิยม แต่ก็ยังมีความกังวลด้านความเสี่ยง เช่น ความเป็นไปได้ของมาตรการคว่ำบาตรในอนาคต หรือความไม่มั่นใจของลูกค้าบางกลุ่มที่ไม่ต้องการใช้เทคโนโลยีจากจีน แม้ผู้เชี่ยวชาญหลายรายยืนยันว่าโมเดลโอเพ่นซอร์สเหล่านี้สามารถใช้งานได้โดยไม่ต้องเชื่อมต่อกับจีนโดยตรงก็ตาม

สรุปประเด็นสำคัญ

ความนิยมของโมเดลโอเพ่นซอร์สจากจีนเพิ่มขึ้นอย่างรวดเร็ว

การใช้งานทั่วโลกเพิ่มจาก 1.2% เป็นเกือบ 30% ภายในไม่ถึงปี

โมเดลอย่าง Qwen และ DeepSeek ได้รับความนิยมเพราะราคาถูกและปรับแต่งได้ดี

บริษัทสหรัฐฯ หลายแห่งหันมาใช้โมเดลจีน

ผู้ประกอบการบางรายประหยัดต้นทุนได้ถึง 400,000 ดอลลาร์ต่อปี

องค์กรใหญ่ เช่น Nvidia, Perplexity และ Stanford ก็ใช้ Qwen ในบางงาน

จีนก้าวหน้าในด้าน AI Agents และโมเดลรุ่นใหม่

โมเดล Kimi K2 และ DeepSeek R1 ถูกมองว่าเป็นแนวหน้าของยุค AI Agents

โมเดลจีนจำนวนมากเปิดให้ปรับแต่งได้มากกว่าโมเดลสหรัฐฯ

ความเสี่ยงด้านภูมิรัฐศาสตร์และการคว่ำบาตร

บริษัทกังวลว่าโมเดลจีนอาจถูกสหรัฐฯ แบนในอนาคต

ลูกค้าบางรายไม่มั่นใจเรื่องภาพลักษณ์และความสอดคล้องกับค่านิยมตะวันตก

ความไม่แน่นอนด้านทิศทางของบริษัทสหรัฐฯ

Meta หันกลับไปเน้นโมเดลปิด ทำให้ตลาดโอเพ่นซอร์สฝั่งตะวันตกอ่อนแรง

ความไม่ชัดเจนของนโยบายสหรัฐฯ อาจทำให้บริษัทลังเลในการเลือกเทคโนโลยี

https://www.thestar.com.my/tech/tech-news/2025/12/22/as-us-battles-china-on-ai-some-companies-choose-chinese

🧭 สหรัฐฯ vs จีนในสมรภูมิ AI: ทำไมหลายบริษัทอเมริกันกลับเลือกใช้โมเดลจากจีน

กระแสการแข่งขันด้านปัญญาประดิษฐ์ระหว่างสหรัฐฯ และจีนกำลังทวีความเข้มข้น แต่ในอีกมุมหนึ่ง บริษัทและนักพัฒนาจำนวนไม่น้อยในสหรัฐฯ กลับหันไปใช้โมเดล AI แบบโอเพ่นซอร์สจากจีนมากขึ้นเรื่อยๆ แม้จะมีแรงกดดันทางภูมิรัฐศาสตร์ก็ตาม โมเดลจากค่ายจีนอย่าง Alibaba Qwen, DeepSeek R1, MiniMax, และ Z.ai ได้รับความนิยมเพราะราคาถูกกว่า ปรับแต่งได้มากกว่า และให้ประสิทธิภาพที่ “ดีพอ” สำหรับงานส่วนใหญ่ที่ไม่ต้องการความล้ำหน้าระดับ OpenAI หรือ Google

ในเวลาเดียวกัน การเติบโตของโมเดลโอเพ่นซอร์สจากจีนยังสะท้อนการเปลี่ยนแปลงเชิงกลยุทธ์ในอุตสาหกรรม AI ทั่วโลก จากเดิมที่สหรัฐฯ ครองความได้เปรียบด้านเทคโนโลยีอย่างชัดเจน แต่การเปิดตัวโมเดลอย่าง DeepSeek R1 ที่มีประสิทธิภาพสูงและต้นทุนต่ำ ทำให้หลายฝ่ายเริ่มตั้งคำถามว่า “จีนกำลังไล่ทันหรือแซงหน้าในบางด้านแล้วหรือไม่”

นอกจากนี้ รัฐบาลสหรัฐฯ เองก็เริ่มตระหนักถึงความสำคัญของโอเพ่นซอร์ส โดยออกแผน “AI Action Plan” เพื่อผลักดันโมเดลโอเพ่นซอร์สที่ยึดตามค่านิยมอเมริกัน แต่บริษัทใหญ่ในสหรัฐฯ กลับเดินไปในทิศทางตรงกันข้าม เช่น Meta ที่หันกลับไปเน้นโมเดลปิดมากขึ้น ขณะที่ฝั่งยุโรปอย่าง Mistral แม้ยังยืนหยัดในโอเพ่นซอร์ส แต่ก็ยังตามหลังจีนในด้านการใช้งานจริงทั่วโลก

อย่างไรก็ตาม แม้โมเดลจีนจะได้รับความนิยม แต่ก็ยังมีความกังวลด้านความเสี่ยง เช่น ความเป็นไปได้ของมาตรการคว่ำบาตรในอนาคต หรือความไม่มั่นใจของลูกค้าบางกลุ่มที่ไม่ต้องการใช้เทคโนโลยีจากจีน แม้ผู้เชี่ยวชาญหลายรายยืนยันว่าโมเดลโอเพ่นซอร์สเหล่านี้สามารถใช้งานได้โดยไม่ต้องเชื่อมต่อกับจีนโดยตรงก็ตาม

📌 สรุปประเด็นสำคัญ

✅ ความนิยมของโมเดลโอเพ่นซอร์สจากจีนเพิ่มขึ้นอย่างรวดเร็ว

➡️ การใช้งานทั่วโลกเพิ่มจาก 1.2% เป็นเกือบ 30% ภายในไม่ถึงปี

➡️ โมเดลอย่าง Qwen และ DeepSeek ได้รับความนิยมเพราะราคาถูกและปรับแต่งได้ดี

✅ บริษัทสหรัฐฯ หลายแห่งหันมาใช้โมเดลจีน

➡️ ผู้ประกอบการบางรายประหยัดต้นทุนได้ถึง 400,000 ดอลลาร์ต่อปี

➡️ องค์กรใหญ่ เช่น Nvidia, Perplexity และ Stanford ก็ใช้ Qwen ในบางงาน

✅ จีนก้าวหน้าในด้าน AI Agents และโมเดลรุ่นใหม่

➡️ โมเดล Kimi K2 และ DeepSeek R1 ถูกมองว่าเป็นแนวหน้าของยุค AI Agents

➡️ โมเดลจีนจำนวนมากเปิดให้ปรับแต่งได้มากกว่าโมเดลสหรัฐฯ

‼️ ความเสี่ยงด้านภูมิรัฐศาสตร์และการคว่ำบาตร

⛔ บริษัทกังวลว่าโมเดลจีนอาจถูกสหรัฐฯ แบนในอนาคต

⛔ ลูกค้าบางรายไม่มั่นใจเรื่องภาพลักษณ์และความสอดคล้องกับค่านิยมตะวันตก

‼️ ความไม่แน่นอนด้านทิศทางของบริษัทสหรัฐฯ

⛔ Meta หันกลับไปเน้นโมเดลปิด ทำให้ตลาดโอเพ่นซอร์สฝั่งตะวันตกอ่อนแรง

⛔ ความไม่ชัดเจนของนโยบายสหรัฐฯ อาจทำให้บริษัทลังเลในการเลือกเทคโนโลยี

https://www.thestar.com.my/tech/tech-news/2025/12/22/as-us-battles-china-on-ai-some-companies-choose-chinese

0 ความคิดเห็น

0 การแบ่งปัน

22 มุมมอง

0 รีวิว