0 Comments

0 Shares

130 Views

0 Reviews

Directory

Discover new people, create new connections and make new friends

- Please log in to like, share and comment!

-

ชีวิต...ไม่มีอะไรขาวสะอาดที่สุด

Cr.Wiwan Boonya

ชีวิต...ไม่มีอะไรขาวสะอาดที่สุด Cr.Wiwan Boonya0 Comments 0 Shares 78 Views 0 Reviews - FENGSHUI DAILY

อัพเดตทุกวัน ที่นี่ที่เดียว

สีเสริมดวง เสริมความเฮง

ทิศมงคล เวลามงคล

อย่าลืมดูกัน เมื่อเริ่มวันใหม่

วันศุกร์ที่ 25 เดือนเมษายน พ.ศ.2568

___________________________________

FengshuiBizDesigner

ฮวงจุ้ย...ออกแบบได้

เช็คฮวงจุ้ยให้ธุรกิจ แอดเลย!! คลิก https://lin.ee/nyL0NuG

ติดต่อ : 066-095-4524 (จิม) , 081-625-2587(ด็อง)

.

.

#ดูดวงธุรกิจ #โลโก้ดี #ออกแบบโลโก้ #เช็คฮวงจุ้ยให้ธุรกิจ #ฮวงจุ้ย #พี่อ๋า #สมศักดิ์ #ชาคริตฐากูร

#FengshuiBiz #FengshuiBizDesignerFENGSHUI DAILY อัพเดตทุกวัน ที่นี่ที่เดียว สีเสริมดวง เสริมความเฮง ทิศมงคล เวลามงคล อย่าลืมดูกัน เมื่อเริ่มวันใหม่ วันศุกร์ที่ 25 เดือนเมษายน พ.ศ.2568 ___________________________________ FengshuiBizDesigner ฮวงจุ้ย...ออกแบบได้ เช็คฮวงจุ้ยให้ธุรกิจ แอดเลย!! คลิก https://lin.ee/nyL0NuG ติดต่อ : 066-095-4524 (จิม) , 081-625-2587(ด็อง) . . #ดูดวงธุรกิจ #โลโก้ดี #ออกแบบโลโก้ #เช็คฮวงจุ้ยให้ธุรกิจ #ฮวงจุ้ย #พี่อ๋า #สมศักดิ์ #ชาคริตฐากูร #FengshuiBiz #FengshuiBizDesigner0 Comments 0 Shares 146 Views 0 Reviews - “ส่วนเกินของความเครียด” ซึ่งเป็นตัวถ่วงสำคัญที่ทำให้ปัญหาเล็กกลายเป็นภูเขา และทำให้ชีวิตหมุนวนในทุกข์โดยไม่จำเป็น

---

1. จุดเริ่มของทุกข์คือ “เครียดก่อนคิด”

> “ยังไม่ทันแก้ปัญหา แต่ใจด่วนตกอยู่ในความเครียด นี่คือทุกข์ส่วนเกินที่ไม่มีประโยชน์”

ธรรมะประโยคนี้พาเรารู้ว่า

เครียดไม่ใช่สิ่งผิดเสมอไป

แต่ เครียดก่อนคิด = เครียดฟรี และสร้าง “ภาพหลอน” ให้ปัญหาดูหนักกว่าความเป็นจริง

> ธรรมะสำคัญ:

“คิดหนึ่ง แต่เครียดเก้า” = ใช้พลังงานจิตไปกับความฟุ้งซ่านแทนการแก้ไข

---

2. ส่วนเกินอยู่ที่ไหน? เริ่มหาจากกายก่อนใจ

> “ฝ่ามือ ฝ่าเท้า หัวคิ้ว คือจุดสังเกต ‘กายสะท้อนใจ’ อย่างชัดเจน”

หลักเจริญสติ:

สังเกตอาการทางกาย เช่น ขมวดคิ้ว กำมือ เกร็งเท้า

คือร่องรอยของ อารมณ์ที่ยังไม่รู้ตัว

> การ “รู้” แล้ว “คลาย” คือการ ตัดตอนพลังลบทางกายและใจ

เหมือนปลดเบรกมือออกก่อนจะออกรถ

---

3. ฝึกเฝ้าสังเกต = ฝึกใจให้กลับสู่ความสงบ

วิธีปฏิบัติที่แนะนำ:

1. สังเกตจุดเครียดประจำกาย เช่น หัวคิ้ว – ฝ่ามือ – ไหล่

2. รู้ทันและคลายทันที – ไม่ดึงยาว

3. ดูผลกระทบ ว่าเมื่อคลายกาย ใจเบาขึ้นไหม

4. ดูต่อว่าใจเบาเพราะหนีปัญหา หรือพร้อมเผชิญด้วยสติ

> นี่คือสติที่ “ละเอียด” และ “ใช้งานจริง” ได้ในทุกวัน

---

4. ผลลัพธ์: เย็นก่อน จึงเห็นก่อน และจึงแก้ได้จริง

เมื่อเย็น → จิตไม่ถูกผลักด้วยโทสะ

เมื่อไม่รีบโกรธ → ใจยังกล้าเผชิญโดยไม่สั่นไหว

เมื่อใจยังสงบแม้อยู่ในความวุ่นวาย → ชีวิตจะค่อยๆ เป็นระเบียบจากภายใน

> ธรรมะสั้น:

“จิตที่สงบในปัญหา = จิตที่ปลอดภัยจากการหลงทาง”

---

5. สรุปใจกลางธรรมะในบทความนี้

ทุกข์ส่วนเกินมาจาก “ความคิดปนเครียดก่อนมีสติ”

“กาย” คือกระจกสะท้อนความฟุ้งซ่านที่ไวที่สุด

การฝึกคลายกาย คือจุดเริ่มต้นของการฟื้นฟูใจ

ความสงบไม่ใช่สิ่งไกลตัว แต่เป็นสิ่งที่ “ลืมใช้มานาน”

ความเย็นคือภาวะพื้นฐานเดิมแท้ของจิตที่ยังไม่ถูกครอบด้วยกิเลส

---

คำคมธรรมะจากบทความ (พร้อมใช้ในโพสต์หรือหนังสือ)

“เครียดก่อนคิด คือทุกข์ที่เกิดโดยไม่จำเป็น”

“ขมวดคิ้วแน่นเท่าไร ใจก็มัวเท่านั้น”

“ปล่อยส่วนเกิน คือคืนพื้นที่ใจให้ปัญญาได้ทำงาน”

“เมื่อคลายกาย ใจจึงพร้อมจะกล้าเผชิญ”

“ความเย็นเคยอยู่ในใจคุณ เพียงแต่ไม่ได้ใช้มานาน”“ส่วนเกินของความเครียด” ซึ่งเป็นตัวถ่วงสำคัญที่ทำให้ปัญหาเล็กกลายเป็นภูเขา และทำให้ชีวิตหมุนวนในทุกข์โดยไม่จำเป็น --- 1. จุดเริ่มของทุกข์คือ “เครียดก่อนคิด” > “ยังไม่ทันแก้ปัญหา แต่ใจด่วนตกอยู่ในความเครียด นี่คือทุกข์ส่วนเกินที่ไม่มีประโยชน์” ธรรมะประโยคนี้พาเรารู้ว่า เครียดไม่ใช่สิ่งผิดเสมอไป แต่ เครียดก่อนคิด = เครียดฟรี และสร้าง “ภาพหลอน” ให้ปัญหาดูหนักกว่าความเป็นจริง > ธรรมะสำคัญ: “คิดหนึ่ง แต่เครียดเก้า” = ใช้พลังงานจิตไปกับความฟุ้งซ่านแทนการแก้ไข --- 2. ส่วนเกินอยู่ที่ไหน? เริ่มหาจากกายก่อนใจ > “ฝ่ามือ ฝ่าเท้า หัวคิ้ว คือจุดสังเกต ‘กายสะท้อนใจ’ อย่างชัดเจน” หลักเจริญสติ: สังเกตอาการทางกาย เช่น ขมวดคิ้ว กำมือ เกร็งเท้า คือร่องรอยของ อารมณ์ที่ยังไม่รู้ตัว > การ “รู้” แล้ว “คลาย” คือการ ตัดตอนพลังลบทางกายและใจ เหมือนปลดเบรกมือออกก่อนจะออกรถ --- 3. ฝึกเฝ้าสังเกต = ฝึกใจให้กลับสู่ความสงบ วิธีปฏิบัติที่แนะนำ: 1. สังเกตจุดเครียดประจำกาย เช่น หัวคิ้ว – ฝ่ามือ – ไหล่ 2. รู้ทันและคลายทันที – ไม่ดึงยาว 3. ดูผลกระทบ ว่าเมื่อคลายกาย ใจเบาขึ้นไหม 4. ดูต่อว่าใจเบาเพราะหนีปัญหา หรือพร้อมเผชิญด้วยสติ > นี่คือสติที่ “ละเอียด” และ “ใช้งานจริง” ได้ในทุกวัน --- 4. ผลลัพธ์: เย็นก่อน จึงเห็นก่อน และจึงแก้ได้จริง เมื่อเย็น → จิตไม่ถูกผลักด้วยโทสะ เมื่อไม่รีบโกรธ → ใจยังกล้าเผชิญโดยไม่สั่นไหว เมื่อใจยังสงบแม้อยู่ในความวุ่นวาย → ชีวิตจะค่อยๆ เป็นระเบียบจากภายใน > ธรรมะสั้น: “จิตที่สงบในปัญหา = จิตที่ปลอดภัยจากการหลงทาง” --- 5. สรุปใจกลางธรรมะในบทความนี้ ทุกข์ส่วนเกินมาจาก “ความคิดปนเครียดก่อนมีสติ” “กาย” คือกระจกสะท้อนความฟุ้งซ่านที่ไวที่สุด การฝึกคลายกาย คือจุดเริ่มต้นของการฟื้นฟูใจ ความสงบไม่ใช่สิ่งไกลตัว แต่เป็นสิ่งที่ “ลืมใช้มานาน” ความเย็นคือภาวะพื้นฐานเดิมแท้ของจิตที่ยังไม่ถูกครอบด้วยกิเลส --- คำคมธรรมะจากบทความ (พร้อมใช้ในโพสต์หรือหนังสือ) “เครียดก่อนคิด คือทุกข์ที่เกิดโดยไม่จำเป็น” “ขมวดคิ้วแน่นเท่าไร ใจก็มัวเท่านั้น” “ปล่อยส่วนเกิน คือคืนพื้นที่ใจให้ปัญญาได้ทำงาน” “เมื่อคลายกาย ใจจึงพร้อมจะกล้าเผชิญ” “ความเย็นเคยอยู่ในใจคุณ เพียงแต่ไม่ได้ใช้มานาน”0 Comments 0 Shares 437 Views 0 Reviews - 0 Comments 0 Shares 56 Views 0 Reviews

- เพื่อตอบสนองต่อการที่เซเลนสกีและยุโรป ปฏิเสธยอมรับไครเมียเป็นของรัสเซีย

เมื่อช่วงเช้ามืดที่ผ่านมาจนถึงขณะนี้ มีรายงานการโจมตีทั่วทั้งภูมิภาคของประเทศ

โดรนพลีชีพนำโดย Shahed ถูกปล่อยออกมาหลายระลอก จากการรายงานของประชาชนในพื้นที่ แต่ละครั้งมีมากกว่า 50 ลำ

นอกจากนี้ กองทัพอากาศยูเครนยืนยันการยิงขีปนาวุธจากเครื่องบินทิ้งระเบิดเชิงยุทธศาสตร์ของรัสเซีย Tu-95 4 ลำ และ Tu-160 3 ลำ

ภาพวิดีโอการระเบิดในเคียฟ เมืองหลวงของยูเครนจากการโจมตีของรัสเซียเพื่อตอบสนองต่อการที่เซเลนสกีและยุโรป ปฏิเสธยอมรับไครเมียเป็นของรัสเซีย เมื่อช่วงเช้ามืดที่ผ่านมาจนถึงขณะนี้ มีรายงานการโจมตีทั่วทั้งภูมิภาคของประเทศ โดรนพลีชีพนำโดย Shahed ถูกปล่อยออกมาหลายระลอก จากการรายงานของประชาชนในพื้นที่ แต่ละครั้งมีมากกว่า 50 ลำ นอกจากนี้ กองทัพอากาศยูเครนยืนยันการยิงขีปนาวุธจากเครื่องบินทิ้งระเบิดเชิงยุทธศาสตร์ของรัสเซีย Tu-95 4 ลำ และ Tu-160 3 ลำ ภาพวิดีโอการระเบิดในเคียฟ เมืองหลวงของยูเครนจากการโจมตีของรัสเซีย0 Comments 0 Shares 242 Views 0 Reviews1

- เมื่ออินฟลูฯเป็นตุลาการของสังคม

บทความโดย : สุรวิชช์ วีรวรรณ

คลิก>> https://mgronline.com/daily/detail/9680000038265เมื่ออินฟลูฯเป็นตุลาการของสังคม บทความโดย : สุรวิชช์ วีรวรรณ คลิก>> https://mgronline.com/daily/detail/9680000038265MGRONLINE.COMเมื่ออินฟลูฯ เป็นตุลาการของสังคมทุกวันนี้เวลามีทุกข์ยากสังคมไทยมักจะพึ่งพาอินฟลูเอนเซอร์ เช่น กัน จอมพลัง, หนุ่ม กรรชัย หรือกลุ่มสายไหมต้องรอด ฯลฯ หรือในอดีต เช่น ทนายตั้มหรือศรีสุวรรณ จรรยา ทนายโน่นนี่นั่นที่ทำมาหากินหาลูกความผ่านโซเชียล มากกว่าการพึ่งพาหน่วยงา0 Comments 0 Shares 293 Views 0 Reviews2

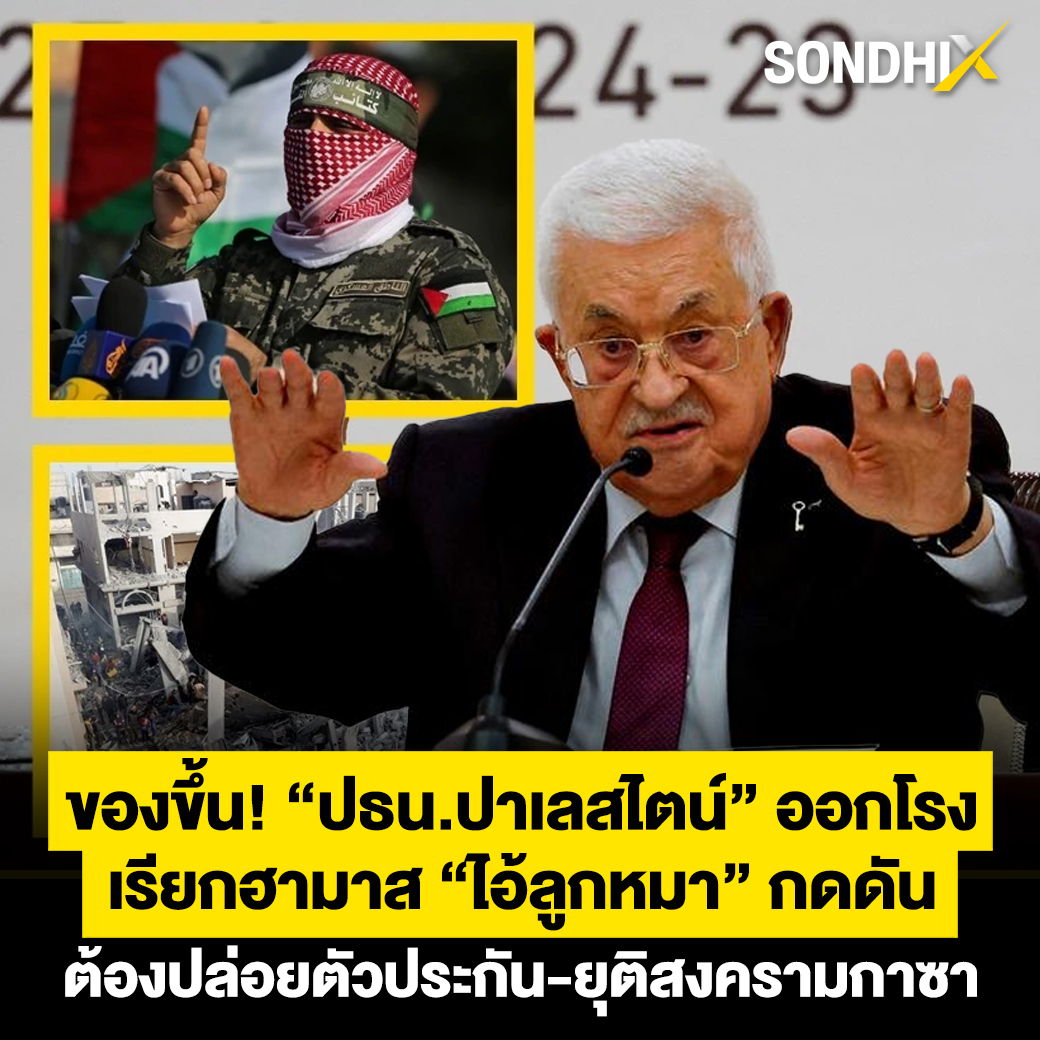

- ประธานาธิบดีปาเลสไตน์ มาห์มู๊ด อับบาส ออกมากดดันให้กลุ่มติดอาวุธฮามาสปล่อยตัวประกันทั้งหมด วางอาวุธ และยอมส่งมอบการควบคุมกาซาเพื่อยุติสงครามปาเลสไตน์ที่ยืดเยื้อ ขณะที่สื่อซาอุฯเผย ฮามาสได้รับสมัครกลุ่มนักรบเป็นวัยรุ่นปาเลสไตน์ร่วม 30,000 คนเข้ากลุ่มเพื่อไปรบ

.

อ่านเพิ่มเติม..https://sondhitalk.com/detail/9680000038271

#Sondhitalk #SondhiX #คุยทุกเรื่องกับสนธิ #Thaitimesประธานาธิบดีปาเลสไตน์ มาห์มู๊ด อับบาส ออกมากดดันให้กลุ่มติดอาวุธฮามาสปล่อยตัวประกันทั้งหมด วางอาวุธ และยอมส่งมอบการควบคุมกาซาเพื่อยุติสงครามปาเลสไตน์ที่ยืดเยื้อ ขณะที่สื่อซาอุฯเผย ฮามาสได้รับสมัครกลุ่มนักรบเป็นวัยรุ่นปาเลสไตน์ร่วม 30,000 คนเข้ากลุ่มเพื่อไปรบ . อ่านเพิ่มเติม..https://sondhitalk.com/detail/9680000038271 #Sondhitalk #SondhiX #คุยทุกเรื่องกับสนธิ #Thaitimes0 Comments 0 Shares 1360 Views 0 Reviews 6

6

- 0 Comments 0 Shares 64 Views 0 0 Reviews

- รัฐมนตรีคลัง สกอตต์ เบสเซนต์ ของสหรัฐฯ กล่าวยอมรับระหว่างกล่าวปราศรัยแบบเป็นการภายในเมื่อวันอังคาร (22 เม.ย.) ว่า การประจันหน้าเล่นงานจีนด้วยภาษีศุลกากรที่กำลังดำเนินอยู่ในเวลานี้ เป็นสิ่งที่ไม่อาจกระทำอย่างยืนยาวได้ และเขาคาดหมายว่าจะมี “การลดระดับ” ในสงครามการค้าระหว่าง 2 ประเทศที่เป็นเจ้าของระบบเศรษฐกิจใหญ่อันดับ 1 และอันดับ 2 ของโลก

.

อ่านเพิ่มเติม..https://sondhitalk.com/detail/9680000038272

#Sondhitalk #SondhiX #คุยทุกเรื่องกับสนธิ #Thaitimesรัฐมนตรีคลัง สกอตต์ เบสเซนต์ ของสหรัฐฯ กล่าวยอมรับระหว่างกล่าวปราศรัยแบบเป็นการภายในเมื่อวันอังคาร (22 เม.ย.) ว่า การประจันหน้าเล่นงานจีนด้วยภาษีศุลกากรที่กำลังดำเนินอยู่ในเวลานี้ เป็นสิ่งที่ไม่อาจกระทำอย่างยืนยาวได้ และเขาคาดหมายว่าจะมี “การลดระดับ” ในสงครามการค้าระหว่าง 2 ประเทศที่เป็นเจ้าของระบบเศรษฐกิจใหญ่อันดับ 1 และอันดับ 2 ของโลก . อ่านเพิ่มเติม..https://sondhitalk.com/detail/9680000038272 #Sondhitalk #SondhiX #คุยทุกเรื่องกับสนธิ #Thaitimes0 Comments 0 Shares 1359 Views 0 Reviews

9

9

- AMD ได้ประกาศว่าจะเปิดตัวผลิตภัณฑ์และเทคโนโลยีใหม่ในงาน Computex 2025 ที่จะจัดขึ้นในวันที่ 21 พฤษภาคม โดยมีการเปิดเผยว่าจะมีการนำเสนอผลิตภัณฑ์ที่เกี่ยวข้องกับ AI-powered PCs, เกม, และ โซลูชันสำหรับศูนย์ข้อมูล AI นอกจากนี้ยังมีการคาดการณ์ว่า AMD อาจเปิดตัวกราฟิกการ์ดรุ่นใหม่ในซีรีส์ Radeon RX 9000 เช่น RX 9060 XT และโปรเซสเซอร์ Gordon Point ที่ออกแบบมาเพื่อการใช้งาน AI

AMD จะเปิดตัวผลิตภัณฑ์ใหม่ในงาน Computex 2025

- ผลิตภัณฑ์ที่เกี่ยวข้องกับ AI-powered PCs และโซลูชันสำหรับศูนย์ข้อมูล AI

- การนำเสนอเทคโนโลยีใหม่สำหรับเกมบนเดสก์ท็อป มือถือ และอุปกรณ์พกพา

การคาดการณ์เกี่ยวกับผลิตภัณฑ์ใหม่

- AMD อาจเปิดตัวกราฟิกการ์ด RX 9060 XT ในงานนี้

- โปรเซสเซอร์ Gordon Point ที่ออกแบบมาเพื่อการใช้งาน AI

การร่วมมือกับผู้นำในอุตสาหกรรม

- Jack Huynh รองประธานอาวุโสของ AMD จะร่วมมือกับผู้นำในอุตสาหกรรมเพื่อเปิดตัวผลิตภัณฑ์

การจัดงานเพิ่มเติมในเดือนมิถุนายน

- AMD จะจัดงานแยกต่างหากในวันที่ 12 มิถุนายน โดยมี Lisa Su เป็นผู้ดำเนินการ

https://www.neowin.net/news/amd-confirms-new-product-announcements-at-computex-2025-in-may/AMD ได้ประกาศว่าจะเปิดตัวผลิตภัณฑ์และเทคโนโลยีใหม่ในงาน Computex 2025 ที่จะจัดขึ้นในวันที่ 21 พฤษภาคม โดยมีการเปิดเผยว่าจะมีการนำเสนอผลิตภัณฑ์ที่เกี่ยวข้องกับ AI-powered PCs, เกม, และ โซลูชันสำหรับศูนย์ข้อมูล AI นอกจากนี้ยังมีการคาดการณ์ว่า AMD อาจเปิดตัวกราฟิกการ์ดรุ่นใหม่ในซีรีส์ Radeon RX 9000 เช่น RX 9060 XT และโปรเซสเซอร์ Gordon Point ที่ออกแบบมาเพื่อการใช้งาน AI ✅ AMD จะเปิดตัวผลิตภัณฑ์ใหม่ในงาน Computex 2025 - ผลิตภัณฑ์ที่เกี่ยวข้องกับ AI-powered PCs และโซลูชันสำหรับศูนย์ข้อมูล AI - การนำเสนอเทคโนโลยีใหม่สำหรับเกมบนเดสก์ท็อป มือถือ และอุปกรณ์พกพา ✅ การคาดการณ์เกี่ยวกับผลิตภัณฑ์ใหม่ - AMD อาจเปิดตัวกราฟิกการ์ด RX 9060 XT ในงานนี้ - โปรเซสเซอร์ Gordon Point ที่ออกแบบมาเพื่อการใช้งาน AI ✅ การร่วมมือกับผู้นำในอุตสาหกรรม - Jack Huynh รองประธานอาวุโสของ AMD จะร่วมมือกับผู้นำในอุตสาหกรรมเพื่อเปิดตัวผลิตภัณฑ์ ✅ การจัดงานเพิ่มเติมในเดือนมิถุนายน - AMD จะจัดงานแยกต่างหากในวันที่ 12 มิถุนายน โดยมี Lisa Su เป็นผู้ดำเนินการ https://www.neowin.net/news/amd-confirms-new-product-announcements-at-computex-2025-in-may/WWW.NEOWIN.NETAMD confirms new product announcements at Computex 2025 in MayAMD fans should mark May 21 on the calendar as the company has just confirmed its presence and product announcements at Computex 2025.0 Comments 0 Shares 528 Views 0 Reviews - Google Slides ได้เปิดตัวเทมเพลตใหม่ที่มีการออกแบบอย่างมืออาชีพ เพื่อช่วยให้ผู้ใช้งานสามารถสร้างงานนำเสนอได้ง่ายขึ้น โดยเทมเพลตเหล่านี้ครอบคลุมการใช้งานหลากหลาย เช่น การนำเสนอแผนธุรกิจ การเสนอขายผลิตภัณฑ์ การวางแผนการตลาด การทบทวนรายไตรมาส การแนะนำทีมงาน หรือการเฉลิมฉลองความสำเร็จ เทมเพลตใหม่เหล่านี้ช่วยให้ผู้ใช้งานสามารถเริ่มต้นการสร้างงานนำเสนอได้อย่างรวดเร็วและมีความสอดคล้องในรูปแบบการออกแบบ

เทมเพลตใหม่ช่วยเพิ่มความสะดวกในการสร้างงานนำเสนอ

- ผู้ใช้งานสามารถเลือกเทมเพลตที่เหมาะสมกับสไตล์และวัตถุประสงค์

- เทมเพลตช่วยลดเวลาในการออกแบบและเพิ่มความเป็นมืออาชีพ

การใช้งานเทมเพลตใน Google Workspace

- เทมเพลตใหม่สามารถใช้งานได้ใน Google Workspace ทั้งบัญชีธุรกิจและบัญชีส่วนตัว

- ผู้ใช้งานต้องตั้งค่าภาษาเป็น "English (United States)" เพื่อเข้าถึงเทมเพลต

การเปิดตัวเทมเพลตใหม่ในเดือนเมษายน 2025

- เริ่มต้นใน Rapid Release domains และจะขยายไปยัง Scheduled Release domains ตั้งแต่วันที่ 6 พฤษภาคม

การออกแบบที่ครอบคลุมการใช้งานหลากหลาย

- เทมเพลตครอบคลุมการใช้งาน เช่น การนำเสนอแผนธุรกิจ การเสนอขายผลิตภัณฑ์ และการเฉลิมฉลองความสำเร็จ

https://www.neowin.net/news/google-slides-gets-more-high-quality-templates-to-elevate-your-presentations/Google Slides ได้เปิดตัวเทมเพลตใหม่ที่มีการออกแบบอย่างมืออาชีพ เพื่อช่วยให้ผู้ใช้งานสามารถสร้างงานนำเสนอได้ง่ายขึ้น โดยเทมเพลตเหล่านี้ครอบคลุมการใช้งานหลากหลาย เช่น การนำเสนอแผนธุรกิจ การเสนอขายผลิตภัณฑ์ การวางแผนการตลาด การทบทวนรายไตรมาส การแนะนำทีมงาน หรือการเฉลิมฉลองความสำเร็จ เทมเพลตใหม่เหล่านี้ช่วยให้ผู้ใช้งานสามารถเริ่มต้นการสร้างงานนำเสนอได้อย่างรวดเร็วและมีความสอดคล้องในรูปแบบการออกแบบ ✅ เทมเพลตใหม่ช่วยเพิ่มความสะดวกในการสร้างงานนำเสนอ - ผู้ใช้งานสามารถเลือกเทมเพลตที่เหมาะสมกับสไตล์และวัตถุประสงค์ - เทมเพลตช่วยลดเวลาในการออกแบบและเพิ่มความเป็นมืออาชีพ ✅ การใช้งานเทมเพลตใน Google Workspace - เทมเพลตใหม่สามารถใช้งานได้ใน Google Workspace ทั้งบัญชีธุรกิจและบัญชีส่วนตัว - ผู้ใช้งานต้องตั้งค่าภาษาเป็น "English (United States)" เพื่อเข้าถึงเทมเพลต ✅ การเปิดตัวเทมเพลตใหม่ในเดือนเมษายน 2025 - เริ่มต้นใน Rapid Release domains และจะขยายไปยัง Scheduled Release domains ตั้งแต่วันที่ 6 พฤษภาคม ✅ การออกแบบที่ครอบคลุมการใช้งานหลากหลาย - เทมเพลตครอบคลุมการใช้งาน เช่น การนำเสนอแผนธุรกิจ การเสนอขายผลิตภัณฑ์ และการเฉลิมฉลองความสำเร็จ https://www.neowin.net/news/google-slides-gets-more-high-quality-templates-to-elevate-your-presentations/WWW.NEOWIN.NETGoogle Slides gets more 'high-quality' templates to 'elevate your presentations'Google has started rolling out a new set of "high-quality" templates available for Google Slides users.0 Comments 0 Shares 249 Views 0 Reviews - Microsoft ได้ปรับปรุงความสามารถของ Copilot ใน Word เพื่อเพิ่มประสิทธิภาพในการอ้างอิงข้อมูล โดยผู้ใช้งานสามารถอ้างอิงข้อมูลจากเอกสารขนาดใหญ่และโฟลเดอร์ทั้งหมดได้ ซึ่งช่วยให้การสร้างและตรวจสอบเอกสารมีความยืดหยุ่นมากขึ้น การอัปเดตนี้ยังรวมถึงการรองรับเอกสารที่มีความยาวสูงสุดถึง 1.5 ล้านคำ หรือ 3,000 หน้า และการอ้างอิงไฟล์ได้สูงสุด 20 รายการ ในฟีเจอร์ Draft with Copilot

การอ้างอิงข้อมูลจากโฟลเดอร์ทั้งหมด

- ผู้ใช้งานสามารถอ้างอิงข้อมูลจากโฟลเดอร์ใน OneDrive หรือ SharePoint

- หากโฟลเดอร์มีไฟล์มากกว่า 10 ไฟล์ Copilot จะเลือกอ้างอิงจากไฟล์ล่าสุด 10 ไฟล์

รองรับเอกสารขนาดใหญ่และการอ้างอิงหลายไฟล์

- รองรับเอกสารที่มีความยาวสูงสุด 1.5 ล้านคำหรือ 3,000 หน้า

- สามารถอ้างอิงไฟล์ได้สูงสุด 20 รายการในฟีเจอร์ Draft with Copilot

การปรับปรุงฟีเจอร์อื่นๆ ใน Word

- การจัดการโน้ตเสียง (voice notes) ที่ดีขึ้น

- การถอดเสียงเป็นเทมเพลตที่สร้างไว้ล่วงหน้าหรือแบบกำหนดเอง

การเปิดตัวฟีเจอร์ใน Word for the Web

- ฟีเจอร์การอ้างอิงโฟลเดอร์พร้อมใช้งานใน Word for the Web แล้ว

- การรองรับเอกสารขนาดใหญ่และการอ้างอิงหลายไฟล์จะพร้อมใช้งานในเดือนเมษายน 2025

https://www.neowin.net/news/microsoft-now-lets-you-reference-massive-documents-and-entire-folders-in-word/Microsoft ได้ปรับปรุงความสามารถของ Copilot ใน Word เพื่อเพิ่มประสิทธิภาพในการอ้างอิงข้อมูล โดยผู้ใช้งานสามารถอ้างอิงข้อมูลจากเอกสารขนาดใหญ่และโฟลเดอร์ทั้งหมดได้ ซึ่งช่วยให้การสร้างและตรวจสอบเอกสารมีความยืดหยุ่นมากขึ้น การอัปเดตนี้ยังรวมถึงการรองรับเอกสารที่มีความยาวสูงสุดถึง 1.5 ล้านคำ หรือ 3,000 หน้า และการอ้างอิงไฟล์ได้สูงสุด 20 รายการ ในฟีเจอร์ Draft with Copilot ✅ การอ้างอิงข้อมูลจากโฟลเดอร์ทั้งหมด - ผู้ใช้งานสามารถอ้างอิงข้อมูลจากโฟลเดอร์ใน OneDrive หรือ SharePoint - หากโฟลเดอร์มีไฟล์มากกว่า 10 ไฟล์ Copilot จะเลือกอ้างอิงจากไฟล์ล่าสุด 10 ไฟล์ ✅ รองรับเอกสารขนาดใหญ่และการอ้างอิงหลายไฟล์ - รองรับเอกสารที่มีความยาวสูงสุด 1.5 ล้านคำหรือ 3,000 หน้า - สามารถอ้างอิงไฟล์ได้สูงสุด 20 รายการในฟีเจอร์ Draft with Copilot ✅ การปรับปรุงฟีเจอร์อื่นๆ ใน Word - การจัดการโน้ตเสียง (voice notes) ที่ดีขึ้น - การถอดเสียงเป็นเทมเพลตที่สร้างไว้ล่วงหน้าหรือแบบกำหนดเอง ✅ การเปิดตัวฟีเจอร์ใน Word for the Web - ฟีเจอร์การอ้างอิงโฟลเดอร์พร้อมใช้งานใน Word for the Web แล้ว - การรองรับเอกสารขนาดใหญ่และการอ้างอิงหลายไฟล์จะพร้อมใช้งานในเดือนเมษายน 2025 https://www.neowin.net/news/microsoft-now-lets-you-reference-massive-documents-and-entire-folders-in-word/WWW.NEOWIN.NETMicrosoft now lets you reference massive documents and entire folders in WordMicrosoft is making some changes to Copilot in Word, allowing you to reference entire folders and much larger documents.0 Comments 0 Shares 158 Views 0 Reviews - YouTube TV กำลังจะมีการปรับปรุงครั้งใหญ่ในปีนี้ โดยมีการออกแบบ UI ใหม่เพื่อเพิ่มความสะดวกในการใช้งาน รวมถึงฟีเจอร์ Multiview ที่ช่วยให้ผู้ใช้งานสามารถดูหลายช่องพร้อมกันได้ นอกจากนี้ YouTube Music ยังเปิดตัวฟีเจอร์ใหม่ที่ใช้ AI ในการสร้างสถานีวิทยุส่วนตัว และ YouTube Premium เพิ่มตัวเลือกความเร็วในการเล่นวิดีโอสูงสุดถึง 4x บนมือถือ

การออกแบบ UI ใหม่ใน YouTube TV

- เพิ่มการนำทางที่ง่ายขึ้นและการควบคุมการเล่นที่ดีขึ้น

- เพิ่มการเข้าถึงความคิดเห็นและข้อมูลช่อง รวมถึงการสมัครสมาชิก

ฟีเจอร์ Multiview ที่ปรับปรุงใหม่

- ผู้ใช้งานสามารถสร้าง Multiview ของตัวเองได้ โดยเริ่มจากช่องยอดนิยมบางช่อง

- ก่อนหน้านี้ Multiview จำกัดเฉพาะเนื้อหากีฬาและการจัดวางที่เลือกโดย YouTube TV

ฟีเจอร์ AI ใน YouTube Music

- ฟีเจอร์ Ask Music ช่วยสร้างสถานีวิทยุส่วนตัวตามคำอธิบายของผู้ใช้งาน

- ฟีเจอร์นี้เปิดให้ใช้งานใน iOS และ Android สำหรับผู้ใช้ YouTube Premium และ YouTube Music

การเพิ่มตัวเลือกความเร็วในการเล่นวิดีโอใน YouTube Premium

- รองรับความเร็วในการเล่นสูงสุดถึง 4x บนมือถือ

ฟีเจอร์ใหม่สำหรับผู้สร้างเนื้อหา

- ผู้สร้างสามารถตอบความคิดเห็นด้วยโน้ตเสียง ซึ่งจะเปิดตัวให้ผู้สร้างมากขึ้นในปีนี้

https://www.neowin.net/news/youtube-tv-is-getting-a-redesign-and-multiview-later-this-year/YouTube TV กำลังจะมีการปรับปรุงครั้งใหญ่ในปีนี้ โดยมีการออกแบบ UI ใหม่เพื่อเพิ่มความสะดวกในการใช้งาน รวมถึงฟีเจอร์ Multiview ที่ช่วยให้ผู้ใช้งานสามารถดูหลายช่องพร้อมกันได้ นอกจากนี้ YouTube Music ยังเปิดตัวฟีเจอร์ใหม่ที่ใช้ AI ในการสร้างสถานีวิทยุส่วนตัว และ YouTube Premium เพิ่มตัวเลือกความเร็วในการเล่นวิดีโอสูงสุดถึง 4x บนมือถือ ✅ การออกแบบ UI ใหม่ใน YouTube TV - เพิ่มการนำทางที่ง่ายขึ้นและการควบคุมการเล่นที่ดีขึ้น - เพิ่มการเข้าถึงความคิดเห็นและข้อมูลช่อง รวมถึงการสมัครสมาชิก ✅ ฟีเจอร์ Multiview ที่ปรับปรุงใหม่ - ผู้ใช้งานสามารถสร้าง Multiview ของตัวเองได้ โดยเริ่มจากช่องยอดนิยมบางช่อง - ก่อนหน้านี้ Multiview จำกัดเฉพาะเนื้อหากีฬาและการจัดวางที่เลือกโดย YouTube TV ✅ ฟีเจอร์ AI ใน YouTube Music - ฟีเจอร์ Ask Music ช่วยสร้างสถานีวิทยุส่วนตัวตามคำอธิบายของผู้ใช้งาน - ฟีเจอร์นี้เปิดให้ใช้งานใน iOS และ Android สำหรับผู้ใช้ YouTube Premium และ YouTube Music ✅ การเพิ่มตัวเลือกความเร็วในการเล่นวิดีโอใน YouTube Premium - รองรับความเร็วในการเล่นสูงสุดถึง 4x บนมือถือ ✅ ฟีเจอร์ใหม่สำหรับผู้สร้างเนื้อหา - ผู้สร้างสามารถตอบความคิดเห็นด้วยโน้ตเสียง ซึ่งจะเปิดตัวให้ผู้สร้างมากขึ้นในปีนี้ https://www.neowin.net/news/youtube-tv-is-getting-a-redesign-and-multiview-later-this-year/WWW.NEOWIN.NETYouTube TV is getting a redesign and multiview later this yearYouTube, in its blog post celebrating its 20th anniversary, announced new features, including a TV app redesign coming this summer.0 Comments 0 Shares 365 Views 0 Reviews - Discord ได้ประกาศการเปลี่ยนแปลงครั้งสำคัญในตำแหน่งผู้นำ โดย Jason Citron ผู้ร่วมก่อตั้งและ CEO จะก้าวลงจากตำแหน่งในวันที่ 28 เมษายน 2025 และ Humam Sakhnini จะเข้ามารับตำแหน่ง CEO คนใหม่ Sakhnini มีประสบการณ์ในอุตสาหกรรมเกมจากการทำงานที่ Activision Blizzard และ King Digital ซึ่งเป็นจุดเด่นที่เหมาะสมกับทิศทางของ Discord ในการเตรียมตัวสำหรับการเติบโตในอนาคต

Citron จะยังคงมีบทบาทในบริษัทในฐานะที่ปรึกษาและสมาชิกคณะกรรมการบริหาร โดยเขาได้กล่าวถึงการตัดสินใจครั้งนี้ว่าเป็นการส่งต่อภารกิจให้กับผู้นำที่มีประสบการณ์เฉพาะด้านเพื่อช่วยให้ Discord ก้าวไปสู่บทใหม่ของการเติบโต

Jason Citron ก้าวลงจากตำแหน่ง CEO

- Citron จะยังคงมีบทบาทในฐานะที่ปรึกษาและสมาชิกคณะกรรมการบริหาร

- เขาเน้นว่าการเปลี่ยนแปลงนี้จะช่วยเร่งการเติบโตของ Discord

Humam Sakhnini เข้ารับตำแหน่ง CEO คนใหม่

- Sakhnini มีประสบการณ์จาก Activision Blizzard และ King Digital

- การแต่งตั้งนี้เป็นส่วนหนึ่งของการเตรียมตัวสำหรับการเป็นบริษัทมหาชนในอนาคต

Discord ยังคงมุ่งเน้นการพัฒนาแพลตฟอร์มสำหรับเกมเมอร์

- มีการเปิดตัวฟีเจอร์ใหม่ เช่น PC overlay และการปรับปรุง UI

- Discord กำลังสำรวจวิธีการสร้างรายได้เพิ่มเติม เช่น การโฆษณาและการซื้อในแอป

https://www.neowin.net/news/discord-appoints-new-ceo-as-jason-citron-prepares-to-step-down/Discord ได้ประกาศการเปลี่ยนแปลงครั้งสำคัญในตำแหน่งผู้นำ โดย Jason Citron ผู้ร่วมก่อตั้งและ CEO จะก้าวลงจากตำแหน่งในวันที่ 28 เมษายน 2025 และ Humam Sakhnini จะเข้ามารับตำแหน่ง CEO คนใหม่ Sakhnini มีประสบการณ์ในอุตสาหกรรมเกมจากการทำงานที่ Activision Blizzard และ King Digital ซึ่งเป็นจุดเด่นที่เหมาะสมกับทิศทางของ Discord ในการเตรียมตัวสำหรับการเติบโตในอนาคต Citron จะยังคงมีบทบาทในบริษัทในฐานะที่ปรึกษาและสมาชิกคณะกรรมการบริหาร โดยเขาได้กล่าวถึงการตัดสินใจครั้งนี้ว่าเป็นการส่งต่อภารกิจให้กับผู้นำที่มีประสบการณ์เฉพาะด้านเพื่อช่วยให้ Discord ก้าวไปสู่บทใหม่ของการเติบโต ✅ Jason Citron ก้าวลงจากตำแหน่ง CEO - Citron จะยังคงมีบทบาทในฐานะที่ปรึกษาและสมาชิกคณะกรรมการบริหาร - เขาเน้นว่าการเปลี่ยนแปลงนี้จะช่วยเร่งการเติบโตของ Discord ✅ Humam Sakhnini เข้ารับตำแหน่ง CEO คนใหม่ - Sakhnini มีประสบการณ์จาก Activision Blizzard และ King Digital - การแต่งตั้งนี้เป็นส่วนหนึ่งของการเตรียมตัวสำหรับการเป็นบริษัทมหาชนในอนาคต ✅ Discord ยังคงมุ่งเน้นการพัฒนาแพลตฟอร์มสำหรับเกมเมอร์ - มีการเปิดตัวฟีเจอร์ใหม่ เช่น PC overlay และการปรับปรุง UI - Discord กำลังสำรวจวิธีการสร้างรายได้เพิ่มเติม เช่น การโฆษณาและการซื้อในแอป https://www.neowin.net/news/discord-appoints-new-ceo-as-jason-citron-prepares-to-step-down/WWW.NEOWIN.NETDiscord appoints new CEO as Jason Citron prepares to step downAfter almost a decade as Discord's CEO, Jason Citron is stepping down, and a replacement will take over in the next few days.0 Comments 0 Shares 236 Views 0 Reviews - Amazon ได้เปิดตัว EC2 Graviton4-based instances รุ่นใหม่ที่มาพร้อมกับ NVMe SSD storage ซึ่งเป็นการพัฒนาครั้งสำคัญในด้านประสิทธิภาพและความสามารถของระบบคลาวด์ โดยมีการเพิ่มประสิทธิภาพในหลายด้าน เช่น การประมวลผล การจัดเก็บข้อมูล และการวิเคราะห์ข้อมูลแบบเรียลไทม์

การเปิดตัว EC2 Graviton4-based instances

- มีสามรุ่น ได้แก่ C8gd (compute optimized), M8gd (general purpose) และ R8gd (memory optimized)

- มาพร้อมกับ NVMe SSD storage ที่เพิ่มความเร็วในการจัดเก็บข้อมูล

ประสิทธิภาพที่เพิ่มขึ้นเมื่อเทียบกับ Graviton3

- การประมวลผลทั่วไปเร็วขึ้นถึง 30%

- การทำงานของฐานข้อมูลที่ใช้การจัดเก็บข้อมูลหนักเร็วขึ้นถึง 40%

- การวิเคราะห์ข้อมูลแบบเรียลไทม์เร็วขึ้นถึง 20%

ความสามารถในการรองรับงานที่ใหญ่ขึ้น

- รองรับ vCPUs สูงสุดถึง 192 และหน่วยความจำสูงสุด 1.5 TiB

- พื้นที่จัดเก็บข้อมูลสูงสุด 11.4TB และแบนด์วิดท์เครือข่ายสูงสุด 50 Gbps

การออกแบบที่เน้นความปลอดภัยและประสิทธิภาพ

- ใช้ AWS Nitro System ที่ช่วยเพิ่มความปลอดภัยและลดภาระงานของระบบเสมือน

การใช้งานที่เหมาะสม

- เหมาะสำหรับแอปพลิเคชันที่ใช้ Linux และเครื่องมืออย่าง Amazon EKS หรือ Docker

https://www.neowin.net/news/amazon-announces-new-ec2-graviton4-based-instances-with-nvme-ssd-storage/Amazon ได้เปิดตัว EC2 Graviton4-based instances รุ่นใหม่ที่มาพร้อมกับ NVMe SSD storage ซึ่งเป็นการพัฒนาครั้งสำคัญในด้านประสิทธิภาพและความสามารถของระบบคลาวด์ โดยมีการเพิ่มประสิทธิภาพในหลายด้าน เช่น การประมวลผล การจัดเก็บข้อมูล และการวิเคราะห์ข้อมูลแบบเรียลไทม์ ✅ การเปิดตัว EC2 Graviton4-based instances - มีสามรุ่น ได้แก่ C8gd (compute optimized), M8gd (general purpose) และ R8gd (memory optimized) - มาพร้อมกับ NVMe SSD storage ที่เพิ่มความเร็วในการจัดเก็บข้อมูล ✅ ประสิทธิภาพที่เพิ่มขึ้นเมื่อเทียบกับ Graviton3 - การประมวลผลทั่วไปเร็วขึ้นถึง 30% - การทำงานของฐานข้อมูลที่ใช้การจัดเก็บข้อมูลหนักเร็วขึ้นถึง 40% - การวิเคราะห์ข้อมูลแบบเรียลไทม์เร็วขึ้นถึง 20% ✅ ความสามารถในการรองรับงานที่ใหญ่ขึ้น - รองรับ vCPUs สูงสุดถึง 192 และหน่วยความจำสูงสุด 1.5 TiB - พื้นที่จัดเก็บข้อมูลสูงสุด 11.4TB และแบนด์วิดท์เครือข่ายสูงสุด 50 Gbps ✅ การออกแบบที่เน้นความปลอดภัยและประสิทธิภาพ - ใช้ AWS Nitro System ที่ช่วยเพิ่มความปลอดภัยและลดภาระงานของระบบเสมือน ✅ การใช้งานที่เหมาะสม - เหมาะสำหรับแอปพลิเคชันที่ใช้ Linux และเครื่องมืออย่าง Amazon EKS หรือ Docker https://www.neowin.net/news/amazon-announces-new-ec2-graviton4-based-instances-with-nvme-ssd-storage/WWW.NEOWIN.NETAmazon announces new EC2 Graviton4-based instances with NVMe SSD storageAmazon has announced new EC2 instances powered by its custom Graviton4 ARM processors and NVMe SSD storage for better cloud performance.0 Comments 0 Shares 128 Views 0 Reviews - Google ได้เปิดตัวฟีเจอร์ Data Classification Labels สำหรับ Gmail ซึ่งช่วยให้องค์กรสามารถจัดการและปกป้องข้อมูลที่สำคัญได้อย่างมีประสิทธิภาพ โดยฟีเจอร์นี้ช่วยให้ผู้ดูแลระบบสามารถกำหนดกฎการป้องกันข้อมูล เช่น การป้องกันไม่ให้ส่งอีเมลที่มีข้อมูลภายในออกนอกองค์กร หรือการติดป้ายกำกับ "Confidential" ให้กับข้อความที่มีข้อมูลสำคัญโดยอัตโนมัติ

ฟีเจอร์ Data Classification Labels พร้อมใช้งานใน Gmail

- ช่วยให้องค์กรสามารถจัดการข้อมูลสำคัญด้วยการติดป้ายกำกับ

- ป้ายกำกับสามารถกำหนดได้ทั้งแบบกำหนดเองและแบบที่ใช้ร่วมกับ Google Drive

การปรับปรุงฟีเจอร์ตั้งแต่ช่วง Beta

- เพิ่มการติดป้ายกำกับอัตโนมัติผ่านกฎ Data Loss Prevention (DLP)

- เพิ่มฟีเจอร์ "Sensitive Content Snippets" เพื่อแจ้งเตือนผู้ใช้งานเกี่ยวกับเนื้อหาที่ถูกตั้งกฎ

การรองรับการใช้งานบนมือถือ

- ฟีเจอร์นี้รองรับทั้ง Android และ iOS เพื่อให้การป้องกันข้อมูลครอบคลุมทุกอุปกรณ์

การจัดการผ่าน Admin Console

- ผู้ดูแลระบบสามารถเปิดใช้งานฟีเจอร์นี้ในระดับโดเมน กลุ่ม หรือผู้ใช้งานรายบุคคล

https://www.neowin.net/news/data-classifications-labels-for-gmail-leaves-open-beta-now-generally-available/Google ได้เปิดตัวฟีเจอร์ Data Classification Labels สำหรับ Gmail ซึ่งช่วยให้องค์กรสามารถจัดการและปกป้องข้อมูลที่สำคัญได้อย่างมีประสิทธิภาพ โดยฟีเจอร์นี้ช่วยให้ผู้ดูแลระบบสามารถกำหนดกฎการป้องกันข้อมูล เช่น การป้องกันไม่ให้ส่งอีเมลที่มีข้อมูลภายในออกนอกองค์กร หรือการติดป้ายกำกับ "Confidential" ให้กับข้อความที่มีข้อมูลสำคัญโดยอัตโนมัติ ✅ ฟีเจอร์ Data Classification Labels พร้อมใช้งานใน Gmail - ช่วยให้องค์กรสามารถจัดการข้อมูลสำคัญด้วยการติดป้ายกำกับ - ป้ายกำกับสามารถกำหนดได้ทั้งแบบกำหนดเองและแบบที่ใช้ร่วมกับ Google Drive ✅ การปรับปรุงฟีเจอร์ตั้งแต่ช่วง Beta - เพิ่มการติดป้ายกำกับอัตโนมัติผ่านกฎ Data Loss Prevention (DLP) - เพิ่มฟีเจอร์ "Sensitive Content Snippets" เพื่อแจ้งเตือนผู้ใช้งานเกี่ยวกับเนื้อหาที่ถูกตั้งกฎ ✅ การรองรับการใช้งานบนมือถือ - ฟีเจอร์นี้รองรับทั้ง Android และ iOS เพื่อให้การป้องกันข้อมูลครอบคลุมทุกอุปกรณ์ ✅ การจัดการผ่าน Admin Console - ผู้ดูแลระบบสามารถเปิดใช้งานฟีเจอร์นี้ในระดับโดเมน กลุ่ม หรือผู้ใช้งานรายบุคคล https://www.neowin.net/news/data-classifications-labels-for-gmail-leaves-open-beta-now-generally-available/WWW.NEOWIN.NETData classifications labels for Gmail leaves open beta, now generally availableData classification labels are handy for organizing sensitive emails. Now, Google has made them widely available for Gmail customers.0 Comments 0 Shares 413 Views 0 Reviews - NovelAI ได้เปิดตัวโมเดลใหม่ที่ชื่อว่า Diffusion V4 Full ซึ่งเป็นการพัฒนาครั้งสำคัญในด้านการสร้างภาพด้วย AI โดยโมเดลนี้มีความสามารถในการสร้างภาพที่มีรายละเอียดสูง รองรับการสร้างภาพหลายตัวละคร และมีฟีเจอร์ใหม่ที่ช่วยให้ผู้ใช้งานสามารถปรับแต่งภาพได้อย่างแม่นยำ เช่น การแก้ไขเฉพาะจุด (Focused Inpainting) และการเพิ่มข้อความในภาพ นอกจากนี้ยังมีฟีเจอร์ Vibe Transfer ที่ช่วยให้ผู้ใช้งานสามารถแชร์สไตล์ของภาพหนึ่งไปยังอีกภาพหนึ่งได้

การสร้างภาพหลายตัวละคร

- รองรับการสร้างภาพที่มีตัวละครสูงสุดถึง 6 ตัว โดยแต่ละตัวมีความชัดเจนและไม่ซ้อนทับกัน

- ผู้ใช้งานสามารถกำหนดตำแหน่งและการกระทำของตัวละครในภาพได้

การแก้ไขเฉพาะจุด (Focused Inpainting)

- ช่วยให้ผู้ใช้งานสามารถแก้ไขหรือปรับปรุงส่วนต่างๆ ของภาพ เช่น การเพิ่มรายละเอียดใบหน้า

การเพิ่มข้อความในภาพ

- รองรับการเพิ่มข้อความที่อ่านง่าย เช่น ฟองคำพูด ป้ายชื่อ และข้อความในภาพ

ฟีเจอร์ Vibe Transfer

- ช่วยให้ผู้ใช้งานสามารถแชร์สไตล์ของภาพหนึ่งไปยังอีกภาพหนึ่ง เช่น การปรับแสงและสี

การปรับปรุงคุณภาพของภาพ

- ใช้เทคโนโลยี Flux VAE เพื่อเพิ่มความคมชัดและรายละเอียดของภาพ

https://computercity.com/artificial-intelligence/novelai-launches-powerful-diffusion-v4-full-model-with-multi-character-supportNovelAI ได้เปิดตัวโมเดลใหม่ที่ชื่อว่า Diffusion V4 Full ซึ่งเป็นการพัฒนาครั้งสำคัญในด้านการสร้างภาพด้วย AI โดยโมเดลนี้มีความสามารถในการสร้างภาพที่มีรายละเอียดสูง รองรับการสร้างภาพหลายตัวละคร และมีฟีเจอร์ใหม่ที่ช่วยให้ผู้ใช้งานสามารถปรับแต่งภาพได้อย่างแม่นยำ เช่น การแก้ไขเฉพาะจุด (Focused Inpainting) และการเพิ่มข้อความในภาพ นอกจากนี้ยังมีฟีเจอร์ Vibe Transfer ที่ช่วยให้ผู้ใช้งานสามารถแชร์สไตล์ของภาพหนึ่งไปยังอีกภาพหนึ่งได้ ✅ การสร้างภาพหลายตัวละคร - รองรับการสร้างภาพที่มีตัวละครสูงสุดถึง 6 ตัว โดยแต่ละตัวมีความชัดเจนและไม่ซ้อนทับกัน - ผู้ใช้งานสามารถกำหนดตำแหน่งและการกระทำของตัวละครในภาพได้ ✅ การแก้ไขเฉพาะจุด (Focused Inpainting) - ช่วยให้ผู้ใช้งานสามารถแก้ไขหรือปรับปรุงส่วนต่างๆ ของภาพ เช่น การเพิ่มรายละเอียดใบหน้า ✅ การเพิ่มข้อความในภาพ - รองรับการเพิ่มข้อความที่อ่านง่าย เช่น ฟองคำพูด ป้ายชื่อ และข้อความในภาพ ✅ ฟีเจอร์ Vibe Transfer - ช่วยให้ผู้ใช้งานสามารถแชร์สไตล์ของภาพหนึ่งไปยังอีกภาพหนึ่ง เช่น การปรับแสงและสี ✅ การปรับปรุงคุณภาพของภาพ - ใช้เทคโนโลยี Flux VAE เพื่อเพิ่มความคมชัดและรายละเอียดของภาพ https://computercity.com/artificial-intelligence/novelai-launches-powerful-diffusion-v4-full-model-with-multi-character-supportCOMPUTERCITY.COMNovelAI Launches Powerful Diffusion V4 Full Model with Multi-Character SupportNovelAI is an innovative tool designed to help authors create literature. It is a form of artificial intelligence that generates human-like writing. People of0 Comments 0 Shares 371 Views 0 Reviews - Microsoft ได้ประกาศยุติการสนับสนุน Cortana ซึ่งเป็นผู้ช่วย AI ที่เปิดตัวครั้งแรกในปี 2014 โดย Cortana เคยเป็นส่วนสำคัญของระบบปฏิบัติการ Windows และแอปพลิเคชันต่างๆ ของ Microsoft อย่างไรก็ตาม การเปลี่ยนแปลงในตลาด AI และการมุ่งเน้นไปที่เทคโนโลยีใหม่ เช่น Microsoft Copilot ทำให้ Cortana ถูกแทนที่ด้วยเครื่องมือที่มีความสามารถมากขึ้น

Cortana เปิดตัวครั้งแรกในปี 2014

- เปิดตัวพร้อมกับ Windows Phone 8.1 และได้รับแรงบันดาลใจจากตัวละครในเกม Halo

- มีฟีเจอร์เด่น เช่น การสั่งงานด้วยเสียง การตั้งค่าการแจ้งเตือน และการควบคุมอุปกรณ์สมาร์ทโฮม

เหตุผลที่ Microsoft ยุติการสนับสนุน Cortana

- การแข่งขันที่รุนแรงจาก Siri, Google Assistant และ Alexa

- Cortana ไม่สามารถแข่งขันในตลาดมือถือได้ เนื่องจาก Windows Phone ไม่ประสบความสำเร็จ

- การเปลี่ยนกลยุทธ์ไปสู่การรวมฟีเจอร์ AI ใน Microsoft 365 และ Windows

การแทนที่ด้วย Microsoft Copilot

- Copilot ใช้เทคโนโลยี GPT-4 เพื่อช่วยสร้างเนื้อหา สรุปอีเมล และทำงานอัตโนมัติ

- มีความสามารถที่เหนือกว่า Cortana เช่น การเขียนรายงานและตอบคำถามที่ซับซ้อน

การเปลี่ยนแปลงในตลาดผู้ช่วย AI

- ผู้ช่วย AI ในยุคใหม่เน้นการสร้างภาษาและการรวมเข้ากับเครื่องมือผลิตภาพ

https://computercity.com/software/windows/goodbye-cortana-why-microsoft-pulled-the-plug-on-its-ai-assistantMicrosoft ได้ประกาศยุติการสนับสนุน Cortana ซึ่งเป็นผู้ช่วย AI ที่เปิดตัวครั้งแรกในปี 2014 โดย Cortana เคยเป็นส่วนสำคัญของระบบปฏิบัติการ Windows และแอปพลิเคชันต่างๆ ของ Microsoft อย่างไรก็ตาม การเปลี่ยนแปลงในตลาด AI และการมุ่งเน้นไปที่เทคโนโลยีใหม่ เช่น Microsoft Copilot ทำให้ Cortana ถูกแทนที่ด้วยเครื่องมือที่มีความสามารถมากขึ้น ✅ Cortana เปิดตัวครั้งแรกในปี 2014 - เปิดตัวพร้อมกับ Windows Phone 8.1 และได้รับแรงบันดาลใจจากตัวละครในเกม Halo - มีฟีเจอร์เด่น เช่น การสั่งงานด้วยเสียง การตั้งค่าการแจ้งเตือน และการควบคุมอุปกรณ์สมาร์ทโฮม ✅ เหตุผลที่ Microsoft ยุติการสนับสนุน Cortana - การแข่งขันที่รุนแรงจาก Siri, Google Assistant และ Alexa - Cortana ไม่สามารถแข่งขันในตลาดมือถือได้ เนื่องจาก Windows Phone ไม่ประสบความสำเร็จ - การเปลี่ยนกลยุทธ์ไปสู่การรวมฟีเจอร์ AI ใน Microsoft 365 และ Windows ✅ การแทนที่ด้วย Microsoft Copilot - Copilot ใช้เทคโนโลยี GPT-4 เพื่อช่วยสร้างเนื้อหา สรุปอีเมล และทำงานอัตโนมัติ - มีความสามารถที่เหนือกว่า Cortana เช่น การเขียนรายงานและตอบคำถามที่ซับซ้อน ✅ การเปลี่ยนแปลงในตลาดผู้ช่วย AI - ผู้ช่วย AI ในยุคใหม่เน้นการสร้างภาษาและการรวมเข้ากับเครื่องมือผลิตภาพ https://computercity.com/software/windows/goodbye-cortana-why-microsoft-pulled-the-plug-on-its-ai-assistantCOMPUTERCITY.COMGoodbye, Cortana: Why Microsoft Pulled the Plug on Its AI AssistantMicrosoft’s once-promising virtual assistant, Cortana, has reached the end of the road. Originally introduced in 2014 as a bold step into the AI assistant0 Comments 0 Shares 245 Views 0 Reviews - บทความนี้แนะนำการสร้างและเลือกซื้อพีซีสำหรับการเล่นเกม 4K ในปี 2025 โดยเน้นการเลือกส่วนประกอบที่เหมาะสมเพื่อให้ได้ประสิทธิภาพสูงสุดในราคาที่คุ้มค่า มีการแนะนำพีซีในสามระดับ ได้แก่ Enthusiast Build, Mid-Range Build และ Budget Build ซึ่งเหมาะสำหรับผู้เล่นที่มีงบประมาณและความต้องการที่แตกต่างกัน

Enthusiast Build: สำหรับผู้เล่นที่ต้องการประสิทธิภาพสูงสุด

- ใช้ CPU Intel Core Ultra 9 285K และ GPU Asus ROG Astral OC GeForce RTX 5090

- รองรับการเล่นเกม 4K ที่ 240Hz พร้อม ray tracing

Mid-Range Build: สมดุลระหว่างประสิทธิภาพและราคา

- ใช้ CPU AMD Ryzen 7 9800X3D และ GPU PNY OC GeForce RTX 5080

- เหมาะสำหรับการเล่นเกม 4K ที่ 60–120 FPS

Budget Build: สำหรับผู้เล่นที่มีงบประมาณจำกัด

- ใช้ CPU AMD Ryzen 7 9800X3D และ GPU ASRock Steel Legend Radeon RX 9070 XT

- รองรับการเล่นเกม 4K บน high settings

คำแนะนำเพิ่มเติมสำหรับการสร้างพีซี

- ใช้ RAM อย่างน้อย 32GB และเลือก SSD PCIe 5.0 เพื่อการโหลดเกมที่รวดเร็ว

- เลือกจอภาพ 4K ที่มี refresh rate 120Hz ขึ้นไป

https://computercity.com/desktops/best-4k-gaming-pcบทความนี้แนะนำการสร้างและเลือกซื้อพีซีสำหรับการเล่นเกม 4K ในปี 2025 โดยเน้นการเลือกส่วนประกอบที่เหมาะสมเพื่อให้ได้ประสิทธิภาพสูงสุดในราคาที่คุ้มค่า มีการแนะนำพีซีในสามระดับ ได้แก่ Enthusiast Build, Mid-Range Build และ Budget Build ซึ่งเหมาะสำหรับผู้เล่นที่มีงบประมาณและความต้องการที่แตกต่างกัน ✅ Enthusiast Build: สำหรับผู้เล่นที่ต้องการประสิทธิภาพสูงสุด - ใช้ CPU Intel Core Ultra 9 285K และ GPU Asus ROG Astral OC GeForce RTX 5090 - รองรับการเล่นเกม 4K ที่ 240Hz พร้อม ray tracing ✅ Mid-Range Build: สมดุลระหว่างประสิทธิภาพและราคา - ใช้ CPU AMD Ryzen 7 9800X3D และ GPU PNY OC GeForce RTX 5080 - เหมาะสำหรับการเล่นเกม 4K ที่ 60–120 FPS ✅ Budget Build: สำหรับผู้เล่นที่มีงบประมาณจำกัด - ใช้ CPU AMD Ryzen 7 9800X3D และ GPU ASRock Steel Legend Radeon RX 9070 XT - รองรับการเล่นเกม 4K บน high settings ✅ คำแนะนำเพิ่มเติมสำหรับการสร้างพีซี - ใช้ RAM อย่างน้อย 32GB และเลือก SSD PCIe 5.0 เพื่อการโหลดเกมที่รวดเร็ว - เลือกจอภาพ 4K ที่มี refresh rate 120Hz ขึ้นไป https://computercity.com/desktops/best-4k-gaming-pcCOMPUTERCITY.COMBest 4K Gaming PC Builds to Elevate Your Gaming Experience in 2025Gaming in 4K isn’t just about higher resolution—it’s about unleashing the full potential of modern graphics, frame rates, and immersive detail. In 2025, 4K0 Comments 0 Shares 260 Views 0 Reviews - บทความนี้กล่าวถึงการเดินทางขององค์กรต่างๆ ในการนำแนวทาง Zero Trust มาใช้เพื่อเพิ่มความปลอดภัยทางไซเบอร์ โดย Zero Trust เป็นแนวคิดที่ไม่ไว้วางใจบุคคลหรือระบบใดๆ ทั้งภายในและภายนอกองค์กร และต้องมีการตรวจสอบสิทธิ์และการเข้าถึงอย่างต่อเนื่อง แม้ว่าองค์กรส่วนใหญ่จะเริ่มต้นใช้งาน Zero Trust แต่ยังมีความท้าทายด้านวัฒนธรรมและเทคโนโลยีที่ต้องเผชิญ

Zero Trust เป็นแนวทางที่เน้นการตรวจสอบสิทธิ์และการเข้าถึงอย่างต่อเนื่อง

- องค์กรต้องตรวจสอบสิทธิ์และการเข้าถึงทุกครั้ง แม้จะอยู่ภายในเครือข่าย

- การนำ Zero Trust มาใช้ช่วยลดความเสี่ยงจากการโจมตีทางไซเบอร์

องค์กรส่วนใหญ่เริ่มต้นใช้งาน Zero Trust

- 63% ขององค์กรทั่วโลกมีการนำ Zero Trust มาใช้ในบางส่วน

- 58% ขององค์กรยังอยู่ในขั้นตอนเริ่มต้น โดยครอบคลุมเพียง 50% ของระบบ

การเปลี่ยนแปลงวัฒนธรรมองค์กรเป็นสิ่งสำคัญ

- การนำ Zero Trust มาใช้ต้องการการเปลี่ยนแปลงวัฒนธรรมและกระบวนการ

- การสนับสนุนจากผู้บริหารระดับสูงช่วยให้การเปลี่ยนแปลงเป็นไปอย่างราบรื่น

การจัดการความสมดุลระหว่างความปลอดภัยและการใช้งาน

- Zero Trust อาจเพิ่มความยุ่งยากในการใช้งาน แต่ช่วยเพิ่มความปลอดภัย

- การสร้างกลุ่มผู้ใช้งานเพื่อรับฟังความคิดเห็นช่วยลดผลกระทบต่อประสบการณ์ผู้ใช้งาน

การสร้างกรอบการทำงานเพื่อช่วยในการนำ Zero Trust มาใช้

- การใช้กรอบการทำงานช่วยให้องค์กรสามารถจัดการโครงการได้อย่างมีประสิทธิภาพ

- กรอบการทำงานช่วยประเมินความสามารถในการป้องกันและตอบสนองต่อภัยคุกคาม

https://www.csoonline.com/article/3965399/security-leaders-shed-light-on-their-zero-trust-journeys.htmlบทความนี้กล่าวถึงการเดินทางขององค์กรต่างๆ ในการนำแนวทาง Zero Trust มาใช้เพื่อเพิ่มความปลอดภัยทางไซเบอร์ โดย Zero Trust เป็นแนวคิดที่ไม่ไว้วางใจบุคคลหรือระบบใดๆ ทั้งภายในและภายนอกองค์กร และต้องมีการตรวจสอบสิทธิ์และการเข้าถึงอย่างต่อเนื่อง แม้ว่าองค์กรส่วนใหญ่จะเริ่มต้นใช้งาน Zero Trust แต่ยังมีความท้าทายด้านวัฒนธรรมและเทคโนโลยีที่ต้องเผชิญ ✅ Zero Trust เป็นแนวทางที่เน้นการตรวจสอบสิทธิ์และการเข้าถึงอย่างต่อเนื่อง - องค์กรต้องตรวจสอบสิทธิ์และการเข้าถึงทุกครั้ง แม้จะอยู่ภายในเครือข่าย - การนำ Zero Trust มาใช้ช่วยลดความเสี่ยงจากการโจมตีทางไซเบอร์ ✅ องค์กรส่วนใหญ่เริ่มต้นใช้งาน Zero Trust - 63% ขององค์กรทั่วโลกมีการนำ Zero Trust มาใช้ในบางส่วน - 58% ขององค์กรยังอยู่ในขั้นตอนเริ่มต้น โดยครอบคลุมเพียง 50% ของระบบ ✅ การเปลี่ยนแปลงวัฒนธรรมองค์กรเป็นสิ่งสำคัญ - การนำ Zero Trust มาใช้ต้องการการเปลี่ยนแปลงวัฒนธรรมและกระบวนการ - การสนับสนุนจากผู้บริหารระดับสูงช่วยให้การเปลี่ยนแปลงเป็นไปอย่างราบรื่น ✅ การจัดการความสมดุลระหว่างความปลอดภัยและการใช้งาน - Zero Trust อาจเพิ่มความยุ่งยากในการใช้งาน แต่ช่วยเพิ่มความปลอดภัย - การสร้างกลุ่มผู้ใช้งานเพื่อรับฟังความคิดเห็นช่วยลดผลกระทบต่อประสบการณ์ผู้ใช้งาน ✅ การสร้างกรอบการทำงานเพื่อช่วยในการนำ Zero Trust มาใช้ - การใช้กรอบการทำงานช่วยให้องค์กรสามารถจัดการโครงการได้อย่างมีประสิทธิภาพ - กรอบการทำงานช่วยประเมินความสามารถในการป้องกันและตอบสนองต่อภัยคุกคาม https://www.csoonline.com/article/3965399/security-leaders-shed-light-on-their-zero-trust-journeys.htmlWWW.CSOONLINE.COMSecurity leaders shed light on their zero trust journeysMost CISOs recognize the improved security posture zero trust will bring. But cultural and technological changes make for an arduous path that takes business savvy and technical acumen to navigate.0 Comments 0 Shares 256 Views 0 Reviews - บทความนี้กล่าวถึง Cloud-Native Application Protection Platforms (CNAPPs) ซึ่งเป็นเครื่องมือที่ช่วยเพิ่มความปลอดภัยในระบบคลาวด์ โดย CNAPPs รวมฟังก์ชันจากเครื่องมือ 4 ประเภท ได้แก่ CIEM, CWPP, CASB, และ CSPM เพื่อสร้างโซลูชันที่ครอบคลุมมากขึ้น นอกจากนี้ยังมีการขยายฟังก์ชันไปยังด้านอื่นๆ เช่น API Security, Container Security, และ Infrastructure-as-Code (IaC) Security

CNAPPs รวมฟังก์ชันจากเครื่องมือ 4 ประเภท

- CIEM: จัดการการเข้าถึงและความเสี่ยง

- CWPP: ปกป้องโค้ดในระบบคลาวด์และการทำงานใน runtime

- CASB: จัดการการยืนยันตัวตนและการเข้ารหัส

- CSPM: รวมข้อมูลภัยคุกคามและการแก้ไข

การขยายฟังก์ชันไปยังด้านอื่นๆ

- ครอบคลุม API Security, Container Security, และ IaC Security

- รองรับการจัดการข้อมูลและแอปพลิเคชัน SaaS

การพัฒนา CNAPPs อย่างรวดเร็ว

- CNAPPs ช่วยลดข้อผิดพลาดในการตั้งค่าระบบและเพิ่มความปลอดภัยใน pipeline การพัฒนา

- ใช้ AI เพื่อปรับปรุงการตรวจจับภัยคุกคามและการแก้ไข

การเปลี่ยนแปลงในตลาด CNAPPs

- Google ซื้อ Wiz และ Check Point Software ยุติการขาย CloudGuard CNAPP

- Fortinet ซื้อ Lacework และเปลี่ยนชื่อเป็น FortiCNAPP

https://www.csoonline.com/article/573629/cnapp-buyers-guide-top-tools-compared.htmlบทความนี้กล่าวถึง Cloud-Native Application Protection Platforms (CNAPPs) ซึ่งเป็นเครื่องมือที่ช่วยเพิ่มความปลอดภัยในระบบคลาวด์ โดย CNAPPs รวมฟังก์ชันจากเครื่องมือ 4 ประเภท ได้แก่ CIEM, CWPP, CASB, และ CSPM เพื่อสร้างโซลูชันที่ครอบคลุมมากขึ้น นอกจากนี้ยังมีการขยายฟังก์ชันไปยังด้านอื่นๆ เช่น API Security, Container Security, และ Infrastructure-as-Code (IaC) Security ✅ CNAPPs รวมฟังก์ชันจากเครื่องมือ 4 ประเภท - CIEM: จัดการการเข้าถึงและความเสี่ยง - CWPP: ปกป้องโค้ดในระบบคลาวด์และการทำงานใน runtime - CASB: จัดการการยืนยันตัวตนและการเข้ารหัส - CSPM: รวมข้อมูลภัยคุกคามและการแก้ไข ✅ การขยายฟังก์ชันไปยังด้านอื่นๆ - ครอบคลุม API Security, Container Security, และ IaC Security - รองรับการจัดการข้อมูลและแอปพลิเคชัน SaaS ✅ การพัฒนา CNAPPs อย่างรวดเร็ว - CNAPPs ช่วยลดข้อผิดพลาดในการตั้งค่าระบบและเพิ่มความปลอดภัยใน pipeline การพัฒนา - ใช้ AI เพื่อปรับปรุงการตรวจจับภัยคุกคามและการแก้ไข ✅ การเปลี่ยนแปลงในตลาด CNAPPs - Google ซื้อ Wiz และ Check Point Software ยุติการขาย CloudGuard CNAPP - Fortinet ซื้อ Lacework และเปลี่ยนชื่อเป็น FortiCNAPP https://www.csoonline.com/article/573629/cnapp-buyers-guide-top-tools-compared.htmlWWW.CSOONLINE.COMCNAPP buyer’s guide: Top cloud-native app protection platforms comparedCloud-native application protection platforms (CNAPPs) aim to provide a complete cloud security solution, but some are more complete than others.0 Comments 0 Shares 281 Views 0 Reviews - TSMC ได้เปิดตัวเทคโนโลยีใหม่ที่เรียกว่า System on Wafer-X ซึ่งช่วยให้สามารถรวมชิปประมวลผลขนาดใหญ่ได้ถึง 16 ตัวในแพ็กเกจเดียว พร้อมทั้งชิปหน่วยความจำและการเชื่อมต่อแบบออปติคัลที่รวดเร็ว เทคโนโลยีนี้ออกแบบมาเพื่อรองรับการใช้งานที่ต้องการพลังประมวลผลสูง เช่น ปัญญาประดิษฐ์ (AI) และการวิเคราะห์ข้อมูลขนาดใหญ่ นอกจากนี้ TSMC ยังประกาศแผนการสร้างโรงงานใหม่ในรัฐแอริโซนา สหรัฐอเมริกา เพื่อรองรับการผลิตชิปที่ใช้เทคโนโลยีนี้

System on Wafer-X ช่วยเพิ่มประสิทธิภาพการประมวลผล

- สามารถรวมชิปประมวลผลขนาดใหญ่ได้ถึง 16 ตัวในแพ็กเกจเดียว

- รองรับการใช้งานที่ต้องการพลังประมวลผลสูง เช่น AI และการวิเคราะห์ข้อมูล

เทคโนโลยี A14 จะเปิดตัวในปี 2028

- ช่วยเพิ่มความเร็วของชิปได้ถึง 15% หรือประหยัดพลังงานได้ถึง 30% เมื่อเทียบกับชิป N2

แผนการสร้างโรงงานใหม่ในรัฐแอริโซนา

- TSMC วางแผนสร้างโรงงาน 6 แห่ง รวมถึงโรงงานบรรจุภัณฑ์และศูนย์วิจัยและพัฒนา

การแข่งขันในตลาดชิปประมวลผล

- Intel กำลังพัฒนาเทคโนโลยีใหม่เพื่อแข่งขันกับ TSMC

https://www.thestar.com.my/tech/tech-news/2025/04/24/tsmc-shows-off-new-tech-for-stitching-together-bigger-faster-chipsTSMC ได้เปิดตัวเทคโนโลยีใหม่ที่เรียกว่า System on Wafer-X ซึ่งช่วยให้สามารถรวมชิปประมวลผลขนาดใหญ่ได้ถึง 16 ตัวในแพ็กเกจเดียว พร้อมทั้งชิปหน่วยความจำและการเชื่อมต่อแบบออปติคัลที่รวดเร็ว เทคโนโลยีนี้ออกแบบมาเพื่อรองรับการใช้งานที่ต้องการพลังประมวลผลสูง เช่น ปัญญาประดิษฐ์ (AI) และการวิเคราะห์ข้อมูลขนาดใหญ่ นอกจากนี้ TSMC ยังประกาศแผนการสร้างโรงงานใหม่ในรัฐแอริโซนา สหรัฐอเมริกา เพื่อรองรับการผลิตชิปที่ใช้เทคโนโลยีนี้ ✅ System on Wafer-X ช่วยเพิ่มประสิทธิภาพการประมวลผล - สามารถรวมชิปประมวลผลขนาดใหญ่ได้ถึง 16 ตัวในแพ็กเกจเดียว - รองรับการใช้งานที่ต้องการพลังประมวลผลสูง เช่น AI และการวิเคราะห์ข้อมูล ✅ เทคโนโลยี A14 จะเปิดตัวในปี 2028 - ช่วยเพิ่มความเร็วของชิปได้ถึง 15% หรือประหยัดพลังงานได้ถึง 30% เมื่อเทียบกับชิป N2 ✅ แผนการสร้างโรงงานใหม่ในรัฐแอริโซนา - TSMC วางแผนสร้างโรงงาน 6 แห่ง รวมถึงโรงงานบรรจุภัณฑ์และศูนย์วิจัยและพัฒนา ✅ การแข่งขันในตลาดชิปประมวลผล - Intel กำลังพัฒนาเทคโนโลยีใหม่เพื่อแข่งขันกับ TSMC https://www.thestar.com.my/tech/tech-news/2025/04/24/tsmc-shows-off-new-tech-for-stitching-together-bigger-faster-chipsWWW.THESTAR.COM.MYTSMC shows off new tech for stitching together bigger, faster chipsSANTA CLARA, California (Reuters) -Taiwan Semiconductor Manufacturing Co on Wednesday unveiled technology for making faster chips and putting them together in dinner-plate-sized packages that will boost performance needed for artificial intelligence applications.0 Comments 0 Shares 236 Views 0 Reviews - IBM ได้ประกาศว่ามีสัญญากับรัฐบาลสหรัฐฯ จำนวน 15 ฉบับที่ถูกยกเลิก เนื่องจากนโยบายลดค่าใช้จ่ายของรัฐบาลทรัมป์ ซึ่งส่งผลกระทบต่อธุรกิจที่ปรึกษาของ IBM อย่างไรก็ตาม บริษัทได้รายงานผลประกอบการไตรมาสแรกที่ดีกว่าคาดการณ์ และยังคงเป้าหมายการเติบโตของรายได้อย่างน้อย 5% ในปี 2025

สัญญากับรัฐบาลสหรัฐฯ ถูกยกเลิก 15 ฉบับ

- สัญญาที่ถูกยกเลิกมีมูลค่ารวมประมาณ 100 ล้านดอลลาร์

- คิดเป็นน้อยกว่า 1% ของงานที่ค้างอยู่ในหน่วยธุรกิจที่ปรึกษาของ IBM

ผลประกอบการไตรมาสแรกที่ดีกว่าคาดการณ์

- รายได้เพิ่มขึ้น 1% เป็น 14.5 พันล้านดอลลาร์

- กำไรต่อหุ้นปรับปรุงอยู่ที่ 1.60 ดอลลาร์ สูงกว่าคาดการณ์ที่ 1.40 ดอลลาร์

การเติบโตในธุรกิจซอฟต์แวร์ที่มีอัตรากำไรสูง

- IBM มีรายได้จากธุรกิจ AI มากกว่า 6 พันล้านดอลลาร์

การให้คำแนะนำรายได้ไตรมาสที่สอง

- คาดการณ์รายได้ระหว่าง 16.40 ถึง 16.75 พันล้านดอลลาร์

https://www.thestar.com.my/tech/tech-news/2025/04/24/ibm-forecasts-second-quarter-revenue-above-estimates-soothing-tariff-worriesIBM ได้ประกาศว่ามีสัญญากับรัฐบาลสหรัฐฯ จำนวน 15 ฉบับที่ถูกยกเลิก เนื่องจากนโยบายลดค่าใช้จ่ายของรัฐบาลทรัมป์ ซึ่งส่งผลกระทบต่อธุรกิจที่ปรึกษาของ IBM อย่างไรก็ตาม บริษัทได้รายงานผลประกอบการไตรมาสแรกที่ดีกว่าคาดการณ์ และยังคงเป้าหมายการเติบโตของรายได้อย่างน้อย 5% ในปี 2025 ✅ สัญญากับรัฐบาลสหรัฐฯ ถูกยกเลิก 15 ฉบับ - สัญญาที่ถูกยกเลิกมีมูลค่ารวมประมาณ 100 ล้านดอลลาร์ - คิดเป็นน้อยกว่า 1% ของงานที่ค้างอยู่ในหน่วยธุรกิจที่ปรึกษาของ IBM ✅ ผลประกอบการไตรมาสแรกที่ดีกว่าคาดการณ์ - รายได้เพิ่มขึ้น 1% เป็น 14.5 พันล้านดอลลาร์ - กำไรต่อหุ้นปรับปรุงอยู่ที่ 1.60 ดอลลาร์ สูงกว่าคาดการณ์ที่ 1.40 ดอลลาร์ ✅ การเติบโตในธุรกิจซอฟต์แวร์ที่มีอัตรากำไรสูง - IBM มีรายได้จากธุรกิจ AI มากกว่า 6 พันล้านดอลลาร์ ✅ การให้คำแนะนำรายได้ไตรมาสที่สอง - คาดการณ์รายได้ระหว่าง 16.40 ถึง 16.75 พันล้านดอลลาร์ https://www.thestar.com.my/tech/tech-news/2025/04/24/ibm-forecasts-second-quarter-revenue-above-estimates-soothing-tariff-worriesWWW.THESTAR.COM.MYIBM says 15 contracts impacted by DOGE cost cuts, shares drop(Reuters) -International Business Machines said 15 of its government contracts were shelved under a cost-cutting drive by the Trump administration, a setback that eclipsed its upbeat revenue forecast and dragged its shares down over 6% after hours.0 Comments 0 Shares 145 Views 0 Reviews - กฎหมายที่ถูกท้าทายนี้มีเป้าหมายป้องกันการเผยแพร่ข้อมูลเท็จที่ถูกสร้างขึ้นโดย AI เช่น รูปภาพ เสียง หรือวิดีโอที่ดูเหมือนจริง เพื่อใช้ในการโน้มน้าวประชาชนในการเลือกตั้ง หรือทำให้เกิดความเข้าใจผิดในทางการเมือง อย่างไรก็ตาม บริษัท X แย้งว่าการบังคับใช้กฎหมายดังกล่าวอาจก่อให้เกิดการเซ็นเซอร์ความคิดเห็นทางการเมือง

นอกจากนี้ยังมีข้อมูลว่า ณ ปัจจุบัน มีอย่างน้อย 22 รัฐในสหรัฐฯ ที่มีการออกกฎหมายควบคุมการใช้ดีพเฟคในเลือกตั้ง

บริษัท X ยื่นฟ้องรัฐมินนิโซตาเนื่องจากกฎหมายห้ามใช้ AI เพื่อสร้างดีพเฟคในการเลือกตั้ง

บริษัท X อ้างว่ากฎหมายดังกล่าวละเมิดสิทธิในการแสดงความคิดเห็นอย่างเสรี

X ขอให้ศาลประกาศว่ากฎหมายนี้ละเมิดรัฐธรรมนูญและขัดกับ Section 230 กฎหมายที่ปกป้องบริษัทสื่อสังคมจากการถูกฟ้องเรื่องเนื้อหาของผู้ใช้

https://www.thestar.com.my/tech/tech-news/2025/04/24/musk039s-x-sues-to-block-minnesota-039deepfake039-law-over-free-speech-concernsกฎหมายที่ถูกท้าทายนี้มีเป้าหมายป้องกันการเผยแพร่ข้อมูลเท็จที่ถูกสร้างขึ้นโดย AI เช่น รูปภาพ เสียง หรือวิดีโอที่ดูเหมือนจริง เพื่อใช้ในการโน้มน้าวประชาชนในการเลือกตั้ง หรือทำให้เกิดความเข้าใจผิดในทางการเมือง อย่างไรก็ตาม บริษัท X แย้งว่าการบังคับใช้กฎหมายดังกล่าวอาจก่อให้เกิดการเซ็นเซอร์ความคิดเห็นทางการเมือง นอกจากนี้ยังมีข้อมูลว่า ณ ปัจจุบัน มีอย่างน้อย 22 รัฐในสหรัฐฯ ที่มีการออกกฎหมายควบคุมการใช้ดีพเฟคในเลือกตั้ง ✅ บริษัท X ยื่นฟ้องรัฐมินนิโซตาเนื่องจากกฎหมายห้ามใช้ AI เพื่อสร้างดีพเฟคในการเลือกตั้ง ✅ บริษัท X อ้างว่ากฎหมายดังกล่าวละเมิดสิทธิในการแสดงความคิดเห็นอย่างเสรี ✅ X ขอให้ศาลประกาศว่ากฎหมายนี้ละเมิดรัฐธรรมนูญและขัดกับ Section 230 กฎหมายที่ปกป้องบริษัทสื่อสังคมจากการถูกฟ้องเรื่องเนื้อหาของผู้ใช้ https://www.thestar.com.my/tech/tech-news/2025/04/24/musk039s-x-sues-to-block-minnesota-039deepfake039-law-over-free-speech-concernsWWW.THESTAR.COM.MYMusk's X sues to block Minnesota 'deepfake' law over free speech concernsWILMINGTON, Delaware (Reuters) -Elon Musk's social media platform X sued Minnesota on Wednesday over a state law that bans people from using AI-generated "deepfakes" to influence an election, which the company said violated protections of free speech.0 Comments 0 Shares 239 Views 0 Reviews